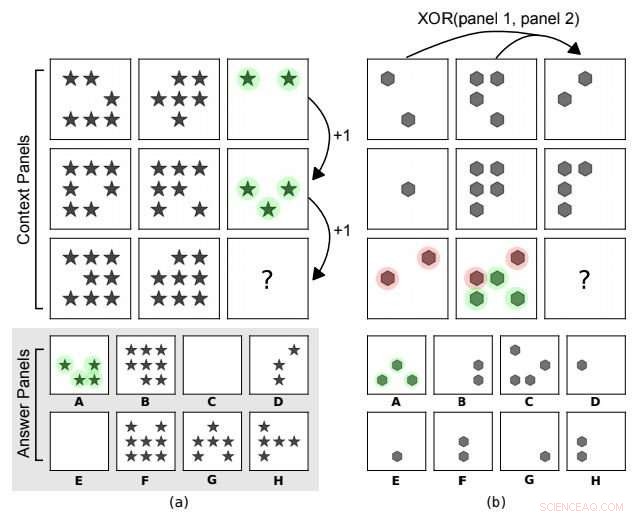

Matrici progressive in stile corvo. In (a) la regola astratta sottostante è una progressione aritmetica sul numero di forme lungo le colonne. In (b) esiste una relazione XOR sulle posizioni della forma lungo le righe (pannello 3 =XOR(pannello 1, pannello 2)). Altre caratteristiche come il tipo di forma non vengono prese in considerazione. A è la scelta corretta per entrambi. Attestazione:arXiv:1807.04225 [cs.LG]

test, test:DeepMind fa sedere l'intelligenza artificiale per un test del QI. Sebbene i risultati delle prestazioni dell'IA non siano sbalorditivi nel superare o abbinare il ragionamento umano, è un inizio. Gli scienziati dell'IA riconoscono che stabilire la loro capacità di ragionare su concetti astratti si è dimostrato difficile. DeepMind voleva vedere come potrebbe funzionare l'intelligenza artificiale e il team ha proposto un set di dati e una sfida per sondare il ragionamento astratto.

L'intelligenza artificiale può eguagliare le nostre capacità di ragionamento astratto? Le reti neurali profonde saranno in grado di risolvere meglio i problemi di ragionamento visivo astratto in futuro? I ricercatori di DeepMind si sono sicuramente occupati del caso.

La loro carta, "Misurare il ragionamento astratto nelle reti neurali, " è su arXiv. Gli autori sono David Barrett, Felice Hill, Adam Santoro, Ari Morcos, Timothy Lillicrap, da DeepMind. Puoi controllare cosa stavano cercando e come hanno testato. Il documento si concentra fondamentalmente su un approccio per misurare il ragionamento astratto nelle macchine per l'apprendimento. Nella loro discussione, la squadra ha detto, sì, ci sono stati progressi nel ragionamento e nell'apprendimento della rappresentazione astratta nelle reti neurali, ma la misura in cui questi modelli esibiscono qualcosa di simile al ragionamento astratto generale "è oggetto di molti dibattiti".

I modelli per avere successo hanno dovuto far fronte a regimi di generalizzazione in cui i dati di addestramento e di test differivano. Hanno affermato di presentare un'architettura con una struttura progettata per incoraggiare il ragionamento. Risultati:borsa mista. Dissero che il loro modello era abile in certe forme di generalizzazione, ma debole in altri.

Ciò nonostante, è interessante notare che hanno esplorato modi per misurare e suscitare un ragionamento astratto più forte nelle reti neurali.

"I test standard del QI umano spesso richiedono che gli esaminandi interpretino scene visive percettivamente semplici applicando principi che hanno appreso attraverso l'esperienza quotidiana, " ha affermato un blog di DeepMind. "Non abbiamo ancora i mezzi per esporre gli agenti di apprendimento automatico a un flusso simile di "esperienze quotidiane", il che significa che non possiamo misurare facilmente la loro capacità di trasferire la conoscenza dal mondo reale ai test di ragionamento visivo. Ciò nonostante, possiamo creare un set-up sperimentale che metta ancora a frutto i test di ragionamento visivo umano."

Hanno proceduto a costruire un generatore per problemi di matrice con un insieme di fattori astratti. Il team sta incoraggiando una maggiore ricerca nel ragionamento astratto, e hanno reso il loro set di dati pubblicamente disponibile.

La domanda generale è se gli scienziati possono raggiungere capacità di ragionamento analitico simili a quelle umane.

Mentre i risultati del loro test del QI avrebbero potuto essere un miscuglio, i ricercatori non vedono questo come un gioco per vincere o arrendersi. Continueranno il loro lavoro per esplorare strategie per migliorare la generalizzazione ed esplorare modelli futuri. Come CIO Dive osservato, "Agli assistenti intelligenti sono state fornite montagne di dati per aiutare i consumatori in quasi ogni area immaginabile, tuttavia, quando si presentano problemi sconosciuti, può ancora non essere all'altezza."

Gli autori hanno scritto, nel loro astratto, "proponiamo un set di dati e una sfida progettati per sondare il ragionamento astratto, ispirato da un noto test del QI umano. Per riuscire in questa sfida, i modelli devono far fronte a vari "regimi" di generalizzazione in cui i dati di addestramento e di test differiscono in modi chiaramente definiti. Dimostriamo che modelli popolari come ResNets hanno prestazioni scarse, anche quando i set di allenamento e di test differiscono solo in minima parte, e presentiamo una nuova architettura, con una struttura progettata per incoraggiare il ragionamento, che fa significativamente meglio."

CIO Dive descrissero i loro test come test del QI visivo. Nel processo, gli autori erano interessati a vedere le prestazioni nelle capacità di generalizzazione quando i dati dei test erano diversi.

Abbinare l'intelligenza artificiale alle capacità umane per l'astrazione continua a essere una battaglia in salita.

Come CIO Dive 's Alex Hickey ha scritto, L'intelligenza artificiale dovrebbe distinguere significati diversi tra "mangiare spaghetti al formaggio" e "mangiare spaghetti con i cani".

Il documento ha commentato che testare le capacità delle reti neurali può essere complicato e le reti neurali hanno le loro insidie, data la loro capacità di memorizzazione e capacità di sfruttare spunti statistici superficiali.

© 2018 Tech Xplore