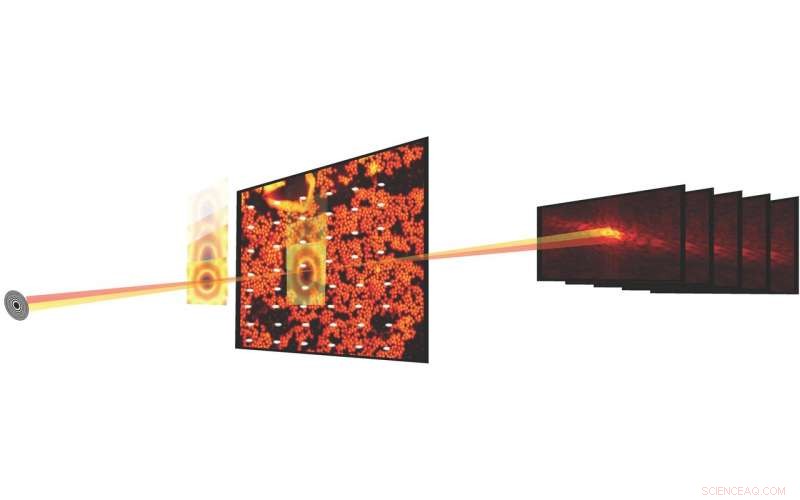

Negli esperimenti scientifici, l'imaging tticografico combina la microscopia a scansione con misurazioni di diffrazione per caratterizzare la struttura e le proprietà della materia e dei materiali. I progressi nei rivelatori e nei microscopi a raggi X alle sorgenti luminose hanno reso possibile ora misurare un set di dati tticoografico in pochi secondi. Crediti:Stefano Marchesini, Berkeley Lab

Quello che è iniziato quasi un decennio fa come una proposta di ricerca e sviluppo diretta dal laboratorio del Berkeley Lab (LDRD) è ora una realtà, e sta già cambiando il modo in cui gli scienziati eseguono esperimenti presso l'Advanced Light Source (ALS) e, infine, altre sorgenti luminose nel complesso del Dipartimento dell'Energia (DOE), consentendo lo streaming in tempo reale di dati di immagini tticoografiche in un ambiente di produzione.

Negli esperimenti scientifici, l'imaging tticografico combina la microscopia a scansione con misurazioni di diffrazione per caratterizzare la struttura e le proprietà della materia e dei materiali. Sebbene il metodo sia in circolazione da circa 50 anni, un ampio utilizzo è stato ostacolato dal fatto che il processo sperimentale è stato lento e l'elaborazione computazionale dei dati per produrre un'immagine ricostruita è stata costosa. Ma negli ultimi anni i progressi nei rivelatori e nei microscopi a raggi X a sorgenti luminose come la SLA hanno reso possibile misurare un set di dati tticoografico in pochi secondi.

Ricostruire set di dati tticoografici, però, non è cosa da poco; il processo comporta la risoluzione di un difficile problema di recupero delle fasi, calibrare gli elementi ottici e gestire i valori anomali sperimentali e il "rumore". Inserisci SHARP (tticografia in tempo reale adattabile eterogenea scalabile), un framework algoritmico e un software per computer che consente la ricostruzione di milioni di fasi di dati di immagine tticografica al secondo. Sviluppato presso Berkeley Lab attraverso una collaborazione internazionale e lanciato nel 2016, SHARP ha avuto un impatto dimostrabile sulla produttività per gli scienziati che lavorano presso l'ALS e altre fonti di luce nel complesso del Dipartimento dell'Energia.

Ora un'agenzia intergovernativa ha finanziato la collaborazione di scienziati del Center for Advanced Mathematics for Energy Research Applications (CAMERA) del Berkeley Lab, finanziato dal DOE, la SLA e lo STROBE, il Centro Scientifico e Tecnologico della National Science Foundation, ha prodotto un altro progresso unico nel suo genere per l'imaging tticografico:una pipeline software/algoritmica che consente lo streaming in tempo reale dei dati dell'immagine tticografica durante un esperimento della linea di luce, fornendo il throughput, compressione e risoluzione, nonché un rapido feedback per l'utente mentre l'esperimento è ancora in esecuzione.

integrato, modulare, Scalabile

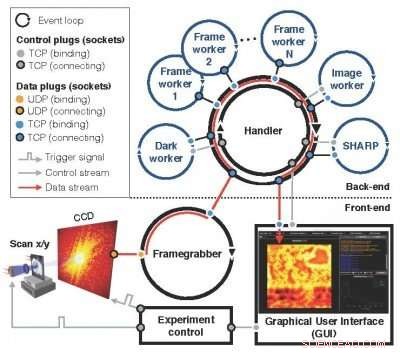

Un successore del concetto Nanosurveyor introdotto per la prima volta in una proposta LDRD del 2010, il modulare, il sistema scalabile Nanosurveyor II, ora attivo e funzionante presso l'ALS, utilizza un'infrastruttura a due lati che integra l'acquisizione dei dati delle immagini tticoografiche, pre-elaborazione, processi di trasmissione e visualizzazione. Il componente front-end sulla linea di luce comprende il rivelatore, acchiappa-frame, un preprocessore scalabile e un'interfaccia utente grafica (GUI), mentre il componente di back-end nel cluster di calcolo contiene SHARP per la ricostruzione di immagini ad alta risoluzione combinata con canali di comunicazione per il flusso di dati, istruzioni e sincronizzazione. In operazione, una volta che una nuova scansione è stata attivata dal controllo dell'esperimento, il frame-grabber riceve continuamente pacchetti di dati grezzi dalla fotocamera, li assembla ad un telaio e, in parallelo, preelabora una serie di frame non elaborati in un blocco pulito e ridotto per il back-end computazionale. I blocchi in entrata sono distribuiti tra i lavoratori SHARP nel back-end di calcolo, e i dati ridotti vengono inviati al front-end e visualizzati in una GUI. Il nuovo sistema software di streaming è in fase di implementazione presso l'ALS per l'uso attivo negli esperimenti sulle linee di luce, come la piattaforma di microscopia a raggi X COSMIC che è recentemente entrata in linea.

"Ciò che siamo riusciti a fare è rendere il flusso di lavoro dei dati e di calcolo molto complesso il più trasparente possibile, " ha detto David Shapiro, uno scienziato del personale nel gruppo di sistemi sperimentali presso l'ALS che è stato determinante nel facilitare l'implementazione e il test del nuovo sistema. "Una volta che il software è in funzione, gli operatori di microscopi non hanno idea che stanno generando gigabyte di dati e che passano attraverso questa pipeline e poi tornano a loro".

Gli utenti ALS in genere sono in grado di utilizzare le linee di luce per circa due giorni, durante il quale possono studiare una dozzina di campioni, ha notato Shapiro. Ciò significa che hanno solo poche ore per campione, e devono prendere una serie di decisioni sui dati entro quelle ore. La funzionalità di streaming pittografico in tempo reale fornisce loro un feedback in tempo reale e li aiuta a prendere decisioni più accurate.

Il modulare, il sistema scalabile Nanosurveyor II, ora attivo e funzionante presso l'ALS, utilizza un'infrastruttura a due lati che integra l'acquisizione dei dati delle immagini tticoografiche, pre-elaborazione, processi di trasmissione e visualizzazione. Credito:Lawrence Berkeley National Laboratory

"Il fatto che SHARP ora possa prendere i dati in tempo reale ed elaborarli immediatamente, anche se l'esperimento non è completo, lo rende ad alte prestazioni e operativo per la scienza in un ambiente di produzione, " disse Stefano Marchesini, uno scienziato CAMERA e il PI sulla proposta originale di LDRD.

Ambiente pronto per la produzione

L'integrazione di tutti i componenti è stata una delle maggiori sfide nell'implementazione di Nanosurveyor II, così come prepararlo per funzionare in un ambiente pronto per la produzione rispetto a un banco di prova, secondo Hari Krishnan, un ingegnere di sistemi informatici presso CAMERA che era responsabile dello sviluppo del motore di comunicazione della pipeline. Ci è voluto uno sforzo pluriennale per portare a compimento le capacità di elaborazione dei dati in tempo reale, con contributi di matematici, scienziati informatici, ingegneri del software, fisici e scienziati della linea di luce. Oltre a Marchesini e Krishnan, Gli scienziati CAMERA Pablo Enfedaque e Huibin Chang sono stati coinvolti nello sviluppo dell'interfaccia SHARP e del motore di comunicazione. Inoltre, Filipe Maia e Benedict Daurer dell'Università di Uppsala, che ha una collaborazione con CAMERA, ha giocato un ruolo fondamentale nello sviluppo del software di streaming. Nel frattempo, il fisico Bjoern Enders del Dipartimento di Fisica di Berkeley e STROBE si è concentrato sul rivelatore e sul preprocessore, e Berkeley Ph.D. in fisica. la studentessa Kasra Nowrouzi è stata coinvolta nell'implementazione della pipeline.

"Era importante separare le responsabilità e i compiti del sistema e quindi trovare un'interfaccia comune su cui comunicare, " Enders ha detto del lavoro di squadra. "Questo ha riportato parte della responsabilità sulla linea di trave. Tutti noi abbiamo lavorato insieme per separare in modo pulito l'algoritmo di streaming dalla parte di pre-elaborazione in modo da poter garantire che la linea di luce funzioni davvero".

Guardando avanti, La scalabilità di Nanosurveyor II sarà fondamentale quando la prossima generazione di sorgenti luminose e rilevatori sarà online. Le velocità dei dati della pipeline rispecchiano quelle del rilevatore; il rilevatore di corrente funziona a una velocità massima di 400 megabyte al secondo e può generare alcuni terabyte di dati al giorno. I rilevatori di nuova generazione produrranno dati da 100 a 1, 000 volte più veloce.

"La soluzione di streaming funziona alla stessa velocità dell'acquisizione dei dati a questo punto, " Ha detto Enfedaque. "È possibile ricostruire l'immagine tticografica alla velocità con cui i dati vengono catturati e pre-elaborati".

Inoltre, il team sta cercando di migliorare le capacità della pipeline incorporando algoritmi di apprendimento automatico in grado di automatizzare ulteriormente il processo di analisi dei dati.

"L'obiettivo è quello di renderlo senza soluzione di continuità, " Krishnan ha detto. "In questo momento ciò che gli utenti guardano è un'immagine grossolana per prendere decisioni rapide e un'immagine più fine per prendere decisioni più complesse. Alla fine vogliamo allontanarci del tutto dai fotogrammi e dai dati grezzi e finire in questo regno in cui tutte le decisioni e tutti i punti sono solo un'unica immagine ricostruita. Tutte queste altre cose intermedie scompaiono".

"La capacità di streaming dei dati porta l'analisi nella scala temporale del processo decisionale umano per gli operatori, ma facilita anche il futuro, che sarebbero macchine che prendono decisioni e guidano le misurazioni, "ha aggiunto Shapiro.