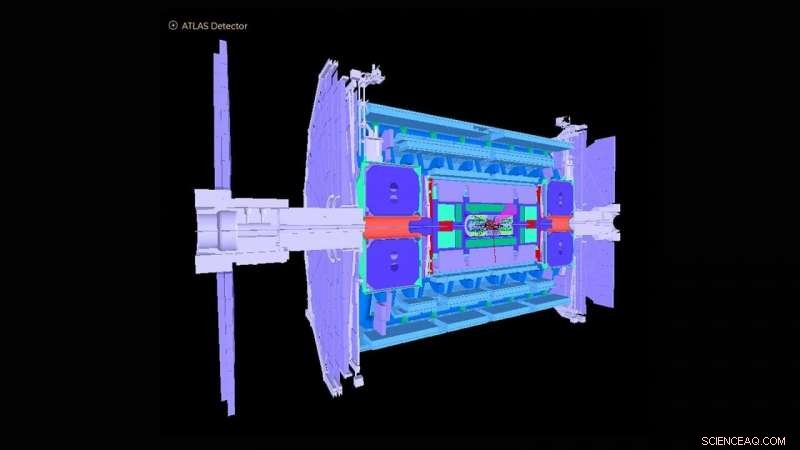

Schema del rivelatore ATLAS nel Large Hadron Collider. Credito:Collaborazione ATLAS

Il Large Hadron Collider (LHC) vicino a Ginevra, La Svizzera è diventata famosa in tutto il mondo nel 2012 con la scoperta del bosone di Higgs. L'osservazione ha segnato una conferma cruciale del Modello Standard della fisica delle particelle, che organizza le particelle subatomiche in gruppi simili agli elementi della tavola periodica della chimica.

L'Argonne National Laboratory del Dipartimento dell'Energia degli Stati Uniti (DOE) ha dato molti contributi fondamentali alla costruzione e al funzionamento del rivelatore sperimentale ATLAS all'LHC e all'analisi dei segnali registrati dal rivelatore che svelano la fisica sottostante delle collisioni di particelle. Argonne sta ora svolgendo un ruolo guida nell'aggiornamento ad alta luminosità del rivelatore ATLAS per le operazioni che dovrebbero iniziare nel 2027. A tal fine, un team di fisici e scienziati computazionali di Argonne ha ideato un algoritmo basato sull'apprendimento automatico che approssima il modo in cui il rilevatore attuale risponderebbe ai dati notevolmente aumentati previsti con l'aggiornamento.

Essendo la più grande macchina fisica mai costruita, l'LHC spara due fasci di protoni in direzioni opposte attorno a un anello di 17 miglia fino a quando non si avvicinano alla velocità della luce, li schiaccia insieme e analizza i prodotti di collisione con rivelatori giganteschi come ATLAS. Lo strumento ATLAS ha l'altezza di un edificio di sei piani e pesa circa 7, 000 tonnellate. Oggi, l'LHC continua a studiare il bosone di Higgs, oltre a rispondere a domande fondamentali su come e perché la materia nell'universo è così com'è.

"La maggior parte delle domande di ricerca presso ATLAS riguardano la ricerca di un ago in un gigantesco pagliaio, dove gli scienziati sono interessati solo a trovare un evento che si verifica tra un miliardo di altri, " ha detto Walter Hopkins, assistente fisico nella divisione di fisica delle alte energie (HEP) di Argonne.

Come parte dell'aggiornamento LHC, gli sforzi stanno ora progredendo per aumentare la luminosità dell'LHC - il numero di interazioni protone-protone per collisione dei due fasci di protoni - di un fattore cinque. Ciò produrrà circa 10 volte più dati all'anno rispetto a quelli attualmente acquisiti dagli esperimenti di LHC. Resta ancora da capire quanto bene i rivelatori rispondano a questo aumento della frequenza degli eventi. Ciò richiede l'esecuzione di simulazioni al computer ad alte prestazioni dei rilevatori per valutare con precisione i processi noti risultanti dalle collisioni di LHC. Queste simulazioni su larga scala sono costose e richiedono grandi quantità di tempo di calcolo sui supercomputer migliori e più potenti del mondo.

Il team di Argonne ha creato un algoritmo di apprendimento automatico che verrà eseguito come simulazione preliminare prima di qualsiasi simulazione su vasta scala. Questo algoritmo approssima, in modi molto veloci e meno costosi, come l'attuale rivelatore risponderebbe ai dati notevolmente aumentati previsti con l'aggiornamento. Implica la simulazione delle risposte del rivelatore a un esperimento di collisione di particelle e la ricostruzione di oggetti dai processi fisici. Questi oggetti ricostruiti includono getti o spruzzi di particelle, così come singole particelle come elettroni e muoni.

"La scoperta di nuova fisica all'LHC e altrove richiede metodi sempre più complessi per l'analisi dei big data, " ha detto Doug Benjamin, uno scienziato computazionale in HEP. "In questi giorni questo di solito significa l'uso dell'apprendimento automatico e di altre tecniche di intelligenza artificiale".

I metodi di analisi utilizzati in precedenza per le simulazioni iniziali non hanno impiegato algoritmi di apprendimento automatico e richiedono molto tempo perché comportano l'aggiornamento manuale dei parametri sperimentali quando cambiano le condizioni all'LHC. Alcuni potrebbero anche perdere importanti correlazioni di dati per un determinato insieme di variabili di input per un esperimento. L'algoritmo sviluppato da Argonne apprende, in tempo reale durante l'applicazione di una procedura di formazione, le varie funzionalità che devono essere introdotte attraverso dettagliate simulazioni complete, evitando così la necessità di elaborare manualmente i parametri sperimentali. Il metodo può anche catturare interdipendenze complesse di variabili che non erano possibili prima.

"Con la nostra simulazione ridotta, puoi apprendere le basi a costi e tempi di calcolo relativamente ridotti, quindi puoi procedere in modo molto più efficiente con simulazioni complete in un secondo momento, " ha affermato Hopkins. "Il nostro algoritmo di apprendimento automatico fornisce inoltre agli utenti un migliore potere discriminante su dove cercare eventi nuovi o rari in un esperimento, " Ha aggiunto.

L'algoritmo del team potrebbe rivelarsi prezioso non solo per ATLAS, ma per i rivelatori sperimentali multipli all'LHC, così come altri esperimenti di fisica delle particelle ora in corso in tutto il mondo.

Questo studio, intitolato "Simulazione del rivelatore automatizzato e parametrizzazione della ricostruzione mediante apprendimento automatico, " è apparso in Journal of Instrumentation .