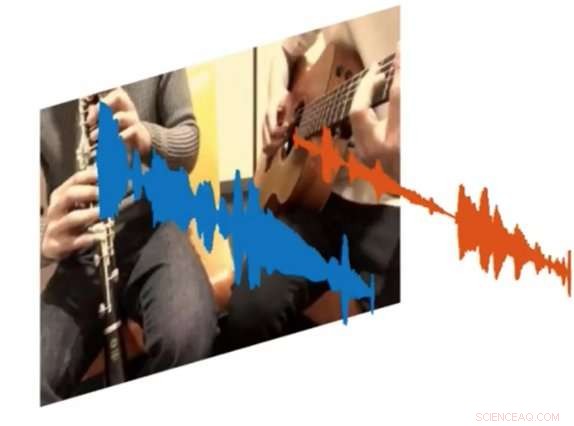

Un nuovo sistema di intelligenza artificiale chiamato PixelPlayer può guardare un'immagine e determinare quale set di pixel è responsabile della creazione di specifici set di onde sonore. Credito:MIT CSAIL

Sia i musicisti dilettanti che quelli professionisti possono passare ore a guardare le clip di YouTube per capire esattamente come riprodurre determinate parti delle loro canzoni preferite. E se ci fosse un modo per riprodurre un video e isolare l'unico strumento che volevi ascoltare?

Questo è il risultato di un nuovo progetto di intelligenza artificiale del Computer Science and Artificial Intelligence Laboratory (CSAIL) del MIT:un sistema di deep learning in grado di guardare un video di una performance musicale, e isolare i suoni di strumenti specifici e renderli più forti o più deboli.

Il sistema, che è "auto-sorvegliato, " non richiede annotazioni umane su cosa sono o come suonano gli strumenti.

Formazione su oltre 60 ore di video, il sistema "PixelPlayer" può visualizzare una performance musicale mai vista prima, identificare strumenti specifici a livello di pixel, ed estrarre i suoni associati a quegli strumenti.

Per esempio, può prendere un video di una tuba e una tromba che suonano la sigla di "Super Mario Brothers", e separare le onde sonore associate a ciascuno strumento.

I ricercatori affermano che la possibilità di modificare il volume dei singoli strumenti significa che in futuro, sistemi come questo potrebbero potenzialmente aiutare gli ingegneri a migliorare la qualità audio dei vecchi filmati di concerti. Potresti persino immaginare i produttori che prendono parti di strumenti specifici e visualizzano in anteprima come suonerebbero con altri strumenti (ad esempio una chitarra elettrica sostituita con una acustica).

In un nuovo documento, il team ha dimostrato che PixelPlayer può identificare i suoni di più di 20 strumenti comunemente visti. L'autore principale Hang Zhao afferma che il sistema sarebbe in grado di identificare molti più strumenti se avesse più dati di addestramento, sebbene possa ancora avere problemi a gestire le sottili differenze tra le sottoclassi di strumenti (come un sax contralto contro un tenore).

I precedenti sforzi per separare le fonti del suono si sono concentrati esclusivamente sull'audio, che spesso richiede un'ampia etichettatura umana. In contrasto, PixelPlayer introduce l'elemento della visione, che secondo i ricercatori rende superflue le etichette umane, poiché la visione fornisce l'autocontrollo.

Il sistema individua prima le regioni dell'immagine che producono suoni, e quindi separa i suoni in ingresso in un insieme di componenti che rappresentano il suono di ciascun pixel.

"Ci aspettavamo lo scenario migliore in cui potessimo riconoscere quali strumenti producono quali tipi di suoni, "dice Zhao, un dottorato di ricerca studente presso CSAIL. "Siamo rimasti sorpresi di poter effettivamente localizzare spazialmente gli strumenti a livello di pixel. Essere in grado di farlo apre molte possibilità, come poter modificare l'audio dei singoli strumenti con un solo clic sul video."

PixelPlayer utilizza metodi di "apprendimento profondo, " il che significa che trova modelli nei dati utilizzando le cosiddette "reti neurali" che sono state addestrate su video esistenti. In particolare, una rete neurale analizza le immagini del video, si analizza l'audio, e un terzo "sintetizzatore" associa pixel specifici con onde sonore specifiche per separare i diversi suoni.

PixelPlayer include anche un'interfaccia che consente agli utenti di modificare il volume di strumenti specifici nel mix. Credito:MIT CSAIL

Il fatto che PixelPlayer utilizzi il cosiddetto deep learning "auto-supervisionato" significa che il team del MIT non comprende esplicitamente ogni aspetto di come apprende quali strumenti producono quali suoni.

Però, Zhao dice che può dire che il sistema sembra riconoscere elementi reali della musica. Per esempio, certe frequenze armoniche sembrano essere correlate a strumenti come il violino, mentre i modelli rapidi simili a impulsi corrispondono a strumenti come lo xilofono.

Zhao afferma che un sistema come PixelPlayer potrebbe essere utilizzato anche sui robot per comprendere meglio i suoni ambientali prodotti da altri oggetti, come animali o veicoli.

Questa storia è stata ripubblicata per gentile concessione di MIT News (web.mit.edu/newsoffice/), un popolare sito che copre notizie sulla ricerca del MIT, innovazione e didattica.