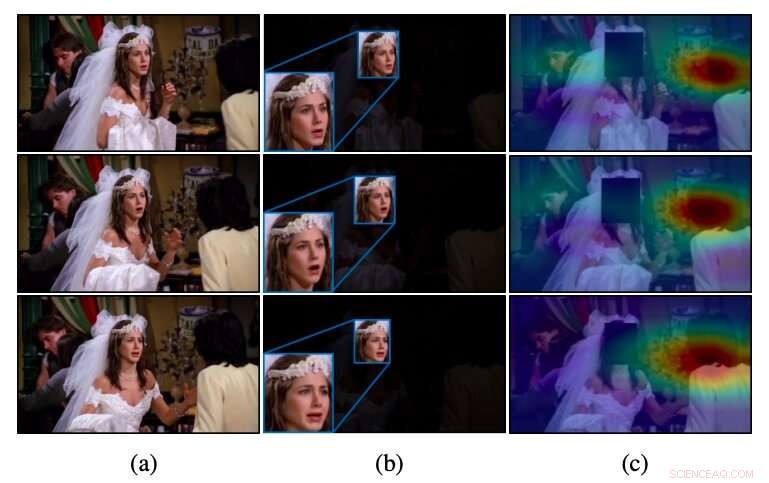

Intuizione di CAER-Net per video non tagliati, come in (a) metodi convenzionali che sfruttano solo le regioni facciali, come in (b), spesso non riconoscono le emozioni. A differenza di questi metodi, CAER-Net si concentra sia sulle regioni del viso che su quelle del contesto attento, come si vede in (c). Credito:Lee et al.

Un team di ricercatori della Yonsei University e dell'École Polytechnique Fédérale de Lausanne (EPFL) ha recentemente sviluppato una nuova tecnica in grado di riconoscere le emozioni analizzando i volti delle persone nelle immagini insieme alle caratteristiche contestuali. Hanno presentato e delineato la loro architettura basata sull'apprendimento profondo, chiamato CAER-Net, in un articolo pre-pubblicato su arXiv.

Per molti anni, ricercatori di tutto il mondo hanno cercato di sviluppare strumenti per rilevare automaticamente le emozioni umane analizzando immagini, video o clip audio. Questi strumenti potrebbero avere numerose applicazioni, ad esempio, migliorare le interazioni uomo-robot o aiutare i medici a identificare i segni di disturbi mentali o neurali (ad es. , basato su modelli di discorso atipici, caratteristiche facciali, eccetera.).

Finora, la maggior parte delle tecniche per riconoscere le emozioni nelle immagini si è basata sull'analisi delle espressioni facciali delle persone, essenzialmente supponendo che queste espressioni trasmettano meglio le risposte emotive degli umani. Di conseguenza, la maggior parte dei set di dati per la formazione e la valutazione degli strumenti di riconoscimento delle emozioni (ad es. i set di dati AFEW e FER2013) contengono solo immagini ritagliate di volti umani.

Un limite fondamentale degli strumenti convenzionali di riconoscimento delle emozioni è che non riescono a raggiungere prestazioni soddisfacenti quando i segnali emotivi sui volti delle persone sono ambigui o indistinguibili. In contrasto con questi approcci, gli esseri umani sono in grado di riconoscere le emozioni degli altri in base non solo alle loro espressioni facciali, ma anche su indizi contestuali (es. le azioni che stanno compiendo, le loro interazioni con gli altri, dove sono, eccetera.).

Studi precedenti suggeriscono che l'analisi sia delle espressioni facciali che delle caratteristiche legate al contesto può aumentare significativamente le prestazioni degli strumenti di riconoscimento delle emozioni. Ispirato da queste scoperte, i ricercatori di Yonsei e dell'EPFL hanno deciso di sviluppare un'architettura basata sull'apprendimento profondo in grado di riconoscere le emozioni delle persone nelle immagini basate sia sulle loro espressioni facciali che sulle informazioni contestuali.

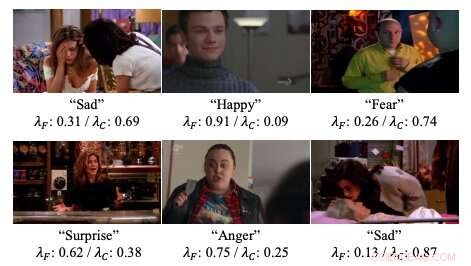

Esempi di pesi dell'attenzione nelle reti neurali sviluppate dai ricercatori. Credito:Lee et al.

"Vi presentiamo reti profonde per il riconoscimento delle emozioni sensibile al contesto, chiamato CAER-Net, che sfruttano non solo l'espressione facciale umana, ma anche informazioni di contesto, in modo congiunto e stimolante, "Hanno scritto i ricercatori nel loro articolo. "L'idea chiave è nascondere i volti umani in una scena visiva e cercare altri contesti basati su un meccanismo di attenzione".

CAER-Net, l'architettura sviluppata dai ricercatori, è composto da due sottoreti chiave e codificatori che estraggono separatamente le caratteristiche del viso e le regioni contestuali in un'immagine. Questi due tipi di caratteristiche vengono quindi combinati utilizzando reti di fusione adattive e analizzati insieme per prevedere le emozioni delle persone in una data immagine.

Oltre a CAER-Net, i ricercatori hanno anche introdotto un nuovo set di dati per il riconoscimento delle emozioni sensibile al contesto, che chiamano CAER. Le immagini in questo set di dati ritraggono sia i volti delle persone che il loro ambiente/contesto, quindi potrebbe servire come punto di riferimento più efficace per la formazione che valuta le tecniche di riconoscimento delle emozioni.

I ricercatori hanno valutato la loro tecnica di riconoscimento delle emozioni in una serie di esperimenti, utilizzando sia il set di dati che hanno compilato sia il set di dati AFEW. I loro risultati suggeriscono che l'analisi sia delle espressioni facciali che delle informazioni contestuali può aumentare considerevolmente le prestazioni degli strumenti di riconoscimento delle emozioni, come indicato da studi precedenti.

"Speriamo che i risultati di questo studio facilitino ulteriori progressi nel riconoscimento delle emozioni consapevole del contesto e dei relativi compiti, " hanno scritto i ricercatori.

© 2019 Scienza X Rete