Una collisione CMS simulata in cui viene prodotta una particella di lunga durata insieme ad altri getti "regolari". La particella a vita lunga viaggia per una breve distanza prima di decadere, creando particelle che appaiono spostate dal punto in cui i fasci di LHC si sono scontrati. Credito:CERN

Oggi, le reti neurali artificiali hanno un impatto su molte aree della nostra vita quotidiana. Sono utilizzati per un'ampia varietà di compiti complessi, come guidare automobili, eseguire il riconoscimento vocale (ad esempio, Siri, Cortana, Alexa), suggerendo articoli e tendenze per lo shopping, o migliorare gli effetti visivi nei film (ad es. personaggi animati come Thanos del film guerra infinita di Marvel).

Tradizionalmente, gli algoritmi sono realizzati a mano per risolvere compiti complessi. Ciò richiede agli esperti di dedicare una quantità significativa di tempo per identificare le strategie ottimali per varie situazioni. Le reti neurali artificiali, ispirate ai neuroni interconnessi nel cervello, possono apprendere automaticamente dai dati una soluzione quasi ottimale per un determinato obiettivo. Spesso, l'apprendimento automatizzato o la "formazione" necessaria per ottenere queste soluzioni è "sorvegliata" attraverso l'utilizzo di informazioni supplementari fornite da un esperto. Altri approcci sono "non supervisionati" e possono identificare modelli nei dati. La teoria matematica alla base delle reti neurali artificiali si è evoluta nel corso di diversi decenni, ma solo di recente abbiamo sviluppato la nostra comprensione di come addestrarli in modo efficiente. I calcoli richiesti sono molto simili a quelli eseguiti dalle schede grafiche video standard (che contengono un'unità di elaborazione grafica o GPU) durante il rendering di scene tridimensionali nei videogiochi. La capacità di addestrare reti neurali artificiali in un lasso di tempo relativamente breve è resa possibile sfruttando le capacità di calcolo massicciamente parallele delle GPU per uso generico. La fiorente industria dei videogiochi ha guidato lo sviluppo delle GPU. Questo avanzamento, insieme ai significativi progressi nella teoria dell'apprendimento automatico e al volume sempre crescente di informazioni digitalizzate, ha contribuito a inaugurare l'era dell'intelligenza artificiale e del "deep learning".

Nel campo della fisica delle alte energie, l'utilizzo di tecniche di machine learning, come semplici reti neurali o alberi decisionali, sono in uso da diversi decenni. Più recentemente, le comunità teoriche e sperimentali si rivolgono sempre più alle tecniche più avanzate, come architetture di reti neurali "profonde", per aiutarci a comprendere la natura fondamentale del nostro Universo. Il modello standard della fisica delle particelle è una raccolta coerente di leggi fisiche, espresse nel linguaggio della matematica, che governano le particelle e le forze fondamentali, che a loro volta spiegano la natura del nostro Universo visibile. Al CERN LHC, molti risultati scientifici si concentrano sulla ricerca di nuove particelle "esotiche" non previste dal modello standard. Queste ipotetiche particelle sono le manifestazioni di nuove teorie che mirano a rispondere a domande come:perché l'Universo è composto prevalentemente da materia piuttosto che da antimateria, o qual è la natura della materia oscura?

Figura 1:Schema dell'architettura di rete. Le sezioni superiori (arancione e blu) del diagramma illustrano i componenti della rete che vengono utilizzati per distinguere i getti prodotti nei decadimenti delle particelle a vita lunga dai getti prodotti con altri mezzi, addestrato con dati simulati. La parte inferiore (verde) del diagramma mostra i componenti addestrati utilizzando dati di collisione reali. Credito:CERN

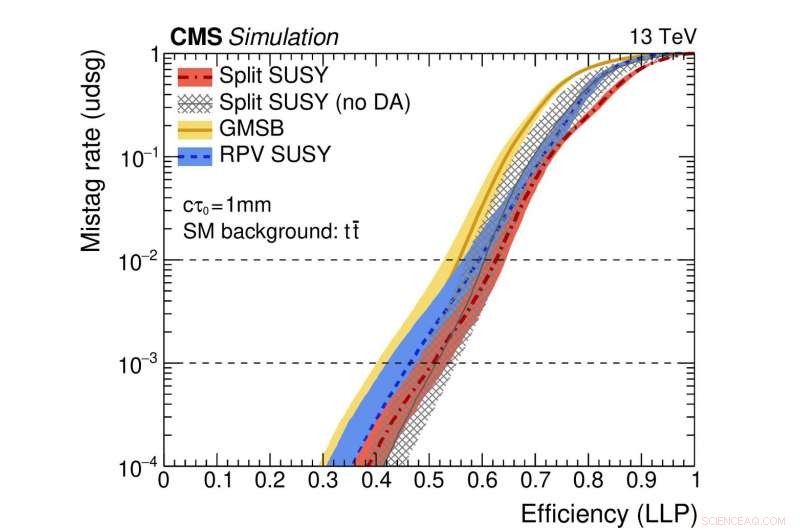

Figura 2:Un'illustrazione delle prestazioni della rete. Le curve colorate rappresentano le prestazioni di diversi modelli teorici supersimmetrici. L'asse orizzontale fornisce l'efficienza per identificare correttamente un decadimento di particelle di lunga durata (cioè il tasso di veri positivi). L'asse verticale mostra il corrispondente tasso di falsi positivi, che è la frazione di getti standard erroneamente identificata come originata dal decadimento di una particella a vita lunga. Come esempio, usiamo un punto della curva rossa in cui la frazione di particelle autentiche a lunga vita correttamente identificate è 0,5 (ovvero 50%). Questo metodo identifica erroneamente solo un getto regolare su mille come originato da un decadimento di particelle di lunga durata. Credito:CERN

Recentemente, particolare attenzione è stata riservata alla ricerca di nuove particelle che esistono per più di un fugace momento nel tempo prima di decadere in particelle ordinarie. Queste particelle "a vita lunga" possono percorrere distanze misurabili (frazioni di millimetri o più) dal punto di collisione protone-protone in ogni esperimento di LHC prima di decadere. Spesso, le previsioni teoriche presumono che la particella a vita lunga non sia rilevabile. In quel caso, solo le particelle del decadimento della particella sconosciuta lasceranno tracce nei sistemi di rilevamento, portando alla firma sperimentale piuttosto atipica di particelle che appaiono apparentemente dal nulla e spostate dal punto di collisione.

Un aspetto nuovo di questo studio prevede l'uso di dati provenienti da eventi di collisione reali, così come eventi simulati, per addestrare la rete. Questo approccio viene utilizzato perché la simulazione, sebbene molto sofisticata, non riproduce in modo esaustivo tutti i dettagli dei dati reali di collisione. In particolare, i getti derivanti da decadimenti di particelle di lunga durata sono difficili da simulare con precisione. L'effetto dell'applicazione di questa tecnica, soprannominato "adattamento di dominio, " è che le informazioni fornite dalla rete neurale concordano con un alto livello di precisione per i dati di collisione sia reali che simulati. Questo comportamento è un tratto cruciale per gli algoritmi che verranno utilizzati dalle ricerche di rari processi di nuova fisica, poiché gli algoritmi devono dimostrare robustezza e affidabilità quando applicati ai dati.

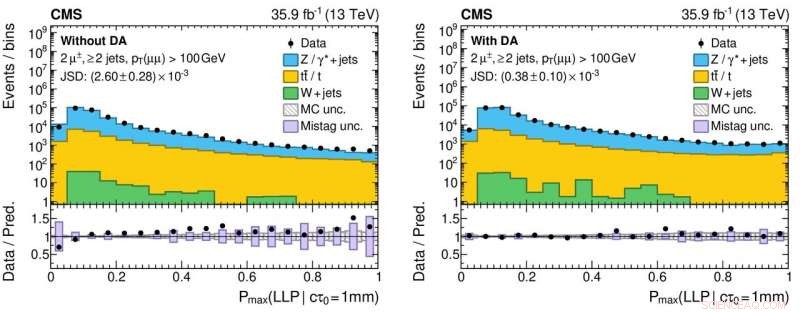

Figura 3:Istogrammi dei valori di output dalla rete neurale per dati di collisione protone-protone reali (marcatori circolari neri) e simulati (istogrammi colorati pieni) senza (pannello di sinistra) e con (pannello di destra) l'applicazione dell'adattamento del dominio. I pannelli inferiori visualizzano i rapporti tra i numeri di dati reali e gli eventi simulati ottenuti da ciascun bin dell'istogramma. I rapporti sono significativamente più vicini all'unità per il pannello di destra, che indica una migliore comprensione delle prestazioni della rete neurale per i dati di collisione reali, che è fondamentale per ridurre i risultati scientifici falsi positivi (e falsi negativi!) durante la ricerca di nuove particelle esotiche. Credito:CERN

La collaborazione CMS utilizzerà questo nuovo strumento come parte della sua continua ricerca di esotici, particelle di lunga durata. Questo studio fa parte di un più ampio sforzo coordinato in tutti gli esperimenti di LHC per utilizzare tecniche di macchine moderne per migliorare il modo in cui i grandi campioni di dati vengono registrati dai rivelatori e la successiva analisi dei dati. Per esempio, l'uso dell'adattamento del dominio può rendere più semplice l'implementazione di solidi modelli di apprendimento automatico come parte dei risultati futuri. L'esperienza acquisita da questi tipi di studio aumenterà il potenziale fisico durante la Run 3, dal 2021, e oltre con l'LHC ad alta luminosità.