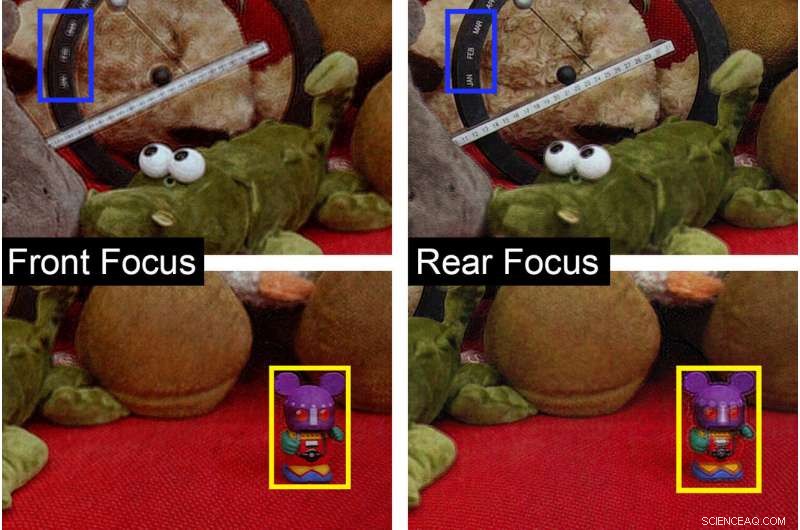

La dimostrazione sperimentale della proiezione olografica 2D e 3D. La fotografia a sinistra è focalizzata sul giocattolo del mouse (nel riquadro giallo) più vicino alla fotocamera, e la fotografia a destra è incentrata sul calendario da tavolo perpetuo (nel riquadro blu). Credito:Liang Shi, Wojciech Matusik, et al

Nonostante anni di clamore, le cuffie per realtà virtuale devono ancora rovesciare gli schermi della TV o del computer come dispositivi di riferimento per la visualizzazione di video. Una ragione:la realtà virtuale può far star male gli utenti. Possono verificarsi nausea e affaticamento degli occhi perché la realtà virtuale crea un'illusione di visualizzazione 3D sebbene l'utente stia in effetti fissando un display 2D a distanza fissa. La soluzione per una migliore visualizzazione 3D potrebbe risiedere in una tecnologia vecchia di 60 anni riprogettata per il mondo digitale:gli ologrammi.

Gli ologrammi offrono una rappresentazione eccezionale del mondo 3D che ci circonda. Più, sono bellissimi. (Vai avanti, controlla la colomba olografica sulla tua carta Visa.) Gli ologrammi offrono una prospettiva mutevole in base alla posizione dello spettatore, e consentono all'occhio di regolare la profondità focale per mettere a fuoco alternativamente il primo piano e lo sfondo.

I ricercatori hanno a lungo cercato di creare ologrammi generati dal computer, ma il processo ha tradizionalmente richiesto un supercomputer per sfornare simulazioni fisiche, che richiede tempo e può produrre risultati tutt'altro che fotorealistici. Ora, I ricercatori del MIT hanno sviluppato un nuovo modo per produrre ologrammi quasi istantaneamente e il metodo basato sull'apprendimento profondo è così efficiente che può essere eseguito su un laptop in un batter d'occhio, dicono i ricercatori.

"Le persone in precedenza pensavano che con l'hardware esistente di livello consumer, era impossibile fare calcoli olografici 3D in tempo reale, "dice Liang Shi, l'autore principale dello studio e un dottorato di ricerca. studente presso il Dipartimento di Ingegneria Elettrica e Informatica (EECS) del MIT. "Si è spesso detto che i display olografici disponibili in commercio saranno disponibili tra 10 anni, eppure questa affermazione esiste da decenni".

Shi crede che il nuovo approccio, che il team chiama "olografia tensoriale, " porterà finalmente a portata di mano quell'elusivo obiettivo di 10 anni. Il progresso potrebbe alimentare una ricaduta dell'olografia in campi come la realtà virtuale e la stampa 3D.

Shi ha lavorato allo studio, pubblicato in Natura , con il suo consigliere e coautore Wojciech Matusik. Altri coautori includono Beichen Li di EECS e il Computer Science and Artificial Intelligence Laboratory del MIT, così come gli ex ricercatori del MIT Changil Kim (ora a Facebook) e Petr Kellnhofer (ora alla Stanford University).

La ricerca di un 3D migliore

Una tipica fotografia basata sull'obiettivo codifica la luminosità di ogni onda luminosa:una foto può riprodurre fedelmente i colori di una scena, ma alla fine produce un'immagine piatta.

In contrasto, un ologramma codifica sia la luminosità che la fase di ciascuna onda luminosa. Questa combinazione offre una rappresentazione più fedele della parallasse e della profondità di una scena. Così, mentre una fotografia delle "Ninfee" di Monet può evidenziare il palato dei colori dei dipinti, un ologramma può dare vita all'opera, rendendo la trama 3D unica di ogni pennellata. Ma nonostante il loro realismo, gli ologrammi sono una sfida da creare e condividere.

Sviluppato per la prima volta a metà del 1900, i primi ologrammi sono stati registrati otticamente. Ciò richiedeva la divisione di un raggio laser, con metà del fascio utilizzato per illuminare il soggetto e l'altra metà utilizzata come riferimento per la fase delle onde luminose. Questo riferimento genera il senso unico di profondità di un ologramma. Le immagini risultanti erano statiche, quindi non potevano catturare il movimento. Ed erano solo cartacei, rendendoli difficili da riprodurre e condividere.

L'olografia generata al computer evita queste sfide simulando la configurazione ottica. Ma il processo può essere una fatica computazionale. "Perché ogni punto della scena ha una profondità diversa, non puoi applicare le stesse operazioni per tutti loro, " dice Shi. "Ciò aumenta significativamente la complessità." Dirigere un supercomputer in cluster per eseguire queste simulazioni basate sulla fisica potrebbe richiedere secondi o minuti per una singola immagine olografica. gli algoritmi esistenti non modellano l'occlusione con precisione fotorealistica. Quindi il team di Shi ha adottato un approccio diverso:lasciare che il computer insegnasse la fisica a se stesso.

Hanno usato il deep learning per accelerare l'olografia generata dal computer, consentendo la generazione di ologrammi in tempo reale. Il team ha progettato una rete neurale convoluzionale, una tecnica di elaborazione che utilizza una catena di tensori addestrabili per imitare approssimativamente il modo in cui gli esseri umani elaborano le informazioni visive. L'addestramento di una rete neurale richiede in genere un grande, set di dati di alta qualità, che in precedenza non esisteva per gli ologrammi 3D.

Il team ha creato un database personalizzato di 4, 000 paia di immagini generate al computer. Ogni coppia ha abbinato un'immagine, comprese le informazioni su colore e profondità per ciascun pixel, con il suo ologramma corrispondente. Per creare gli ologrammi nel nuovo database, i ricercatori hanno utilizzato scene con forme e colori complessi e variabili, con la profondità dei pixel distribuita uniformemente dallo sfondo al primo piano, e con una nuova serie di calcoli basati sulla fisica per gestire l'occlusione. Questo approccio ha portato a dati di addestramento fotorealistici. Prossimo, l'algoritmo si è messo al lavoro.

Imparando da ogni coppia di immagini, la rete tensoriale ha modificato i parametri dei propri calcoli, migliorando successivamente la sua capacità di creare ologrammi. La rete completamente ottimizzata ha gestito ordini di grandezza più velocemente dei calcoli basati sulla fisica. Quell'efficienza ha sorpreso la squadra stessa.

"Siamo stupiti di come si comporta bene, " dice Matusik. In pochi millisecondi, L'olografia tensoriale può creare ologrammi da immagini con informazioni di profondità, fornite da tipiche immagini generate al computer e calcolabili da una configurazione multicamera o da un sensore LiDAR (entrambi sono standard su alcuni nuovi smartphone). Questo progresso apre la strada all'olografia 3D in tempo reale. Cosa c'è di più, la rete compatta del tensore richiede meno di 1 MB di memoria. "È trascurabile, considerando le decine e centinaia di gigabyte disponibili sull'ultimo cellulare, " lui dice.

"Un salto notevole"

L'olografia 3D in tempo reale migliorerebbe una sfilza di sistemi, dalla realtà virtuale alla stampa 3D. Il team afferma che il nuovo sistema potrebbe aiutare a immergere gli spettatori VR in scenari più realistici, eliminando l'affaticamento degli occhi e altri effetti collaterali dell'uso a lungo termine della realtà virtuale. La tecnologia potrebbe essere facilmente implementata su display che modulano la fase delle onde luminose. Attualmente, i display consumer più convenienti modulano solo la luminosità, anche se il costo dei display a modulazione di fase diminuirebbe se ampiamente adottato.

L'olografia tridimensionale potrebbe anche dare impulso allo sviluppo della stampa 3D volumetrica, dicono i ricercatori. Questa tecnologia potrebbe rivelarsi più veloce e più precisa della tradizionale stampa 3D strato per strato, poiché la stampa 3D volumetrica consente la proiezione simultanea dell'intero modello 3D. Altre applicazioni includono la microscopia, visualizzazione di dati medici, e la progettazione di superfici con proprietà ottiche uniche.

"È un salto considerevole che potrebbe cambiare completamente l'atteggiamento delle persone nei confronti dell'olografia, " dice Matusik. "Ci sentiamo come se le reti neurali fossero nate per questo compito".