Credito:OpenAI

Bene, tanto per un'ipotesi che ora sembra troppo facile da accettare:che il magnifico cervello umano ce l'abbia con una macchina ogni giorno. Veramente? Interpretiamo il mondo in modo più accurato di quanto possa fare una "rete neurale convoluzionale"?

Come ha sottolineato anche Ackerman, "quando a una CNN [rete neurale convoluzionale] viene presentata un'immagine, sta guardando una griglia statica di pixel rettangolari."

Guardiamo le immagini e le vediamo correttamente, come uomini e animali; Le CNN guardano le cose più come i computer.

Un team di ricerca sta sollevando domande su semplici ipotesi, però. Stanno esplorando cosa succede con esempi contraddittori riguardo agli umani.

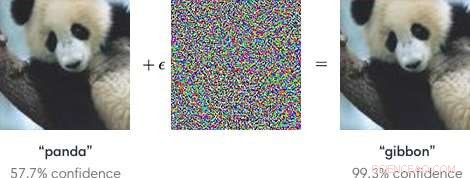

Gli input ai modelli di apprendimento automatico progettati per far sì che i modelli commettano un errore sono "esempi contraddittori". Esempi contraddittori, come tale, potrebbe essere potenzialmente pericoloso.

In poche parole, "Esempi contraddittori sono input dannosi progettati per ingannare i modelli di apprendimento automatico, " secondo una pagina di Google Research.

Come spiegato in un post sul blog in OpenAI, gli aggressori potrebbero prendere di mira i veicoli autonomi utilizzando adesivi o vernice per creare un segnale di stop contraddittorio che il veicolo interpreterebbe come un segnale di "resa" o altro.

I ricercatori, parlando di modelli di apprendimento automatico come vulnerabili a esempi contraddittori, notato che piccole modifiche alle immagini possono causare errori nei modelli di visione artificiale, come identificare uno scuolabus come uno struzzo.

Il blog di OpenAI ha fatto riferimento a esempi contraddittori come rappresentativi di un problema concreto nella sicurezza dell'IA.

Avendolo detto, che dire degli esempi contraddittori che ingannano gli umani? Può succedere?

Il gruppo, disse Even Ackerman in Spettro IEEE , "ha deciso di provare a capire se le stesse tecniche che ingannano le reti neurali artificiali possono anche ingannare le reti neurali biologiche all'interno delle nostre teste".

Il documento di ricerca che descrive il loro lavoro è "Esempi contraddittori che ingannano sia la visione umana che quella artificiale, " su arXiv.

"Qui, creiamo i primi esempi contraddittori progettati per ingannare gli umani, " hanno scritto. Hanno scoperto che "gli esempi contraddittori che si trasferiscono fortemente attraverso i modelli di visione artificiale influenzano le classificazioni fatte da osservatori umani limitati nel tempo." (Ackerman ha notato che nello studio, le persone avevano solo tra 60 e 70 millisecondi per guardare ogni immagine e prendere una decisione.)

Spettro IEEE Anche Ackerman ha discusso di ciò che hanno fatto e ha presentato una serie di due immagini di Google Brain per supportare la sua spiegazione.

Ackerman ha mostrato "a sinistra l'immagine di un gatto. A destra, puoi dire se è una foto dello stesso gatto, o una foto di un cane dall'aspetto simile? La differenza tra le due immagini è che quella a destra è stata leggermente modificata da un algoritmo per rendere difficile per un tipo di modello di computer chiamato rete neurale convoluzionale (CNN) essere in grado di dire cosa sia realmente. In questo caso, la CNN pensa che stia guardando un cane piuttosto che un gatto, ma la cosa notevole è che la maggior parte delle persone pensa la stessa cosa".

Che cosa? Come possono gli esseri umani commettere lo stesso errore? Ackerman ha affermato che potrebbe essere possibile indirizzare lo sviluppo di un'immagine contraddittoria agli umani "scegliendo modelli che si avvicinino il più possibile al sistema visivo umano".

Ma cos'è esattamente che va a incasinare la capacità dell'essere umano di essere corretto? Ackerman ha affermato che i ricercatori hanno sottolineato che "i nostri esempi contraddittori sono progettati per ingannare la percezione umana, quindi dovremmo stare attenti a usare la percezione umana soggettiva per capire come funzionano".

Ha detto che erano disposti a fare alcune generalizzazioni "su alcune diverse categorie di modifiche, compresi 'interrompere i bordi degli oggetti, soprattutto da modulazioni di media frequenza perpendicolari al bordo; migliorare i bordi sia aumentando il contrasto che creando confini di trama; modifica della trama; e sfruttando le zone scure dell'immagine, dove la grandezza percettiva di piccole perturbazioni può essere maggiore.'"

Come sono stati testati:i soggetti con visione normale o corretta hanno partecipato all'esperimento.

"Per ogni gruppo, un'immagine contraddittoria di successo è stata in grado di indurre le persone a scegliere il membro sbagliato del gruppo, identificandolo come un cane quando in realtà è un gatto, o vice versa, " ha detto Ackerman.

Ai soggetti è stato chiesto di classificare le immagini che apparivano sullo schermo premendo i pulsanti su una casella del tempo di risposta, hanno detto gli autori.

Ackerman ha scritto, "Il breve lasso di tempo in cui è stata mostrata l'immagine ha mitigato la differenza tra il modo in cui le CNN percepiscono il mondo e il modo in cui lo fanno gli umani".

L'esperimento ha coinvolto tre gruppi di immagini:animali domestici (cani e gatti), verdure (cavoli e broccoli), e "pericolo" (ragni e serpenti).

Il commento di Ackerman sui risultati della ricerca è stato che "c'è una sovrapposizione tra la manipolazione percettiva delle CNN e la manipolazione degli esseri umani. Significa che le tecniche di apprendimento automatico potrebbero essere potenzialmente utilizzate per alterare sottilmente cose come immagini o video in un modo che potrebbe cambiare la nostra percezione di (e reazione a) loro senza che ci rendessimo mai conto di cosa stava succedendo."

Ha aggiunto che "dovremo stare attenti, and keep in mind that just like those computers, sometimes we're far too easy to fool."

"Adversarial Examples that Fool both Human and Computer Vision" is by Gamaleldin F. Elsayed, Shreya Shankar, Brian Cheung, Nicolas Papernot, Alex Kurakin, Ian Goodfellow, and Jascha Sohl-Dickstein, on arXiv.

© 2018 Tech Xplore