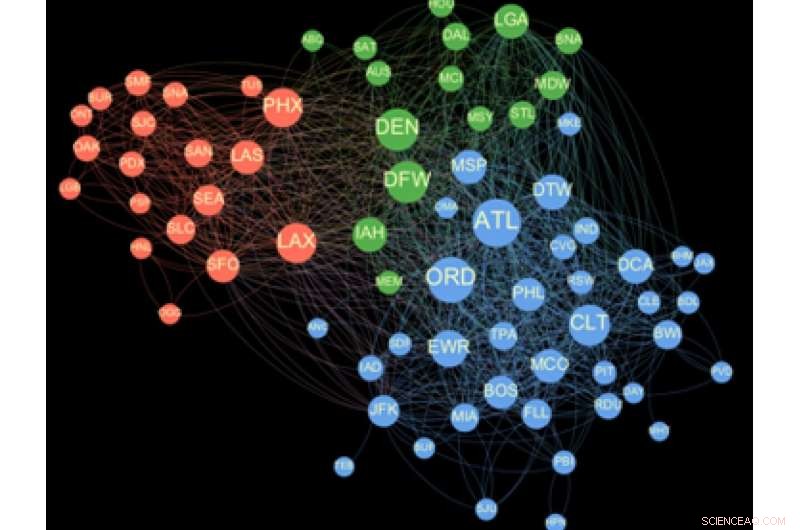

Rete di massimizzazione dell'influenza aeroportuale. Credito:Arun Satanur, PNNL

È inverno. E come ogni viaggiatore frequente sa, l'inverno può significare ritardi meteorologici in aeroporto. Una bufera di neve a Minneapolis, un importante hub aeroportuale, può portare rapidamente a ritardi nella mite Miami o nella nebbiosa Londra.

Per ridurre al minimo le interruzioni, gli analisti del controllo del traffico aereo lavorano per dare priorità agli sforzi di recupero. Ma con così tante variabili, è difficile per loro dare consigli sicuri. Ma questo è proprio il tipo di problema basato sui dati che un computer può essere programmato per risolvere. Il problema è il tempo. I metodi attuali non sono abbastanza veloci da fornire soluzioni in tempo reale.

Ora, un team di ricerca guidato da scienziati informatici del PNNL ha sviluppato un nuovo strumento Graph, chiamato increspature, che può risolvere un problema di analisi grafica complessa come l'analisi dei disagi aeroportuali in meno di un minuto su un supercomputer. Il miglior strumento comparabile potrebbe richiedere un'intera giornata su un normale computer per risolvere lo stesso problema. Un giorno, la pietra miliare del calcolo può rendere l'analisi degli effetti sulla rete come le interruzioni del traffico aereo disponibile per i decisori in tempo reale.

"Il nostro approccio sfrutta una rigorosa metodologia di analisi dei social network, formalmente noto come problema di massimizzazione dell'influenza, e lo ridimensiona per essere eseguito su piattaforme di elaborazione parallela altamente efficienti, " disse Arun Satanur, un informatico del PNNL che ha guidato il lavoro di modellazione aeroportuale. "Questi modelli eccellono nel trovare entità influenti, analizzare l'impatto della connettività, e sottolineando dove le interruzioni hanno il maggiore effetto a catena a cascata."

Il gruppo di ricerca, che comprende anche ricercatori della Northeastern University e del Volpe National Transportation Systems Center del Dipartimento dei trasporti, hanno presentato la loro analisi della rete aeroportuale all'IEEE International Symposium on Technologies for Homeland Security nel novembre 2019.

Utilizzando i dati pubblicamente disponibili forniti dalla Federal Aviation Administration del Dipartimento dei trasporti, hanno raggruppato gli aeroporti in gruppi di influenza e hanno mostrato quali sono gli aeroporti più influenti, nonché come cambia l'elenco degli "influencer" più importanti durante l'anno solare.

I risultati forniscono una prova di principio, che potrebbe eventualmente essere utilizzato per gestire le interruzioni della rete aeroportuale, Satana ha aggiunto.

"Ripples fornisce un potente strumento per la pianificazione e le operazioni strategiche proattive, e ha un'ampia applicabilità nei sistemi di infrastrutture di trasporto in rete, " ha detto Sam Chatterjee, uno scienziato ricercatore operativo al PNNL e ricercatore principale per il lavoro di modellazione aeroportuale guidato da Sathanur.

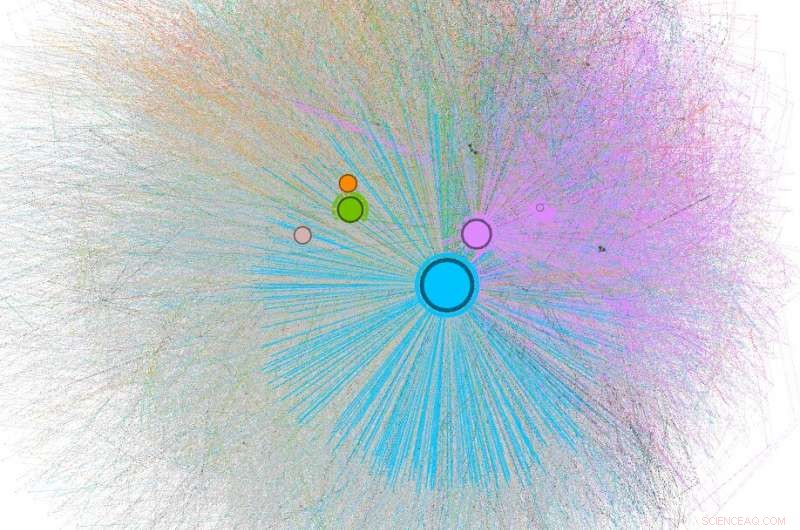

Rappresentazioni di un complesso sistema di reazioni chimiche atmosferiche. Credito:Pacific Northwest National Laboratory

La logistica definitiva

In un mondo sempre più congestionato, essere in grado di ripristinare rapidamente il servizio dopo malfunzionamenti accidentali dei sistemi o violazioni della sicurezza informatica sarebbe un enorme vantaggio. Questo è il regno dell'analisi di rete, che è stato inizialmente sviluppato per capire come le persone nei social network sono collegate tra loro. Sempre più, l'analisi della rete e l'analisi visiva vengono utilizzate per fare cose come individuare l'accesso non autorizzato alle reti di computer, rilevare le relazioni tra le proteine nei tumori cancerosi, e risolvere i dilemmi della congestione dei trasporti come il problema della congestione della rete aeroportuale.

Però, affinché i risultati dell'analisi siano affidabili, deve essere eseguita una sequenza di calcoli per calcolare la diffusione dell'influenza. Questo risulta essere un problema computazionalmente difficile, disse Mahantesh Halappanavar, scienziato senior al PNNL e ricercatore principale di ExaGraph, un centro di co-progettazione delle applicazioni finanziato dall'Exascale Computing Project del Dipartimento dell'Energia (DOE).

"Per molti scenari del mondo reale, non è sempre chiaro come attribuire un peso preciso alla forza delle connessioni tra le singole entità della rete, " ha detto. "Noi, perciò, ripetere le simulazioni con più impostazioni per aumentare l'affidabilità delle soluzioni calcolate." Anche quando i pesi sono ben noti, il metodo si basa ancora sull'esecuzione di un gran numero di simulazioni per identificare entità influenti.

Stimano gli influencer più importanti in qualsiasi gruppo eseguendo queste ripetute simulazioni di un modello a cascata di influenza fino a quando non arrivano a una stima accurata. Questo approccio è ciò che rende scoraggiante trovare anche un piccolo insieme di importanti influencer in una rete moderatamente grande, impiegando giorni per completarlo.

Ecco perché il notevole miglioramento di Ripples nella velocità di soluzione è così significativo.

"Azzerare le entità più influenti nelle reti di grandi dimensioni può diventare rapidamente dispendioso in termini di tempo, " disse Ananth Kalyanaraman, co-sviluppatore della cattedra centenaria di Ripples e Boeing in informatica presso la School of Electrical Engineering and Computer Science, Università statale di Washington, in Pullman. "Ripples, e la sua nuova variante cuRipples, utilizza una strategia di sfruttamento di enormi quantità di potenza di calcolo, compresi quelli nelle moderne unità di elaborazione grafica per cercare l'entità "più influente" durante la sua ricerca."

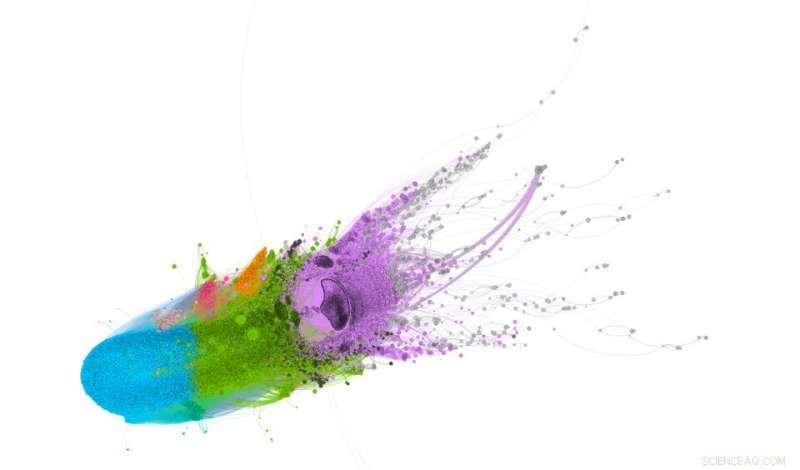

Analisi di similarità proteica mediante Ripples. Credito:Pacific Northwest National Laboratory

Risposte affidabili

Ulteriore, Ripples si basa sulla soluzione fornita con la cosiddetta "garanzia di approssimazione, " che consente all'utente di bilanciare la qualità della soluzione con il tempo necessario per calcolare una soluzione, pur avendo anche la capacità di giudicare la qualità della soluzione calcolata. I team basati su PNNL e WSU hanno lavorato a stretto contatto per scalare lo strumento Ripples in modo efficiente sui supercomputer più veloci gestiti dal DOE.

Questa strategia consente a Ripples di convergere in modo efficiente su una soluzione di qualità superiore, fino a 790 volte più veloce rispetto ai metodi precedenti non progettati per sistemi paralleli.

"Se potessimo convergere su una soluzione in meno di un minuto, possiamo iniziare a usarlo come strumento interattivo, " dice Marco Minutoli al PNNL, lo sviluppatore principale di Ripples. "Possiamo porre e rispondere a nuove domande quasi in tempo reale".

Gli scienziati del PNNL lo stanno già facendo. Hanno iniziato a utilizzare Ripples per elaborare enormi quantità di dati e trovare gli influencer più importanti in:

"Al meglio delle nostre conoscenze, questo è il primo tentativo di parallelizzare l'operazione di massimizzazione dell'influenza su larga scala, " disse Minutoli.

Il team di ricerca ha reso disponibile il metodo per la comunità di ricerca su Github. Stanno pianificando il prossimo grande progresso (cuRipples), che sarà quello di ottimizzare il metodo su Summit, il supercomputer più veloce del mondo.