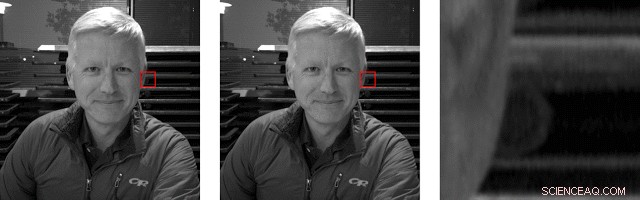

Le due immagini PDAF a sinistra e al centro sembrano molto simili, ma nel ritaglio a destra puoi vedere la parallasse tra di loro. È più evidente sulla struttura circolare nel mezzo del raccolto. Credito:blog di Google

TechSpot dice cosa pensa del Pixel 3 e non è una pubblicità:"Pixel 3 è probabilmente il miglior telefono con fotocamera sul mercato". Tyler Lee in Ubergizmo è in modalità completa complimenti. "Non c'è dubbio che tutto il duro lavoro e la ricerca di Google siano stati ripagati poiché Pixel 3 ha una delle migliori fotocamere in circolazione".

OK, ce l'abbiamo. Nella lotta incessante dei venditori per sopraffare il mercato degli smartphone, Pixel 3 sta contrassegnando con successo il proprio territorio come il telefono con ottime capacità della fotocamera. E, Ora, un blog recente sul blog di Google AI non farà che deliziare ulteriormente i fan di Pixel 3, in quanto descrive in dettaglio come è stata ottenuta la "Modalità verticale" su Pixel 3.

Pensa a un team che si rivolge al machine learning, TensorFlow e obiettivi di percezione della profondità al massimo.

Scott Adam Gordon in Autorità Android condiviso con i lettori ciò che era piuttosto intelligente nell'approccio e nelle tecniche di Google. "Con la fotocamera di Google Pixel 3, Google ha incluso più spunti di profondità per informare questo effetto di sfocatura per una maggiore precisione. Oltre alla parallasse, Google ha utilizzato la nitidezza come indicatore di profondità:gli oggetti più distanti sono meno nitidi di quelli più vicini e l'identificazione degli oggetti del mondo reale. Per esempio, la fotocamera potrebbe riconoscere il volto di una persona in una scena, e calcola quanto fosse vicino o lontano in base al numero di pixel rispetto agli oggetti circostanti."

Rahul Garg, ricercatore e Neal Wadhwa, ingegnere del software, postato il blog. "Quest'anno, sul Pixel 3, ci rivolgiamo all'apprendimento automatico per migliorare la stima della profondità e produrre risultati ancora migliori in modalità Ritratto."

(Google finora ha tenuto per sé la magia, disse Isaiah Mayersen in TechSpot . "Mentre Google continua a spianare la strada alla fotografia per smartphone, dovremo aspettare e vedere cosa portano in tavola i concorrenti.")

Aspettare, cos'è la modalità Ritratto? Webpedia , grazie:

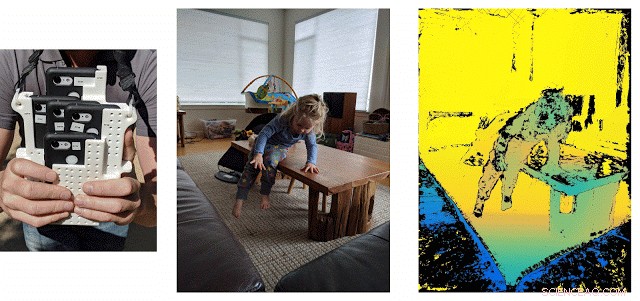

A sinistra:rig personalizzato utilizzato per raccogliere i dati di allenamento. Al centro:un esempio di acquisizione che scorre tra le cinque immagini. La sincronizzazione tra le telecamere assicura che possiamo calcolare la profondità per scene dinamiche, come questo. A destra:profondità della verità al suolo. Punti di confidenza bassi, cioè., punti in cui le corrispondenze stereo non sono affidabili a causa della trama debole, sono colorati in nero e non vengono utilizzati durante l'allenamento. Credito:Sam Ansari e Mike Milne

"Nella fotografia e nella fotografia digitale, la modalità ritratto è una funzione della fotocamera digitale utilizzata quando si scattano foto di un singolo soggetto. Quando si scattano foto in modalità ritratto, la fotocamera digitale utilizzerà automaticamente un'ampia apertura per aiutare a mantenere lo sfondo fuori fuoco utilizzando una ridotta profondità di campo in modo che il soggetto fotografato sia l'unica cosa a fuoco."

Non solo il singolo soggetto ma anche di più:"Non solo la persona nel ritratto sarà a fuoco, anche gli oggetti vicini allo stesso piano di messa a fuoco saranno più nitidi, con una realistica sfocatura crescente man mano che gli oggetti si trovano più avanti e dietro quel piano, " ha detto Ryne Hager in Polizia Android .

Capito? Sfondo volutamente fuori fuoco; il soggetto ha il massimo impatto a fuoco. Questa tecnica viene spesso utilizzata negli annunci e nei messaggi promozionali per attirare la massima attenzione su un volto sfocando lo sfondo.

Google aveva bisogno di alcune foto per addestrare la sua intelligenza artificiale. Inserisci come gruppo di 5 telefoni—ok, detto più gentilmente, un insieme di cinque telefoni. Hanno parlato di mappe di profondità, dati di allenamento e questo assemblaggio, il "Francofono, " un impianto con 5 telefoni, tutti Pixel 3, e soluzione basata su Wi-Fi.

CNET ha descritto Frankenphone. "Un quintetto di telefoni messi insieme ha generato i dati per addestrare il Pixel 3 a giudicare la profondità". Stephen Shankland ha descritto un "gruppo hackerato di cinque telefoni per migliorare il funzionamento della funzione nel Pixel 3 di quest'anno".

Hanno usato TensorFlow Lite, una soluzione multipiattaforma per l'esecuzione di modelli di machine learning su dispositivi mobili e embedded, e la GPU di Pixel 3 per calcolare rapidamente la profondità. Quindi, hanno combinato le stime di profondità risultanti con le maschere della loro "rete neurale di segmentazione delle persone per produrre bellissimi risultati in modalità Ritratto".

Perché questo è importante non richiede molte analisi:scatti in modalità ritratto più belli.

Nel quadro più ampio degli smartphone che scattano foto, i fornitori accettano che la loro proposta di vendita dovrebbe includere allettanti funzionalità della fotocamera. I metodi di fotografia computazionale di Google possono dare a Pixel un vero vantaggio. "Gli smartphone hanno sensori di immagine piccoli che non possono competere con le fotocamere tradizionali per la qualità dell'immagine, ma Google è all'avanguardia con metodi di fotografia computazionale che possono fare cose come sfocare gli sfondi, aumentare la risoluzione, modificare l'esposizione, migliorare i dettagli delle ombre e scattare foto al buio, " ha detto Stephen Shankland, CNET.

© 2018 Science X Network