Sulla pagina Facebook di un utente che si identifica come Nawan Al-Farancsa viene visualizzato un banner con la scritta "The Islamic State". La pagina era ancora attiva martedì, 7 maggio 2019, quando è stata effettuata la cattura dello schermo. Facebook afferma di disporre di solidi sistemi per rimuovere i contenuti dai gruppi estremisti, ma un reclamo sigillato di un informatore esaminato dall'AP afferma che il contenuto vietato rimane sul web ed è facile da trovare. (Facebook tramite AP)

Il video animato inizia con una foto delle bandiere nere della jihad. Secondi dopo, lampeggia i momenti salienti di un anno di post sui social media:targhe di versi antisemiti, parlare di punizione e una foto di due uomini che portano altre bandiere jihadiste mentre bruciano le stelle e strisce.

Non è stato prodotto da estremisti; è stato creato da Facebook. In un'intelligente punta di autopromozione, il gigante dei social media prende un anno di contenuto di un utente e genera automaticamente un video celebrativo. In questo caso, l'utente si faceva chiamare "Abdel-Rahim Moussa, il Califfato».

"Grazie per essere qui, da Facebook, il video si conclude in una bolla di cartone animato prima di mostrare il famoso "pollice in su" dell'azienda.

A Facebook piace dare l'impressione di stare davanti agli estremisti eliminando i loro post, spesso prima ancora che gli utenti li vedano. Ma la denuncia di un informatore confidenziale alla Securities and Exchange Commission ottenuta da The Associated Press afferma che la società di social media ha esagerato il suo successo. Persino peggio, mostra che l'azienda sta inavvertitamente facendo uso della propaganda di gruppi militanti per generare automaticamente video e pagine che potrebbero essere utilizzate per il networking da estremisti.

Secondo la denuncia, nell'arco di cinque mesi lo scorso anno, i ricercatori hanno monitorato le pagine degli utenti che si sono affiliati a gruppi che il Dipartimento di Stato degli Stati Uniti ha designato come organizzazioni terroristiche. In quel periodo, Il 38% dei post con simboli di spicco di gruppi estremisti è stato rimosso. Nella propria recensione, l'AP ha rilevato che a partire da questo mese, gran parte dei contenuti vietati citati nello studio:un video di esecuzione, immagini di teste mozzate, la propaganda in onore dei militanti martiri è scivolata attraverso il web algoritmico ed è rimasta facile da trovare su Facebook.

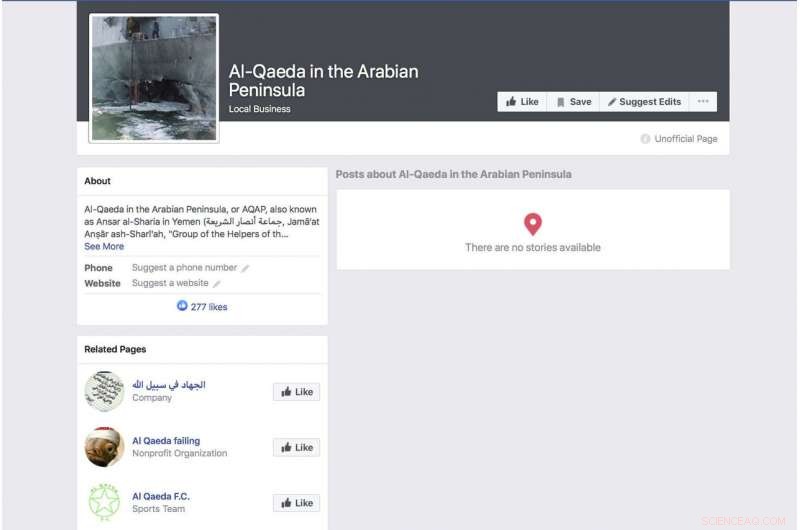

Una pagina generata automaticamente da Facebook per un gruppo che si identifica come il gruppo terroristico "Al-Qaeda nella penisola arabica" mostra una foto della nave da guerra USS Cole della US Navy bombardata. La pagina era ancora attiva da martedì, 7 maggio 2019, quando è stata effettuata la cattura dello schermo. Facebook afferma di disporre di solidi sistemi per rimuovere i contenuti dai gruppi estremisti, ma un reclamo di un informatore sigillato esaminato dall'AP afferma che i contenuti vietati rimangono sul web e sono facili da trovare. (Facebook tramite AP)

La denuncia sta arrivando mentre Facebook cerca di stare al passo con una serie crescente di critiche sulle sue pratiche sulla privacy e sulla sua capacità di mantenere l'incitamento all'odio, omicidi e suicidi in diretta streaming fuori dal suo servizio. Di fronte alle critiche, Il CEO Mark Zuckerberg ha parlato del suo orgoglio per la capacità dell'azienda di eliminare automaticamente i post violenti attraverso l'intelligenza artificiale. Durante una chiamata sui guadagni il mese scorso, ad esempio, ha ripetuto una formulazione accuratamente formulata che Facebook ha utilizzato.

"In aree come il terrorismo, per i contenuti relativi ad al-Qaeda e ISIS, ora il 99% dei contenuti che rimuoviamo nella categoria i nostri sistemi segnalano in modo proattivo prima che qualcuno lo veda, " ha detto. Poi ha aggiunto:"Questo è quello che sembra veramente buono".

Zuckerberg non ha fornito una stima della quantità totale di materiale proibito rimossa.

La ricerca dietro la denuncia della SEC mira a mettere in luce evidenti difetti nell'approccio dell'azienda. L'anno scorso, i ricercatori hanno iniziato a monitorare gli utenti che si identificavano esplicitamente come membri di gruppi estremisti. Non è stato difficile documentarsi. Alcune di queste persone elencano persino i gruppi estremisti come i loro datori di lavoro. Un profilo annunciato dalla bandiera nera di un gruppo affiliato ad al-Qaeda elencava il suo datore di lavoro, forse scherzosamente, come Facebook. Il profilo che includeva il video generato automaticamente con la bandiera bruciata conteneva anche un video del leader di al-Qaeda Ayman al-Zawahiri che esortava i gruppi jihadisti a non combattere tra loro.

Sebbene lo studio sia tutt'altro che completo, in parte perché Facebook rende raramente disponibili al pubblico molti dei suoi dati, i ricercatori coinvolti nel progetto affermano che la facilità di identificare questi profili utilizzando una ricerca per parole chiave di base e il fatto che così pochi di essi siano stati rimossi suggeriscono che le affermazioni di Facebook secondo cui i suoi sistemi catturano la maggior parte dei contenuti estremisti non sono accurate.

Amr Al Azm, professore di Storia e Antropologia del Medio Oriente alla Shawnee State University, parla nel suo ufficio il 25 aprile, 2019, a Portsmouth, Ohio. Facebook dà l'impressione che stia fermando la stragrande maggioranza dei post estremisti prima che gli utenti li vedano. Ma la denuncia di un informatore confidenziale alla Securities and Exchange Commission ottenuta da The Associated Press afferma che la società di social media ha esagerato il suo successo. "Voglio dire che sta solo allungando l'immaginazione oltre l'incredulità, " dice, Al Azm uno dei ricercatori coinvolti nel progetto. "Se un piccolo gruppo di ricercatori riesce a trovare centinaia di pagine di contenuti con semplici ricerche, perché un'azienda gigante con tutte le sue risorse non può farlo?" (AP Photo/John Minchillo)

"Voglio dire, questo è solo allungare l'immaginazione oltre l'incredulità, "dice Amr Al Azm, uno dei ricercatori coinvolti nel progetto. "Se un piccolo gruppo di ricercatori riesce a trovare centinaia di pagine di contenuti con semplici ricerche, perché non può farlo un'azienda gigante con tutte le sue risorse?"

Al Azm, professore di storia e antropologia alla Shawnee State University in Ohio, ha anche diretto un gruppo in Siria che documenta il saccheggio e il contrabbando di antichità.

Facebook ammette che i suoi sistemi non sono perfetti, ma dice che sta apportando miglioramenti.

"Dopo aver fatto ingenti investimenti, stiamo rilevando e rimuovendo i contenuti terroristici con un tasso di successo molto più elevato rispetto anche a due anni fa, La società ha dichiarato in una nota. "Non pretendiamo di trovare tutto e rimaniamo vigili nei nostri sforzi contro i gruppi terroristici in tutto il mondo".

Reagendo alla segnalazione dell'AP, Il rappresentante Bennie Thompson, D-Miss., il presidente del Comitato per la sicurezza interna della Camera ha espresso frustrazione per il fatto che Facebook abbia fatto così pochi progressi nel bloccare i contenuti nonostante le rassicurazioni ricevute dalla società.

Una pagina Facebook per l'utente Ramadan Kareem, che, se tradotto in inglese, indica che l'utente lavora presso "Stato islamico in Sham e Iraq". La pagina era ancora attiva martedì, 7 maggio 2019, quando è stata effettuata la cattura dello schermo. Facebook afferma di disporre di solidi sistemi per rimuovere i contenuti dai gruppi estremisti, ma un reclamo di un informatore sigillato esaminato dall'AP afferma che i contenuti vietati rimangono sul web e sono facili da trovare. (Facebook tramite AP)

"Questo è un altro esempio profondamente preoccupante dell'incapacità di Facebook di gestire le proprie piattaforme e della misura in cui ha bisogno di ripulire il suo atto, " ha detto. "Facebook non deve solo liberare le sue piattaforme dai contenuti terroristici ed estremisti, ma deve anche essere in grado di impedire che venga amplificato".

Ma come chiara indicazione della facilità con cui gli utenti possono eludere Facebook, una pagina di un utente chiamato "Nawan al-Farancsa" ha un'intestazione la cui scritta bianca su sfondo nero dice in inglese "The Islamic State". Lo striscione è punteggiato dalla foto di un fungo atomico esplosivo che si alza da una città.

Il profilo avrebbe dovuto attirare l'attenzione di Facebook e delle agenzie di controspionaggio. È stato creato nel giugno 2018 elenca l'utente come proveniente dalla Cecenia, una volta un hotspot militante. Dice che viveva a Heidelberg, Germania, e ha studiato in un'università in Indonesia. Alcuni degli amici dell'utente hanno anche pubblicato contenuti militanti.

La pagina, ancora in piedi nei giorni scorsi, apparentemente sfuggito ai sistemi di Facebook, a causa di un'evidente e lunga elusione della moderazione che Facebook dovrebbe essere abile a riconoscere:le lettere non erano testo ricercabile ma incorporate in un blocco grafico. Ma la società afferma che la sua tecnologia esegue la scansione dell'audio, video e testo, anche se incorporati, per immagini che riflettono violenza, armi o loghi di gruppi proibiti.

Il gigante dei social network ha vissuto due anni difficili a partire dal 2016, quando l'uso dei social media da parte della Russia per intromettersi nelle elezioni presidenziali statunitensi è stato messo a fuoco. Zuckerberg inizialmente ha minimizzato il ruolo svolto da Facebook nell'operazione di influenza dell'intelligence russa, ma l'azienda si è poi scusata.

Una pagina Facebook per un utente che si traduce in inglese come "Lights of bitterness" che elenca l'utente come medico presso lo Stato Islamico. La pagina era ancora attiva da martedì, 7 maggio 2019, quando è stata effettuata la cattura dello schermo. Facebook afferma di disporre di solidi sistemi per rimuovere i contenuti dai gruppi estremisti, ma la denuncia di un informatore esaminata dall'AP afferma che i contenuti vietati rimangono sul web e sono facili da trovare. (Facebook tramite AP)

Facebook dice che ora impiega 30 persone, 000 persone che lavorano alle sue pratiche di sicurezza e protezione, rivedere materiale potenzialmente dannoso e qualsiasi altra cosa che potrebbe non appartenere al sito. Ancora, l'azienda sta riponendo molta fiducia nell'intelligenza artificiale e nella capacità dei suoi sistemi di eliminare alla fine le cose cattive senza l'aiuto degli umani. La nuova ricerca suggerisce che l'obiettivo è molto lontano e alcuni critici sostengono che l'azienda non stia facendo uno sforzo sincero.

Quando il materiale non viene rimosso, viene trattato come qualsiasi altra cosa postata dai 2,4 miliardi di utenti di Facebook, celebrata in video animati, collegati, classificati e consigliati da algoritmi.

Ma la colpa non è solo degli algoritmi. I ricercatori hanno scoperto che alcuni estremisti utilizzano il "Frame Studio" di Facebook per pubblicare propaganda militante. Lo strumento consente alle persone di decorare le foto del proprio profilo all'interno di cornici grafiche, per supportare cause o festeggiare compleanni, ad esempio. Facebook afferma che quelle immagini incorniciate devono essere approvate dall'azienda prima di essere pubblicate.

Hany Farid, un esperto di informatica forense presso l'Università della California, Berkeley, che consiglia il Progetto contro l'estremismo, un gruppo con sede a New York e Londra focalizzato sulla lotta alla messaggistica estremista, dice che il sistema di intelligenza artificiale di Facebook sta fallendo. Dice che l'azienda non è motivata ad affrontare il problema perché sarebbe costoso.

"L'intera infrastruttura è fondamentalmente difettosa, " ha detto. "E c'è pochissimo appetito per risolverlo perché ciò che Facebook e le altre società di social media sanno è che una volta che iniziano a essere responsabili del materiale sulle loro piattaforme si apre un'intera lattina di worm".

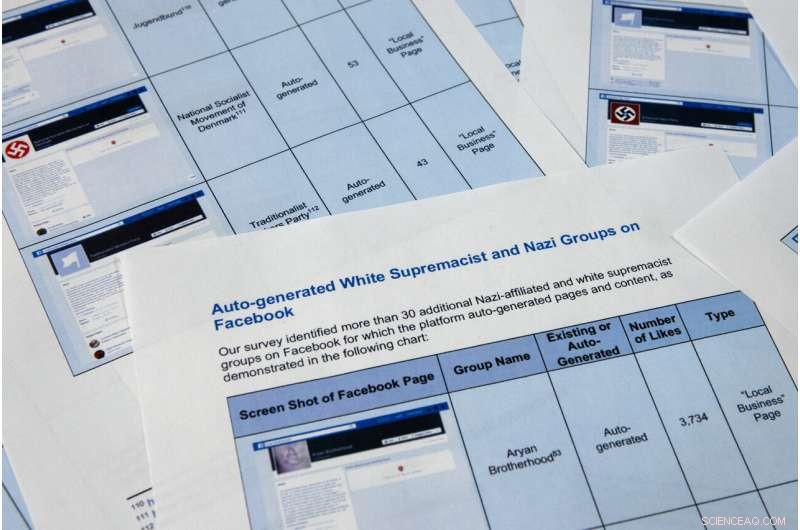

Le pagine del rapporto di un informatore confidenziale ottenuto dall'Associated Press sono state fotografate martedì, 7 maggio 2019, a Washington. A Facebook piace dare l'impressione che stia fermando la stragrande maggioranza dei post estremisti prima che gli utenti li vedano., ma la denuncia dell'informatore confidenziale alla Securities and Exchange Commission sostiene che la società di social media abbia esagerato il suo successo. Persino peggio, mostra che l'azienda sta facendo uso della propaganda di gruppi militanti per generare automaticamente video e pagine che potrebbero essere utilizzate per il networking dagli estremisti. (Foto AP/Jon Elswick)

Le pagine del rapporto di un informatore confidenziale ottenuto dall'Associated Press sono state fotografate martedì, 7 maggio 2019, a Washington. A Facebook piace dare l'impressione che stia fermando la stragrande maggioranza dei post estremisti prima che gli utenti li vedano., ma la denuncia dell'informatore confidenziale alla Securities and Exchange Commission sostiene che la società di social media abbia esagerato il suo successo. Persino peggio, mostra che l'azienda sta facendo uso della propaganda di gruppi militanti per generare automaticamente video e pagine che potrebbero essere utilizzate per il networking da estremisti. I ricercatori nella denuncia della SEC hanno identificato oltre 30 pagine generate automaticamente per gruppi di suprematisti bianchi, il cui contenuto è vietato da Facebook. (Foto AP/Jon Elswick)

In questo 11 aprile 2018, foto d'archivio, Il CEO di Facebook Mark Zuckerberg testimonia prima di un'udienza House Energy and Commerce a Capitol Hill a Washington. Facebook dà l'impressione che stia fermando la stragrande maggioranza dei post estremisti prima che gli utenti li vedano. Ma la denuncia di un informatore confidenziale alla Securities and Exchange Commission ottenuta da The Associated Press afferma che la società di social media ha esagerato il suo successo. (Foto AP/Andrew Harnik, File)

Un'altra funzione di generazione automatica di Facebook andata storta elimina le informazioni sull'occupazione dalle pagine degli utenti per creare pagine aziendali. La funzione dovrebbe produrre pagine destinate ad aiutare le aziende a fare rete, ma in molti casi servono come spazio di atterraggio per i gruppi estremisti. La funzione consente agli utenti di Facebook di mettere mi piace alle pagine di organizzazioni estremiste, compresa Al Qaeda, il gruppo dello Stato Islamico e al-Shabab con sede in Somalia, fornendo efficacemente un elenco di simpatizzanti per i reclutatori.

Nella parte superiore di una pagina generata automaticamente per al-Qaeda nella penisola arabica, l'AP ha trovato una foto dello scafo danneggiato della USS Cole, which was bombed by al-Qaida in a 2000 attack off the coast of Yemen that killed 17 U.S. Navy sailors. It's the defining image in AQAP's own propaganda. The page includes the Wikipedia entry for the group and had been liked by 277 people when last viewed this week.

As part of the investigation for the complaint, Al Azm's researchers in Syria looked closely at the profiles of 63 accounts that liked the auto-generated page for Hay'at Tahrir al-Sham, a group that merged from militant groups in Syria, including the al-Qaida affiliated al-Nusra Front. The researchers were able to confirm that 31 of the profiles matched real people in Syria. Some of them turned out to be the same individuals Al Azm's team was monitoring in a separate project to document the financing of militant groups through antiquities smuggling.

Facebook also faces a challenge with U.S. hate groups. A marzo, the company announced that it was expanding its prohibited content to also include white nationalist and white separatist content— previously it only took action with white supremacist content. It says that it has banned more than 200 white supremacist groups. But it's still easy to find symbols of supremacy and racial hatred.

The researchers in the SEC complaint identified over 30 auto-generated pages for white supremacist groups, whose content Facebook prohibits. They include "The American Nazi Party" and the "New Aryan Empire." A page created for the "Aryan Brotherhood Headquarters" marks the office on a map and asks whether users recommend it. One endorser posted a question:"How can a brother get in the house."

A Facebook page for an auto generated Facebook page for a local business, translated into English from Arabic, calling itself 'Islamic State in Sham and Iraq. The page was still live as of Tuesday, 7 maggio 2019, when the screen grab was made. Facebook says it has robust systems in place to remove content from extremist groups, but a sealed whistleblower's complaint reviewed by the AP says banned content remains on the web and easy to find. (Facebook tramite AP)

Even supremacists flagged by law enforcement are slipping through the net. Following a sweep of arrests beginning in October, federal prosecutors in Arkansas indicted dozens of members of a drug trafficking ring linked to the New Aryan Empire. A legal document from February paints a brutal picture of the group, alleging murder, kidnapping and intimidation of witnesses that in one instance involved using a searing-hot knife to scar someone's face. It also alleges the group used Facebook to discuss New Aryan Empire business.

But many of the individuals named in the indictment have Facebook pages that were still up in recent days. They leave no doubt of the users' white supremacist affiliation, posting images of Hitler, swastikas and a numerical symbol of the New Aryan Empire slogan, "To The Dirt"—the members' pledge to remain loyal to the end. One of the group's indicted leaders, Jeffrey Knox, listed his job as "stomp down Honky." Facebook then auto-generated a "stomp down Honky" business page.

Social media companies have broad protection in U.S. law from liability stemming from the content that users post on their sites. But Facebook's role in generating videos and pages from extremist content raises questions about exposure. Legal analysts contacted by the AP differed on whether the discovery could open the company up to lawsuits.

At a minimum, the research behind the SEC complaint illustrates the company's limited approach to combatting online extremism. The U.S. State Department lists dozens of groups as "designated foreign terrorist organizations" but Facebook in its public statements says it focuses its efforts on two, the Islamic State group and al-Qaida. But even with those two targets, Facebook's algorithms often miss the names of affiliated groups. Al Azm says Facebook's method seems to be less effective with Arabic script.

Ad esempio, a search in Arabic for "Al-Qaida in the Arabian Peninsula" turns up not only posts, but an auto-generated business page. One user listed his occupation as "Former Sniper" at "Al-Qaida in the Arabian Peninsula" written in Arabic. Another user evaded Facebook's cull by reversing the order of the countries in the Arabic for ISIS or "Islamic State of Iraq and Syria."

Amr Al Azm, a professor of Middle East History and Anthropology at Shawnee State University, speaks at his office on April 25, 2019, in Portsmouth, Ohio. Facebook gives the impression that it's stopping the vast majority of extremist posts before users ever see them. But a confidential whistleblower's complaint to the Securities and Exchange Commission obtained by The Associated Press alleges the social media company has exaggerated its success. "I mean that's just stretching the imagination to beyond incredulity, " says, Al Azm one of the researchers involved in the project. "If a small group of researchers can find hundreds of pages of content by simple searches, why can't a giant company with all its resources do it?" (AP Photo/John Minchillo)

John Kostyack, a lawyer with the National Whistleblower Center in Washington who represents the anonymous plaintiff behind the complaint, said the goal is to make Facebook take a more robust approach to counteracting extremist propaganda.

"Right now we're hearing stories of what happened in New Zealand and Sri Lanka—just heartbreaking massacres where the groups that came forward were clearly openly recruiting and networking on Facebook and other social media, " he said. "That's not going to stop unless we develop a public policy to deal with it, unless we create some kind of sense of corporate social responsibility."

Farid, the digital forensics expert, says that Facebook built its infrastructure without thinking through the dangers stemming from content and is now trying to retrofit solutions.

"The policy of this platform has been:'Move fast and break things.' I actually think that for once their motto was actually accurate, " he says. "The strategy was grow, crescere, crescere, profit, profit, profit and then go back and try to deal with whatever problems there are."

© 2019 The Associated Press. Tutti i diritti riservati.