L'immagine di input originale. Credito:Lee et al.

Ricercatori presso IBM Research UK, l'Accademia Militare degli Stati Uniti e l'Università di Cardiff hanno recentemente proposto un nuovo approccio per migliorare la sensibilità del LIME (Local Interpretable Model Agnostic Explanations), una tecnica per ottenere una migliore comprensione delle conclusioni raggiunte dagli algoritmi di apprendimento automatico. La loro carta, pubblicato sulla biblioteca digitale SPIE, potrebbero informare lo sviluppo di strumenti di intelligenza artificiale (AI) che forniscono spiegazioni esaurienti su come hanno raggiunto un particolare risultato o conclusione.

"Crediamo che l'intelligenza artificiale e l'apprendimento automatico possano supportare e aumentare il processo decisionale umano, ma che c'è anche la necessità di un'IA spiegabile, "Eunjin Lee, coautore del documento di ricerca originale ed Emerging Technology Specialist e Senior Inventor presso IBM Research U.K., ha detto a TechXplore. "Oggi, le decisioni prese da molti sistemi di apprendimento automatico sono inspiegabili, cioè., non c'è modo per noi umani di sapere come i sistemi sono arrivati a quelle decisioni. La nostra ricerca affronta questo problema studiando come migliorare le tecniche di spiegabilità che mirano a far luce sulla natura della "scatola nera" dei processi di apprendimento automatico".

LIME è una tecnica di spiegabilità particolarmente popolare che può essere applicata a molti modelli di apprendimento automatico. Nonostante la sua versatilità, è spesso visto come inaffidabile e quindi inefficace nel fornire spiegazioni, anche per la variabilità dei risultati che produce. Piuttosto che sviluppare una tecnica di spiegabilità completamente nuova, Lee e i suoi colleghi hanno deciso di identificare i meccanismi che potrebbero migliorare le spiegazioni di LIME.

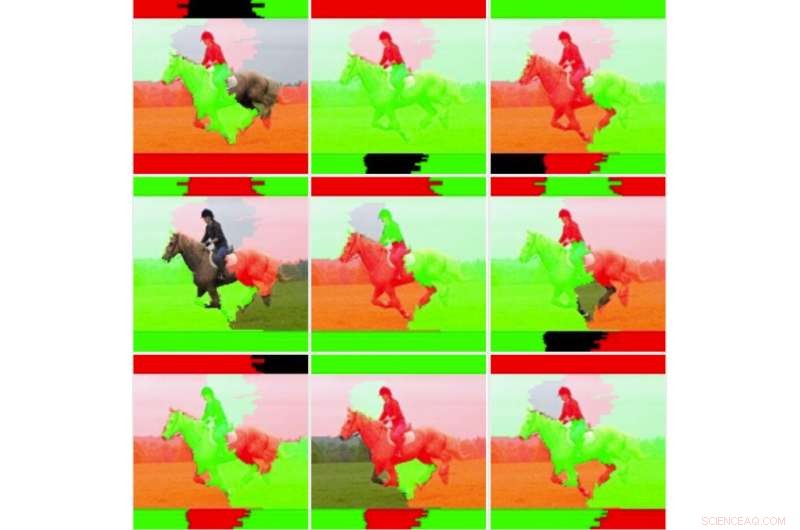

"Volevamo prima esaminare più a fondo l'instabilità che altri ricercatori hanno osservato per determinare se LIME fosse davvero instabile, " ha spiegato Lee. "Per fare questo, abbiamo testato LIME rispetto al nostro set di dati e al modello di apprendimento automatico senza modificare il codice sottostante. Abbiamo subito scoperto che le immagini di spiegazione risultanti variavano considerevolmente e non sembravano coerenti. Questo è forse il punto in cui molti semplicemente smetterebbero di usare la tecnica".

Nove output di immagini per la tecnica LIME non modificata. Credito:Lee et al.

Quando Lee e i suoi colleghi hanno approfondito le statistiche di base di LIME, hanno scoperto che sebbene le immagini generate apparissero "visivamente instabili, " la spiegazione predefinita non prendeva in considerazione tutte le informazioni statistiche. Ad esempio, la colorazione delle immagini esplicative era troppo semplice e non considerava tutti i dati sottostanti (ad es. non ha tenuto conto di tecniche come l'ombreggiatura o la trasparenza). Questa scoperta spiega in parte perché le spiegazioni generate da LIME a volte non riescono a trasmettere la certezza della classificazione agli utenti umani.

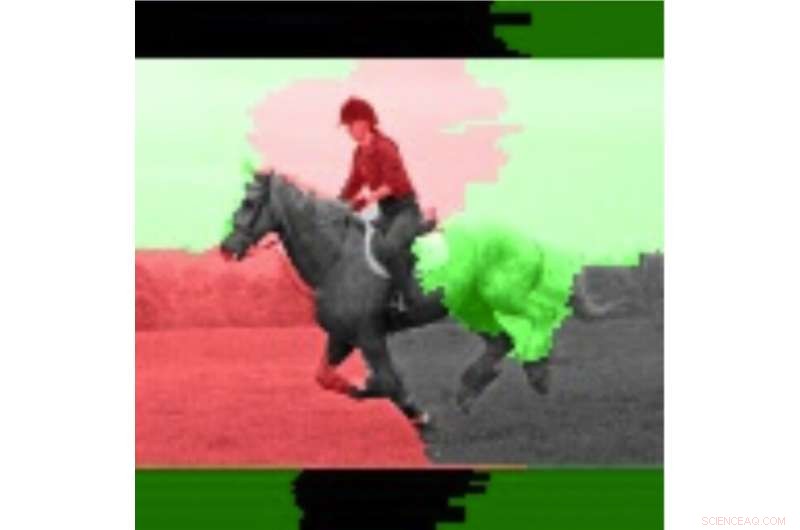

"Spesso è il caso dei sistemi dinamici, come quelli che abbiamo esaminato in questo studio, che l'esecuzione di numerosi test e l'analisi dei valori medi può rivelarsi utile, " Lee ha detto. "Adottando questo approccio, ci siamo resi conto che la stabilità delle spiegazioni è migliorata se si considerano i valori medi e le deviazioni standard su più esecuzioni piuttosto che eseguire la spiegazione una sola volta."

Nel loro studio, Lee e i suoi colleghi hanno addestrato un modello di rete neurale convoluzionale (CNN) utilizzando due classi di immagini, vale a dire "armatore" e "non portatore". Hanno scoperto che la sensibilità di LIME è migliorata quando sono stati calcolati e visualizzati diversi pesi di output per singole immagini.

I ricercatori hanno quindi confrontato queste immagini medie con le singole immagini per valutare la variabilità e l'affidabilità dei due metodi LIME (ovvero il metodo tradizionale e quello da loro proposto). Hanno scoperto che le tradizionali tecniche LIME, senza gli aggiustamenti che hanno fatto, sembrava essere instabile a causa della semplice colorazione binaria che adottavano e della facilità con cui le regioni colorate si capovolgevano quando si confrontavano diverse analisi. Lee e i suoi colleghi hanno anche osservato che le regioni delle immagini significativamente pesate erano coerenti, mentre le regioni con ponderazione inferiore hanno capovolto gli stati, a causa dell'instabilità intrinseca delle tecniche LIME.

L'immagine evidenziata utilizzando le informazioni medie. Credito:Lee et al.

"Tecniche come LIME mostrano grandi promesse per la spiegabilità dell'IA, soprattutto in un momento in cui non ci sono facili, capacità di spiegazione prontamente disponibili per i sistemi di apprendimento automatico, " ha detto Lee. "Mentre l'instabilità percepita è giustificata, ci sono tecniche che possono aiutare a mitigare questo problema. Queste tecniche hanno costi computazionali aggiuntivi, per esempio. eseguire la spiegazione più volte, il che significa che l'utente avrà un ritardo maggiore nella generazione della spiegazione."

Lo studio condotto da Lee e dai suoi colleghi offre una preziosa spiegazione di alcuni dei fattori alla base dell'instabilità di LIME, come osservato in precedenti ricerche. I loro risultati suggeriscono che il miglioramento dei metodi di ponderazione per le tecniche di spiegabilità può migliorare la loro stabilità e portare a spiegazioni più affidabili, in ultima analisi, promuovendo una maggiore fiducia nell'IA. La ricerca futura potrebbe identificare tecniche numeriche più avanzate per migliorare ulteriormente la stabilità di LIME e altri metodi di spiegabilità, riducendo al contempo il sovraccarico aggiuntivo.

"Abbiamo un interesse costante nei sistemi di intelligenza artificiale responsabili che includano spiegazioni, ma riducano anche i pregiudizi e migliorano la robustezza e la trasparenza, "Ha detto Lee. "Migliorare la capacità degli sviluppatori di incorporare più facilmente le tecniche di spiegabilità nelle loro soluzioni di intelligenza artificiale è un obiettivo chiave per noi. Recentemente, IBM ha lanciato un servizio software che rileva automaticamente i bias e spiega come l'AI prende le decisioni".

© 2019 Science X Network