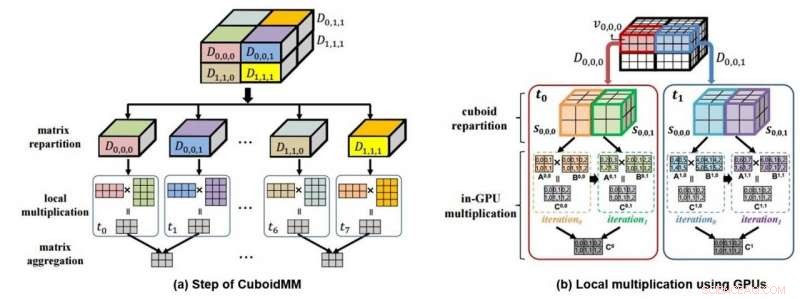

Questo è un diagramma mimetico (a) della moltiplicazione dei dati 3D tramite CuboidMM e un diagramma mimetico (b) del calcolo dell'elaborazione dati tramite GPU. Credito:DGIST

Il 4 luglio il DGIST ha annunciato che il team del professor Min-Soo Kim presso il Dipartimento di ingegneria dell'informazione e della comunicazione ha sviluppato la tecnologia DistME (Distributed Matrix Engine) in grado di analizzare 100 volte più dati 14 volte più velocemente rispetto alle tecnologie esistenti. Questa nuova tecnologia dovrebbe essere utilizzata nell'apprendimento automatico che richiede l'elaborazione di big data o vari settori industriali per analizzare dati su larga scala in futuro.

dati 'matrice', che esprime numeri in riga e colonna, è la forma di dati più utilizzata in vari campi come l'apprendimento automatico e la tecnologia scientifica. Mentre 'SystemML' e 'ScaLAPACK' sono valutati come le tecnologie più popolari per analizzare i dati di matrice, ma la capacità di elaborazione della tecnologia esistente ha recentemente raggiunto i suoi limiti con la crescente dimensione dei dati. È particolarmente difficile eseguire le moltiplicazioni, che sono necessari per il trattamento dei dati, per l'analisi dei big data con i metodi esistenti perché non possono eseguire analisi ed elaborazioni elastiche e richiedono un'enorme quantità di trasferimento di dati di rete per l'elaborazione.

In risposta, Il team del professor Kim ha sviluppato un metodo di moltiplicazione di matrici distribuite diverso da quello esistente. Chiamato anche CuboidMM, questo metodo forma la moltiplicazione di matrici in un esaedro 3D e quindi partiziona ed elabora in più pezzi chiamati cuboidi. La dimensione ottimale del cuboide è determinata in modo flessibile in base alle caratteristiche delle matrici, cioè., la dimensione, la dimensione, e scarsità di matrice, in modo da ridurre al minimo i costi di comunicazione. CuboidMM non solo include tutti i metodi esistenti, ma può anche eseguire la moltiplicazione di matrici con un costo di comunicazione minimo. Inoltre, Il team del professor Kim ha ideato una tecnologia di elaborazione delle informazioni combinata con la GPU (Graphics Processing Unit) che ha notevolmente migliorato le prestazioni della moltiplicazione di matrici.

La tecnologia DistME sviluppata dal team del Professor Kim ha aumentato la velocità di elaborazione combinando CuboidMM con GPU, che è rispettivamente 6,5 e 14 volte più veloce di ScaLAPACK e SystemML e può analizzare dati di matrice 100 volte più grandi di SystemML. Si prevede che aprirà una nuova applicabilità dell'apprendimento automatico in varie aree che richiedono l'elaborazione di dati su larga scala, inclusi centri commerciali online e SNS.

Il professor Kim del Dipartimento di ingegneria dell'informazione e della comunicazione ha dichiarato:"Tecnologia di apprendimento automatico, che ha attirato l'attenzione mondiale, presenta limitazioni nella velocità per l'analisi dei big data sotto forma di matrice e nella dimensione dell'elaborazione dell'analisi. La tecnologia di elaborazione delle informazioni sviluppata questa volta può superare tali limiti e sarà utile non solo nell'apprendimento automatico, ma anche in applicazioni in una gamma più ampia di applicazioni per l'analisi dei dati della tecnologia scientifica".

Questa ricerca è stata partecipata da Donghyoung Han, un dottorato di ricerca studente del Dipartimento di Ingegneria dell'Informazione e della Comunicazione come primo autore ed è stato presentato il 3 luglio in ACM SIGMOD 2019, la conferenza accademica più rinomata nel campo dei database tenutasi ad Amsterdam, Olanda.