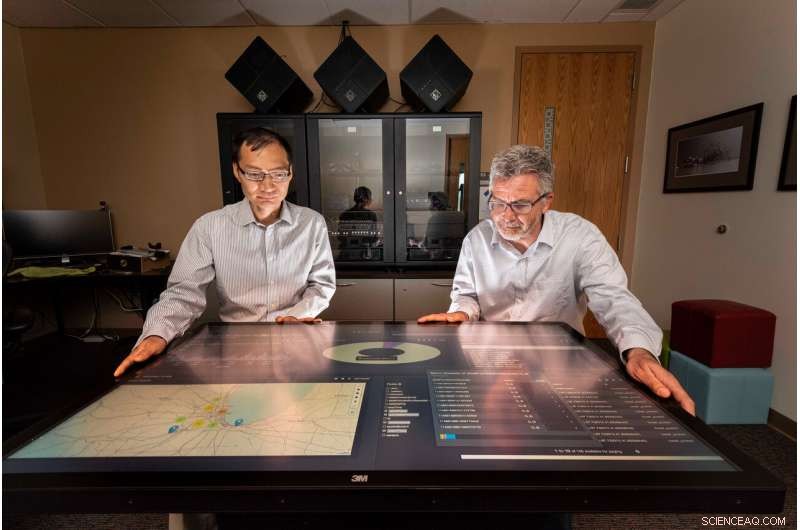

Sandia National Laboratories informatici Tian Ma, sinistra, e Rudy Garcia, ha condotto un progetto per fornire informazioni fruibili dallo streaming di dati in tempo quasi reale. Credito:Randy Montoya

Sociale, macchine fotografiche, sensori e altro ancora generano enormi quantità di dati che possono sopraffare gli analisti che li esaminano alla ricerca di informazioni significative, informazioni fruibili per fornire ai responsabili delle decisioni, come leader politici e comandanti sul campo, la risposta alle minacce alla sicurezza.

I ricercatori dei Sandia National Laboratories stanno lavorando per ridurre tale onere sviluppando la scienza per raccogliere informazioni dai dati in tempo quasi reale.

"La quantità di dati prodotti dai sensori e dai social media è in forte espansione:ogni giorno vengono generati circa 2,5 quintilioni (o 2,5 miliardi di miliardi) di byte, " ha detto Tian Ma, un informatico Sandia e co-responsabile del progetto. "Circa il 90% di tutti i dati è stato generato negli ultimi due anni:ci sono più dati di quanti ne abbiamo da analizzare. Le comunità di intelligence sono sostanzialmente sopraffatte, e il problema è che ti ritrovi con molti dati sui dischi che potrebbero essere trascurati."

I ricercatori di Sandia hanno lavorato con gli studenti dell'Università dell'Illinois Urbana-Champaign, un partner dell'Academic Alliance, per sviluppare algoritmi analitici e decisionali per lo streaming di fonti di dati e integrarli in un framework di elaborazione dei dati distribuiti quasi in tempo reale utilizzando strumenti di big data e risorse informatiche presso Sandia. Il framework prende dati disparati da più fonti e genera informazioni utilizzabili su cui è possibile agire in tempo quasi reale.

Per testare il quadro, i ricercatori e gli studenti hanno utilizzato i dati sul traffico di Chicago come immagini, sensori integrati, tweet e testo in streaming per misurare con successo la congestione del traffico e suggerire percorsi di guida più veloci intorno ad esso per un pendolare di Chicago. Il team di ricerca ha selezionato l'esempio del traffico di Chicago perché i dati inseriti hanno caratteristiche simili ai dati tipicamente osservati per scopi di sicurezza nazionale, disse Rudy Garcia, un informatico Sandia e co-responsabile del progetto.

Affogando nei dati

"Creiamo dati senza nemmeno pensarci, " ha detto Laura Patrizi, un informatico di Sandia e membro del team di ricerca, durante una conferenza al simposio GEOINT della United States Geospatial Intelligence Foundation del 2019. "Quando andiamo in giro con il telefono in tasca o twittiamo sul traffico orribile, il nostro telefono sta tracciando la nostra posizione e può allegare una geolocalizzazione al nostro tweet."

Per sfruttare questa valanga di dati, gli analisti in genere utilizzano strumenti di big data e algoritmi di apprendimento automatico per trovare ed evidenziare informazioni significative, ma il processo viene eseguito su dati registrati, ha detto la mamma.

"Volevamo vedere cosa può essere analizzato con dati in tempo reale da più fonti di dati, non ciò che si può apprendere dall'estrazione di dati storici, "Ma ha detto. "L'intelligenza fruibile è il livello successivo dell'analisi dei dati in cui l'analisi viene utilizzata per prendere decisioni quasi in tempo reale. Il successo di questa ricerca avrà un forte impatto su molte applicazioni di sicurezza nazionale urgenti".

Costruire un framework per l'elaborazione dei dati

Il team ha impilato le tecnologie distribuite in una serie di pipeline di elaborazione dati che ingeriscono, curare e indicizzare i dati. Gli scienziati che hanno discusso i dati hanno specificato come le condutture dovrebbero acquisire e pulire i dati.

"Ogni tipo di dati che ingeriamo ha il proprio schema e formato di dati, " disse Garcia. "Affinché i dati siano utili, deve essere prima curato in modo che possa essere facilmente scoperto per un evento."

Piattaforma dati Hortonworks, in esecuzione sui computer di Sandia, è stato utilizzato come infrastruttura software per l'elaborazione dei dati e le pipeline analitiche. All'interno di Hortonworks, il team ha sviluppato e integrato topologie di Apache Storm per ciascuna pipeline di dati. I dati curati sono stati quindi archiviati in Apache Solr, un motore di ricerca aziendale e un database. PyTorch e Banana di Lucidwork sono stati utilizzati per il rilevamento degli oggetti dei veicoli e la visualizzazione dei dati.

Trovare i dati giusti

"Portare grandi quantità di dati è difficile, ma è ancora più difficile trovare le informazioni che stai veramente cercando, " ha detto Garcia. "Per esempio, durante il progetto avremmo visto tweet che dicevano qualcosa come "Il controllo del traffico aereo ci ha tenuti a terra per l'ultima ora a Midway". Il traffico è nel tweet, ma non è rilevante per il traffico autostradale."

Per determinare il livello di congestione del traffico su un'autostrada di Chicago, idealmente lo strumento potrebbe utilizzare una varietà di tipi di dati, inclusa una telecamera del traffico che mostra il flusso in entrambe le direzioni, tweet geolocalizzati su incidenti, sensori stradali che misurano la velocità media, immagini satellitari delle aree e dei segnali stradali che stimano i tempi di viaggio attuali tra i punti miliari, disse Forest Danford, un informatico di Sandia e membro del team di ricerca.

"Però, riceviamo anche molti dati errati come l'immagine di una webcam difficile da leggere, ed è raro che ci ritroviamo con molti tipi di dati diversi che sono strettamente collocati nel tempo e nello spazio, "Danford ha detto. "Avevamo bisogno di un meccanismo per apprendere sugli oltre 90 milioni di eventi (relativi al traffico di Chicago) che abbiamo osservato per essere in grado di prendere decisioni basate su informazioni incomplete o imperfette".

Il team ha aggiunto un classificatore di congestione del traffico addestrando sistemi informatici uniti modellati sul cervello umano su caratteristiche estratte da immagini e tweet etichettati, e altri eventi che corrispondevano ai dati nel tempo e nello spazio. Il classificatore addestrato è stato in grado di generare previsioni sulla congestione del traffico sulla base di dati operativi in un dato momento e luogo, ha detto Danford.

I professori Minh Do e Ramavarapu Sreenivas e i loro studenti all'UIUC hanno lavorato al riconoscimento di oggetti e immagini in tempo reale con l'imaging di webcam e hanno sviluppato solidi processi di pianificazione del percorso basati sulle varie fonti di dati.

"Sviluppare una scienza convincente per un'intelligenza fruibile richiede di essere alle prese con dinamiche basate sull'informazione, " Ha detto Sreenivas. "Il Santo Graal qui è quello di risolvere il problema delle specifiche. Abbiamo bisogno di sapere cosa vogliamo prima di costruire qualcosa che ci ottenga ciò che vogliamo. Questo è molto più difficile di quanto sembri, e questo progetto è il primo passo per capire esattamente cosa vorremmo avere".

Andando avanti, il team di Sandia sta trasferendo l'architettura, analisi e lezioni apprese a Chicago ad altri progetti governativi e continuerà a indagare sugli strumenti analitici, apportare miglioramenti al modello di riconoscimento degli oggetti dei laboratori e lavorare per generare, intelligenza attuabile.

"Stiamo cercando di rendere rilevabili i dati, accessibile e fruibile, " ha detto Garcia. "E se possiamo farlo attraverso queste architetture di big data, allora penso che stiamo aiutando."