Come robot, auto a guida autonoma e altre macchine intelligenti integrano l'intelligenza artificiale nella vita di tutti i giorni, un nuovo modo di progettare algoritmi può aiutare gli sviluppatori di machine learning a costruire misure di salvaguardia contro specifiche, risultati indesiderati come pregiudizi razziali e di genere. Attestazione:Deboki Chakravarti

L'intelligenza artificiale è entrata nel mainstream commerciale grazie alla crescente abilità degli algoritmi di apprendimento automatico che consentono ai computer di addestrarsi a fare cose come guidare automobili, controllare robot o automatizzare il processo decisionale.

Ma quando l'IA inizia a gestire compiti delicati, come aiutare a scegliere quali prigionieri ottenere la cauzione, i responsabili politici insistono sul fatto che gli scienziati informatici offrano garanzie che i sistemi automatizzati sono stati progettati per ridurre al minimo, se non evitarlo completamente, esiti indesiderati come rischi eccessivi o pregiudizi razziali e di genere.

Un team guidato da ricercatori di Stanford e dell'Università del Massachusetts Amherst ha pubblicato un documento il 22 novembre in Scienza suggerendo come fornire tali assicurazioni. Il documento delinea una nuova tecnica che traduce un obiettivo sfocato, come evitare pregiudizi di genere, nei precisi criteri matematici che consentirebbero a un algoritmo di apprendimento automatico di addestrare un'applicazione AI per evitare tale comportamento.

"Vogliamo promuovere un'IA che rispetti i valori dei suoi utenti umani e giustifichi la fiducia che riponiamo nei sistemi autonomi, " ha detto Emma Brunskill, un assistente professore di informatica a Stanford e autore senior del documento.

Evitare comportamenti scorretti

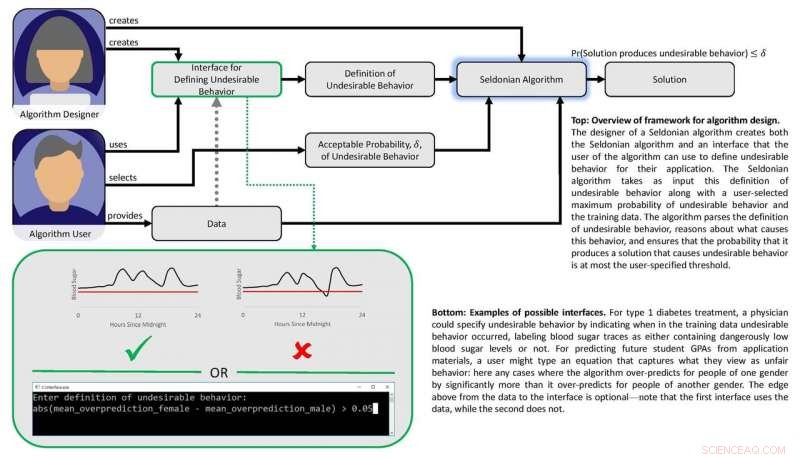

Il lavoro si basa sulla nozione che se risultati o comportamenti "non sicuri" o "sleali" possono essere definiti matematicamente, quindi dovrebbe essere possibile creare algoritmi in grado di apprendere dai dati come evitare questi risultati indesiderati con un'elevata sicurezza. I ricercatori volevano anche sviluppare una serie di tecniche che rendessero facile per gli utenti specificare quali tipi di comportamento indesiderato vogliono limitare e consentire ai progettisti di apprendimento automatico di prevedere con sicurezza che un sistema addestrato utilizzando dati passati può essere affidabile quando viene applicato in circostanze del mondo reale.

"Mostriamo come i progettisti di algoritmi di apprendimento automatico possono rendere più facile per le persone che desiderano integrare l'intelligenza artificiale nei loro prodotti e servizi descrivere risultati o comportamenti indesiderati che il sistema di intelligenza artificiale eviterà con alta probabilità, " disse Filippo Tommaso, un assistente professore di informatica presso l'Università del Massachusetts Amherst e primo autore dell'articolo.

Correttezza e sicurezza

I ricercatori hanno testato il loro approccio cercando di migliorare l'equità degli algoritmi che prevedono i GPA degli studenti universitari in base ai risultati degli esami, una pratica comune che può portare a pregiudizi di genere. Utilizzando un set di dati sperimentali, hanno dato al loro algoritmo istruzioni matematiche per evitare di sviluppare un metodo predittivo che sistematicamente sopravvalutasse o sottovalutasse i GPA per un genere. Con queste istruzioni, l'algoritmo ha identificato un modo migliore per prevedere i GPA degli studenti con pregiudizi di genere molto meno sistematici rispetto ai metodi esistenti. I metodi precedenti hanno avuto difficoltà in questo senso o perché non avevano un filtro di equità integrato o perché gli algoritmi sviluppati per ottenere l'equità erano di portata troppo limitata.

Il gruppo ha sviluppato un altro algoritmo e lo ha utilizzato per bilanciare sicurezza e prestazioni in una pompa per insulina automatizzata. Tali pompe devono decidere quanto grande o piccola è la dose di insulina da somministrare a un paziente durante i pasti. Idealmente, la pompa eroga l'insulina appena sufficiente per mantenere costanti i livelli di zucchero nel sangue. Troppa poca insulina fa aumentare i livelli di zucchero nel sangue, portando a disagi a breve termine come nausea, ed elevato rischio di complicanze a lungo termine, comprese le malattie cardiovascolari. Troppo e la glicemia crolla, un risultato potenzialmente mortale.

Diagramma raffigurante la struttura della carta. Credito:Philip Thomas

L'apprendimento automatico può aiutare identificando modelli sottili nelle risposte di zucchero nel sangue di un individuo alle dosi, ma i metodi esistenti non rendono facile per i medici specificare i risultati che gli algoritmi di dosaggio automatizzati dovrebbero evitare, come crolli di ipoglicemia. Utilizzando un simulatore di glucosio nel sangue, Brunskill e Thomas hanno mostrato come addestrare le pompe per identificare il dosaggio su misura per quella persona, evitando complicazioni da sovradosaggio o sottodosaggio. Sebbene il gruppo non sia pronto per testare questo algoritmo su persone reali, indica un approccio di intelligenza artificiale che potrebbe eventualmente migliorare la qualità della vita dei diabetici.

nella loro Scienza carta, Brunskill e Thomas usano il termine "algoritmo seldoniano" per definire il loro approccio, un riferimento a Hari Seldon, un personaggio inventato dall'autore di fantascienza Isaac Asimov, che una volta proclamò tre leggi della robotica iniziando con l'ingiunzione che "Un robot non può ferire un essere umano o, attraverso l'inazione, permettere a un essere umano di subire danni".

Pur riconoscendo che il campo è ancora lontano dal garantire le tre leggi, Thomas ha affermato che questo framework Seldonian renderà più facile per i progettisti di apprendimento automatico costruire istruzioni per evitare il comportamento in tutti i tipi di algoritmi, in un modo che possa consentire loro di valutare la probabilità che i sistemi addestrati funzioneranno correttamente nel mondo reale.

Brunskill ha affermato che questo framework proposto si basa sugli sforzi che molti scienziati informatici stanno facendo per trovare un equilibrio tra la creazione di potenti algoritmi e lo sviluppo di metodi per garantire la loro affidabilità.

"Pensare a come possiamo creare algoritmi che rispettino al meglio valori come la sicurezza e l'equità è essenziale poiché la società fa sempre più affidamento sull'IA, "Ha detto Brunskill.