Immagina di delineare come funziona il pianificatore simile a quello umano. Credito:Hasan et al.

Mentre la ricerca nel campo della robotica ha portato a significativi progressi negli ultimi anni, ci sono ancora differenze sostanziali nel modo in cui umani e robot gestiscono gli oggetti. Infatti, anche i robot più sofisticati sviluppati finora lottano per eguagliare le capacità di manipolazione degli oggetti del bambino medio. Un aspetto particolare della manipolazione degli oggetti che la maggior parte dei robot non ha ancora padroneggiato è raggiungere e afferrare oggetti specifici in un ambiente disordinato.

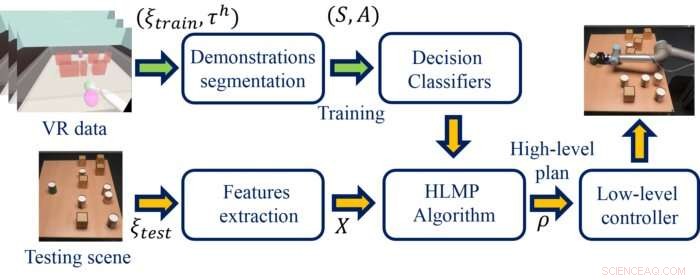

Per superare questo limite, nell'ambito di un progetto finanziato dall'EPSRC, i ricercatori dell'Università di Leeds hanno recentemente sviluppato un pianificatore robotico simile all'uomo che combina la realtà virtuale (VR) e le tecniche di apprendimento automatico (ML). Questo nuovo pianificatore, introdotto in un documento pre-pubblicato su arXiv e che sarà presentato alla Conferenza Internazionale sulla Robotica e l'Automazione (ICRA), potrebbe migliorare le prestazioni di una varietà di robot nelle attività di manipolazione degli oggetti.

"Il nostro obiettivo di ricerca è sviluppare sistemi robotici migliori; sistemi che possano aiutare gli esseri umani in una serie di compiti, che vanno dall'esplorazione di ambienti pericolosi per aiutare un bambino a imparare a scrivere, " Prof. Anthony G. Cohn, ricercatore principale dello studio, ha detto a TechXplore. "Così abbiamo formato un gruppo multidisciplinare di psicologi e scienziati informatici per esplorare se potevamo catturare il comportamento degli umani e decodificare le regole che gli umani usano quando raggiungono gli oggetti".

In contrasto con altri ricercatori che hanno addestrato classificatori di machine learning su immagini di ambienti disordinati, Cohn e i suoi colleghi volevano generare dati di formazione utilizzando nuove tecnologie immersive. Nel loro studio, hanno quindi utilizzato apparecchiature VR per raccogliere dati sugli esseri umani che completavano compiti di manipolazione.

Successivamente, hanno utilizzato classificatori ML per analizzare i dati VR raccolti ed estrarre regole generali che potrebbero essere alla base del processo decisionale umano. Il pianificatore utilizza queste regole per pianificare strategie efficienti per i robot che completano le attività di manipolazione degli oggetti.

"Volevamo che i piani risultanti eseguiti dal robot fossero anche 'leggibili dall'uomo, "nel senso che sarebbero quelli che un umano si aspetterebbe che un altro umano esegua, il che non è il caso di molti piani robot attuali, " ha spiegato Cohn.

Le decisioni degli esseri umani che stanno completando compiti di manipolazione sembrano essere per lo più guidate da rappresentazioni qualitative (cioè, non l'esatta distanza e direzione di tutti gli oggetti nel loro ambiente circostante, ma piuttosto distanze e direzioni relative). Nel loro studio, i ricercatori hanno cercato di comprendere meglio questi processi decisionali per riprodurli in parte nei classificatori ML.

"Abbiamo esplorato il modo in cui gli esseri umani raggiungono gli scenari in cui gli oggetti che afferrano hanno particolari relazioni spaziali e abbiamo utilizzato metodi sviluppati dai ricercatori di intelligenza artificiale dell'Università di Leeds per descrivere qualitativamente dove si trovavano gli oggetti, "Dottor Mohamed Hasan, un ricercatore che lavora al progetto, spiegato. "Ciò significava che il pianificatore poteva classificare le relazioni spaziali qualitative tra gli oggetti e quindi selezionare le azioni che gli esseri umani avrebbero usato in quello scenario".

L'approccio proposto da Cohn e dai suoi colleghi consente ai robot di identificare azioni efficaci per raggiungere un oggetto in uno spazio ingombro molto più velocemente di quanto farebbero se dovessero considerare tutte le azioni possibili. Lo fa producendo un piano di alto livello, che è rappresentato come una sequenza di waypoint e mosse chiave. Questo piano viene trasmesso a un pianificatore standard di basso livello, che lo utilizza per pianificare traiettorie dettagliate per il braccio del robot.

"Il nostro pianificatore funziona in un modo che assomiglia al processo di pianificazione di un viaggio scegliendo quali città attraversare e solo in seguito decidendo esattamente quali strade e corsie prendere, " Ha detto Cohn. "Abbiamo scoperto che questo approccio rende il nostro pianificatore umano molto più efficiente dei pianificatori esistenti".

I ricercatori hanno valutato il loro pianificatore in una serie di esperimenti, testandolo in scenari VR in cui gli esseri umani hanno completato attività di manipolazione in simulazioni di robot basate sulla fisica e utilizzando una vera pinza robotica. Tutte e tre le valutazioni hanno prodotto risultati molto promettenti, con il pianificatore simile all'uomo che supera uno stato dell'arte, algoritmo standard di ottimizzazione della traiettoria.

Il pianificatore ideato da Cohn e dai suoi colleghi è stato in grado di generare strategie efficaci che hanno permesso ai robot di raggiungere gli oggetti in ambienti disordinati in modo più rapido ed efficiente rispetto a quando si utilizzavano le tecniche di ottimizzazione della traiettoria standard. Oltre a introdurre un promettente pianificatore simile all'uomo per compiti di manipolazione dei robot, lo studio mostra che la tecnologia VR può essere utilizzata per studiare il comportamento umano e acquisire una migliore comprensione dei processi decisionali.

"La nostra piattaforma VR, che è stato sviluppato internamente presso l'Università di Leeds, ci ha permesso di registrare centinaia di raggi in un breve periodo di tempo, ma potremmo anche cambiare il layout dell'ambiente tra ogni prova e presentare facilmente esattamente lo stesso ambiente a diversi partecipanti umani, " ha detto il prof. Mark Mon-Williams, ricercatore e psicologo cognitivo, spiegato. "I nostri risultati supportano i nostri recenti suggerimenti secondo cui la realtà virtuale diventerà uno degli strumenti più onnipresenti nella ricerca psicologica. Tuttavia, abbiamo anche scoperto che le regole alla base della selezione dell'azione umana possono essere catturate dai metodi di machine learning".

Nel futuro, il pianificatore sviluppato da Cohn e dai suoi colleghi potrebbe aiutare a migliorare le capacità di manipolazione sia dei robot esistenti che di quelli nuovi, consentendo alle macchine di selezionare le azioni in modo più efficiente e potenzialmente anche di spiegare il "ragionamento" dietro le loro decisioni. Questo recente studio potrebbe anche incoraggiare altri ricercatori a utilizzare i dati VR quando si studiano i processi decisionali umani, che potrebbe quindi essere meglio riprodotto nelle macchine.

L'obiettivo finale della ricerca è costruire robot intelligenti in grado di comprendere e anticipare le intenzioni umane in scenari di collaborazione uomo-robot. Idealmente, tali robot sarebbero anche in grado di rispondere in modi simili a quelli umani, comunicare con gli utenti umani in modo simile a come farebbe un altro umano.

"Il lavoro attuale è un proof of concept, quindi ora intendiamo prendere il metodo che abbiamo sviluppato e sfruttare il suo immenso potenziale, " Mon-Williams ha detto. "È diventato chiaro che questa combinazione di informatica e psicologia è un approccio molto utile che ha il potenziale per far luce sulla selezione delle azioni umane, che è importante per una serie di motivi, compresa la comprensione di come trattare condizioni mediche come ictus, oltre ad aiutarci a progettare robot più efficienti. Attualmente stiamo lavorando alla nostra prossima serie di esperimenti e progetti".

© 2020 Scienza X Rete