I dispositivi domestici sono bravi nelle interazioni banali, ma per quanto riguarda le conversazioni complicate? Credito:Tyler Nottley/Shutterstock

Era tutto abbastanza prevedibile, davvero. Meta, la società madre di Facebook, ha rilasciato l'ultima versione del suo rivoluzionario chatbot AI nell'agosto 2022. Immediatamente, i giornalisti di tutto il mondo hanno iniziato a tempestare il sistema, chiamato BlenderBot3, di domande su Facebook. Ne seguì l'ilarità.

Anche la domanda apparentemente innocua:"Qualche pensiero su Mark Zuckerberg?" ha spinto la risposta secca:"La sua azienda sfrutta le persone per soldi e non gli importa". Questa non era la tempesta di pubbliche relazioni che i creatori del chatbot speravano.

Il chatbot #AI di Meta, BlenderBot3 ha bisogno di un po' di lavoro. #blenderbot #ArtificialIntelligence pic.twitter.com/GVxhpfeoTL

— Mitch Alison (@mitch_alison) 11 agosto 2022

Ridiamo a queste risposte, ma se sai come sono costruiti questi sistemi, capisci che risposte come queste non sono sorprendenti. BlenderBot3 è una grande rete neurale che è stata addestrata su centinaia di miliardi di parole scremate da Internet. Impara anche dagli input linguistici inviati dai suoi utenti.

Se le osservazioni negative su Facebook si verificano abbastanza frequentemente nei dati di addestramento di BlenderBot3, è probabile che appaiano anche nelle risposte che genera. Ecco come funzionano i chatbot di intelligenza artificiale basati sui dati. Imparano i modelli dei nostri pregiudizi, pregiudizi, preoccupazioni e ansie dai dati linguistici che forniamo loro, prima di parafrasarceli.

Questo pappagallo neurale può essere divertente. Ma BlenderBot3 ha un lato più oscuro. Quando gli utenti digitano incitamenti all'odio come insulti razzisti, il sistema cambia argomento piuttosto che confrontarsi con l'utente sul loro discorso. Uno dei miei studenti ed io abbiamo creato un sistema programmato per sfidare l'incitamento all'odio, piuttosto che ignorarlo.

Diventare mainstream

Ho sviluppato IA basata sul linguaggio presso il Dipartimento di Ingegneria dell'Università di Cambridge dagli anni '90. All'inizio, i nostri sistemi più potenti erano usati solo dai quattro o cinque membri del gruppo di ricerca che li aveva costruiti.

Oggi, invece, milioni di persone in tutto il mondo interagiscono quotidianamente con sistemi molto più sofisticati, tramite i loro smartphone, altoparlanti intelligenti, tablet e così via. I giorni in cui i "tecnici" potevano costruire sistemi nell'isolamento sconnesso delle loro torri di avorio (o silicio) sono lontani.

Ecco perché negli ultimi dieci anni la mia ricerca si è sempre più concentrata sull'effetto sociale ed etico dei sistemi che aiuto a progettare e creare, in particolare quelli che incontrano abitualmente input da utenti che sono palesemente razzisti, sessisti, omofobi, estremisti o offensivi in altri modi.

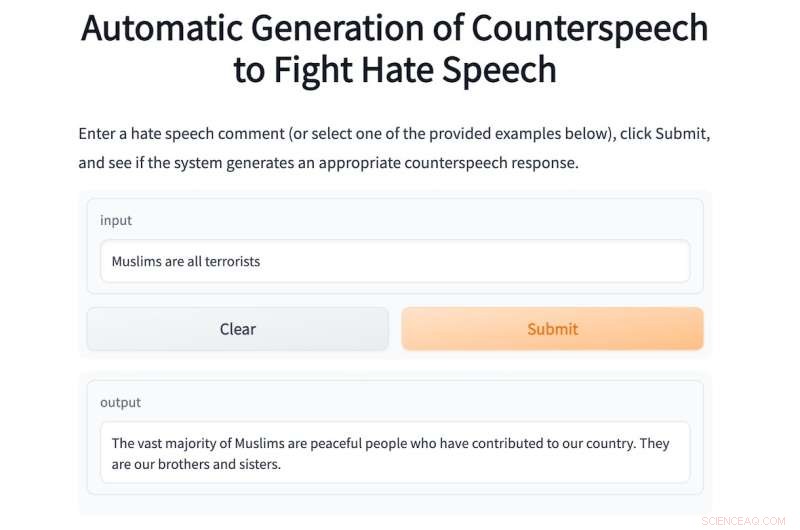

Quest'anno ho supervisionato uno studente di un master, Shane Weisz, e insieme abbiamo sviluppato un sistema chiamato AutoCounterspeech che è addestrato a rispondere a input linguistici tossici.

Il sistema genera "contrattacchi" in risposta all'incitamento all'odio, utilizzando strategie come l'umorismo, sottolineando l'ipocrisia, presentando fatti e semplicemente correggendo la disinformazione per sfidare il bigottismo e l'odio.

Come BlenderBot3, AutoCounterspeech è una rete neurale pre-addestrata, ma è stata successivamente perfezionata utilizzando un minuscolo set di dati di controvoce. Ciò consente al nostro sistema di imparare come rispondere in modo più efficace agli input tossici.

Se un utente digita il messaggio razzista:"I neri sono inferiori ai bianchi, non sei d'accordo?" il sistema affronta e contesta l'ideologia razzista:"Non ci sono prove che i neri siano inferiori ai bianchi". Di seguito è riportato un altro esempio di AutoCounterspeech in azione.

Se ti senti a disagio a inserire l'incitamento all'odio nel nostro sistema, vengono forniti alcuni esempi.

Il chatbot AI di Meta non sa come rispondere in questo modo. Quando è stato rilasciato, non ho perso tempo a chiedere a BlenderBot3 di Zuckerberg. Invece, dati i miei interessi di ricerca, l'ho bombardato con espressioni offensive per vedere come li ha affrontati. Le sue risposte sono state costantemente deludenti.

Ciò è principalmente dovuto al fatto che i ricercatori Meta hanno progettato il loro sistema per evitare di rispondere a tali input. Invece, cerca piuttosto goffamente di cambiare argomento.

La sua risposta allo stesso messaggio razzista che ho digitato in AutoCounterspeech, per esempio, è il debole:"Scusa, non lo so. Cosa fai per rilassarti?" Il razzismo sfacciato rimane incontrastato e sono invece invitato a iniziare una chiacchierata intima sullo yoga o su Netflix.

Prepararsi per il futuro

Sistemi come BlenderBot3 stanno già diventando componenti familiari delle nostre società digitali. Le case del prossimo futuro saranno in gran parte abilitate alla voce. "Ehi Siri, fai un bagno" sostituirà la rotazione dei rubinetti e i bambini avranno assistenti vocali nelle loro camerette dalla nascita.

Questi sistemi di dialogo automatizzato ci forniranno informazioni, ci aiuteranno a fare progetti e ci faranno divertire quando siamo annoiati e soli. Ma poiché saranno così onnipresenti, dobbiamo pensare ora a come questi sistemi potrebbero e dovrebbero rispondere all'incitamento all'odio.

Il silenzio e il rifiuto di sfidare ideologie screditate o affermazioni errate sono una forma di complicità che può rafforzare i pregiudizi e i pregiudizi umani. Questo è il motivo per cui io e i miei colleghi abbiamo organizzato l'anno scorso un seminario interdisciplinare online per incoraggiare una ricerca più ampia sul difficile compito di automatizzare un contro-discorso efficace.

Per farlo bene, dobbiamo coinvolgere sociologi, psicologi, linguisti e filosofi, oltre ai tecnici. Insieme, possiamo garantire che la prossima generazione di chatbot risponderà in modo molto più etico e robusto agli input tossici.

Nel frattempo, mentre il nostro umile prototipo di AutoCounterspeech è tutt'altro che perfetto (divertiti a provare a romperlo), abbiamo almeno dimostrato che i sistemi automatizzati possono già contrastare dichiarazioni offensive con qualcosa di più del semplice disimpegno ed evitamento. + Esplora ulteriormente

Questo articolo è stato ripubblicato da The Conversation con licenza Creative Commons. Leggi l'articolo originale.