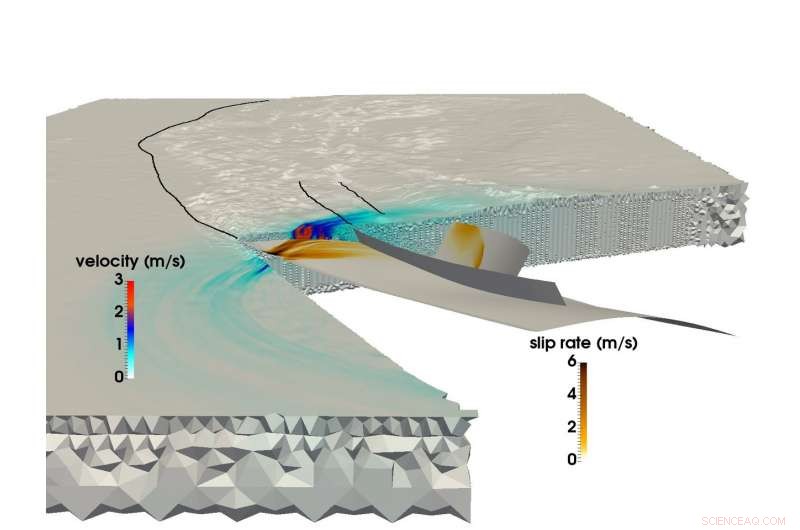

Usando il supercomputer SuperMUC di LRZ, un gruppo di ricerca congiunto dell'Università tecnica di Monaco e Ludwigs-Maximilians-Uni Munich è stato in grado di creare la più grande simulazione multifisica di un terremoto e di uno tsunami. Questa immagine mostra la propagazione della rottura e il risultante campo di onde sismiche durante il terremoto di Sumatra-Andaman del 2004. Credito:C. Uphoff, S. Rettenberger, M. Bader, Università tecnica di Monaco di Baviera. E. Madden, T. Ulrich, S. Wollherr, A. Gabriele, Ludwigs-Maximilians-Universität.

Poco prima delle 8:00 ora locale del 26 dicembre, 2004, le persone nel sud-est asiatico stavano iniziando i loro giorni quando il terzo terremoto più forte registrato nella storia ha strappato un 1, Strappo di 500 chilometri nel fondo dell'oceano al largo dell'isola indonesiana di Sumatra.

Il terremoto è durato tra gli 8 e i 10 minuti (uno dei più lunghi mai registrati), e sollevò di parecchi metri il fondo dell'oceano, creando uno tsunami con onde di 30 metri che ha devastato intere comunità. L'evento ha causato quasi 200, 000 decessi in 15 paesi, e ha rilasciato tanta energia sopra e sotto terra come molti secoli di utilizzo di energia negli Stati Uniti.

Il terremoto di Sumatra-Andaman, come viene chiamato, era tanto sorprendente quanto violento. Nonostante i grandi progressi nel monitoraggio e nei sistemi di allerta sismici negli ultimi 50 anni, gli scienziati della terra non sono stati in grado di prevederlo perché esistono relativamente pochi dati su tali eventi sismologici su larga scala. I ricercatori hanno una grande quantità di informazioni relative a semi-regolari, terremoti di intensità medio-bassa, ma disastri come il Sumatra-Andaman, eventi che accadono solo ogni duecento anni, sono troppo rari per creare set di dati affidabili.

Per comprendere più a fondo questi eventi, e, si spera, fornire migliori metodi di previsione e mitigazione, un team di ricercatori della Ludwig-Maximilians-Universität Munich (LMU) e della Technical University of Munich (TUM) sta utilizzando risorse di supercalcolo presso il Leibniz Supercomputing Center (LRZ) per comprendere meglio questi rari, fenomeni sismici estremamente pericolosi.

"La nostra motivazione generale è quella di comprendere meglio l'intero processo del perché alcuni terremoti e tsunami risultanti sono molto più grandi di altri, " ha affermato il professor TUM Dr. Michael Bader. "A volte vediamo tsunami relativamente piccoli quando i terremoti sono grandi, o tsunami sorprendentemente grandi collegati a terremoti relativamente piccoli. La simulazione è uno degli strumenti per ottenere informazioni su questi eventi".

Il team si impegna per simulazioni "accoppiate" sia dei terremoti che dei successivi tsunami. Ha recentemente completato la sua più grande simulazione di terremoto finora. Usando il supercomputer SuperMUC a LRZ, il team è stato in grado di simulare 1, 500 chilometri di meccanica della frattura non lineare - la fonte del terremoto - accoppiata alle onde sismiche che viaggiano fino all'India e alla Thailandia in poco più di 8 minuti del terremoto di Sumatra-Andaman. Attraverso diverse innovazioni computazionali interne, il team ha ottenuto un miglioramento di 13 volte nel tempo alla soluzione. In riconoscimento di questo risultato, il progetto è stato nominato per il miglior premio cartaceo a SC17, una delle conferenze di supercalcolo più importanti al mondo, tenutasi quest'anno dal 12 al 17 novembre a Denver, Colorado.

Terremoti megaspinti, simulazioni su larga scala

I terremoti si verificano quando la roccia sotto la superficie terrestre si rompe improvvisamente, spesso a causa del lento movimento delle placche tettoniche.

Un indicatore approssimativo della capacità di un terremoto oceanico di scatenare un grande tsunami è se le placche si sfregano l'una contro l'altra o si scontrano frontalmente. Se due o più placche si scontrano, una piastra spesso costringerà l'altra sotto di essa. Le regioni in cui si verifica questo processo sono chiamate zone di subduzione e possono ospitare aree molto grandi, faglie che si abbassano superficialmente, le cosiddette "megaspinte". Il rilascio di energia in zone così deboli tende a creare violenti tsunami, poiché il fondale oceanico si alza di una quantità significativa, spostando temporaneamente grandi quantità di acqua.

Fino a poco tempo fa, anche se, i ricercatori che si occupano di geofisica computazionale hanno avuto grandi difficoltà a simulare i terremoti di subduzione al livello di dettaglio e accuratezza necessari. Le simulazioni di terremoti su larga scala sono generalmente difficili, ma gli eventi di subduzione sono ancora più complessi.

"La modellazione dei terremoti è un problema multiscala sia nello spazio che nel tempo, " ha detto la dottoressa Alice Gabriel, il ricercatore capo dal lato LMU del team. "La realtà è complessa, il che significa che incorporare la complessità osservata delle sorgenti sismiche implica invariabilmente l'uso di metodi numerici, software di simulazione altamente efficiente, e, Certo, calcolo ad alte prestazioni (HPC). Solo sfruttando l'HPC possiamo creare modelli in grado di risolvere sia il rilascio dinamico dello stress che le rotture che si verificano con un terremoto, simulando allo stesso tempo lo spostamento del fondo marino per migliaia di chilometri".

Quando i ricercatori simulano un terremoto, usano una griglia computazionale per dividere la simulazione in tanti piccoli pezzi. Quindi calcolano equazioni specifiche per vari aspetti della simulazione, come lo scuotimento sismico generato o lo spostamento del fondo oceanico, tra gli altri, su "passi temporali, " o istantanee di simulazione nel tempo che aiutano a metterlo in moto, molto simile a un libro a fogli mobili.

Più fine è la griglia, più accurata è la simulazione, ma più diventa computazionalmente impegnativo. Inoltre, quanto più complessa è la geometria del terremoto, più complessa diventa la griglia, complicando ulteriormente il calcolo. Per simulare terremoti di subduzione, gli scienziati computazionali devono creare una grande griglia che possa anche rappresentare accuratamente gli angoli molto superficiali ai quali le due placche continentali si incontrano. Ciò richiede che le celle della griglia attorno all'area di subduzione siano molto piccole, e spesso di forma snella.

A differenza dei terremoti continentali, che sono stati meglio documentati attraverso il calcolo e l'osservazione, gli eventi di subduzione spesso accadono nelle profondità dell'oceano, il che significa che è molto più difficile vincolare una simulazione da osservazioni di scuotimento del terreno e da dettagliate, dati affidabili da osservazione diretta ed esperimenti di laboratorio.

Per di più, calcolo di un accoppiato, la simulazione di terremoti e tsunami su larga scala richiede l'utilizzo di dati provenienti da un'ampia varietà di fonti. I ricercatori devono tenere conto della forma del fondale marino, la forma e la forza del confine delle placche rotto dal terremoto e il comportamento materiale della crosta terrestre ad ogni livello, tra gli altri aspetti. Il team ha trascorso gli ultimi anni a sviluppare metodi per integrare in modo più efficiente queste diverse fonti di dati in un modello coerente.

Per ridurre l'enorme tempo di calcolo, il team ha sfruttato un metodo chiamato "local time stepping". Nelle aree in cui le simulazioni richiedono molti più dettagli spaziali, i ricercatori devono anche "rallentare" la simulazione eseguendo più passaggi temporali in queste aree. Altre sezioni che richiedono meno dettagli possono eseguire passaggi di tempo molto più grandi e quindi di gran lunga inferiori.

Se il team dovesse eseguire l'intera simulazione con un piccolo passo temporale uniforme, avrebbe richiesto circa 3 milioni di singole iterazioni. Però, solo poche celle della griglia computazionale hanno richiesto questa dimensione del passo temporale. Le parti principali potrebbero essere calcolate con passi temporali molto più grandi, alcuni richiedono solo 3000 passaggi temporali. Ciò ha ridotto significativamente la domanda di calcolo e ha portato a gran parte dell'accelerazione di 13 volte del team. Questo progresso ha anche portato la simulazione del team ad essere la più grande, simulazione dei primi principi più lunga di un terremoto di questo tipo.

Movimento in avanti

Grazie alla stretta collaborazione con lo staff LRZ, il team ha avuto l'opportunità di utilizzare l'intera macchina SuperMUC per le sue simulazioni. Bader ha indicato che queste serie su larga scala sono inestimabili per il team per ottenere informazioni più approfondite nella sua ricerca. "C'è una grande differenza se si esegue su un quarto di una macchina o una macchina completa, poiché quest'ultimo fattore di 4 spesso rivela i colli di bottiglia critici, " Egli ha detto.

La capacità del team di sfruttare appieno le risorse di supercalcolo della generazione attuale ha entusiasmato il futuro. Non è necessariamente importante che le macchine di nuova generazione offrano l'opportunità ai ricercatori LMU-TUM di eseguire simulazioni "più grandi":le simulazioni attuali possono simulare efficacemente un'area geografica sufficientemente ampia. Piuttosto, il team è entusiasta dell'opportunità di modificare i dati di input ed eseguire molte più iterazioni durante un determinato periodo di tempo di elaborazione.

"Abbiamo fatto una simulazione individuale, cercando di indovinare con precisione la configurazione di partenza, come le sollecitazioni e le forze iniziali, ma tutto questo è ancora incerto, "Bader ha detto. "Quindi vorremmo eseguire la nostra simulazione con molte impostazioni diverse per vedere come lievi cambiamenti nel sistema di guasto o altri fattori avrebbero un impatto sullo studio. Questi sarebbero studi di parametri più ampi, che è un altro livello di prestazioni che un computer dovrebbe fornire."

Gabriel ha anche detto che si spera che le macchine di prossima generazione saranno in grado di simulare problemi urgenti, scenari in tempo reale che possono aiutare a prevedere i pericoli in relazione a probabili regioni di scosse di assestamento. Il team è entusiasta di vedere le architetture di nuova generazione presso LRZ e gli altri centri Gauss Center for Supercomputing, il centro di calcolo ad alte prestazioni di Stoccarda e il centro di supercalcolo Jülich.

Secondo Bader, il recente lavoro del team non rappresenta solo la sua simulazione su più ampia scala fino ad oggi, ma anche la sempre più forte collaborazione tra gli scienziati del dominio e gli scienziati computazionali del gruppo. "Questo documento ha una forte componente sismologica e una forte componente HPC, " ha detto. "Questa è davvero una carta 50-50 per noi. La nostra collaborazione sta andando bene, ed è perché non si tratta di ottenere il nostro o il loro. Entrambi i gruppi traggono profitto, e questo è davvero un bel lavoro congiunto."