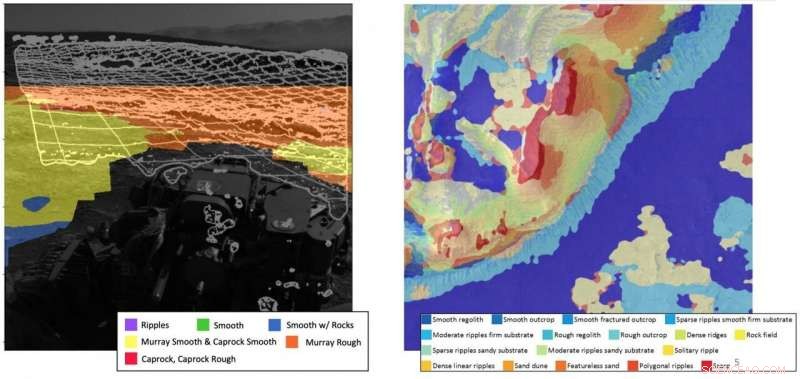

Il programma MAARS (Machine Learning-based Analytics for Autonomous Rover Systems) comprende una serie di aree in cui l'intelligenza artificiale potrebbe essere utile. Il team ha presentato i risultati del progetto MAARS alla IEEE Aerospace Conference nel marzo 2020. Il progetto è stato finalista per il NASA Software Award. Credito:NASA JPL

I rover su Marte della NASA sono stati uno dei grandi successi scientifici e spaziali degli ultimi due decenni.

Quattro generazioni di rover hanno attraversato il pianeta rosso raccogliendo dati scientifici, rimandando fotografie evocative, e sopravvivere a condizioni incredibilmente dure, il tutto utilizzando computer di bordo meno potenti di un iPhone 1. L'ultimo rover, Perseveranza, è stato lanciato il 30 luglio, 2020, e gli ingegneri stanno già sognando una futura generazione di rover.

Mentre un risultato importante, queste missioni hanno solo scalfito la superficie (letteralmente e figurativamente) del pianeta e della sua geologia, geografia, e atmosfera.

"La superficie di Marte è approssimativamente la stessa della superficie totale della terra sulla Terra, " disse Masahiro (Hiro) Ono, capogruppo del Robotic Surface Mobility Group presso il Jet Propulsion Laboratory (JPL) della NASA, che ha guidato tutte le missioni del rover su Marte, e uno dei ricercatori che ha sviluppato il software che consente il funzionamento dell'attuale rover.

"Immaginare, sei un alieno e non sai quasi nulla della Terra, e atterri su sette o otto punti sulla Terra e percorri poche centinaia di chilometri. Quella specie aliena sa abbastanza della Terra?" chiese Ono. "No. Se vogliamo rappresentare l'enorme diversità di Marte avremo bisogno di più misurazioni a terra, e la chiave è sostanzialmente a distanza estesa, si spera coprendo migliaia di miglia."

Viaggiando attraverso le diverse varietà di Marte, terreno insidioso con una potenza di calcolo limitata e una dieta energetica limitata:solo il sole che il rover può catturare e convertire in energia in un solo giorno marziano, o sol—è una sfida enorme.

Il primo rover, viaggiatore, coperto 330 piedi su 91 sol; il secondo, Spirito, ha percorso 4,8 miglia in circa cinque anni; Opportunità, ha percorso 28 miglia in 15 anni; e Curiosity ha percorso più di 12 miglia da quando è atterrato nel 2012.

"Il nostro team sta lavorando sull'autonomia dei robot su Marte per rendere i futuri rover più intelligenti, per aumentare la sicurezza, per migliorare la produttività, e in particolare per guidare più velocemente e più lontano, " ha detto Ono.

Nuovo hardware, Nuove possibilità

Il rover Perseveranza, lanciata quest'estate, elabora utilizzando RAD 750, computer a scheda singola resistenti alle radiazioni prodotti da BAE Systems Electronics.

missioni future, però, utilizzerebbe potenzialmente nuove prestazioni elevate, processori multi-core resistenti alle radiazioni progettati attraverso il progetto High Performance Spaceflight Computing (HPSC). (Anche il processore Snapdragon di Qualcomm è stato testato per le missioni.) Questi chip forniranno circa cento volte la capacità di calcolo degli attuali processori di volo utilizzando la stessa quantità di energia.

"Tutta l'autonomia che vedi sul nostro ultimo rover su Marte è in gran parte human-in-the-loop", il che significa che richiede l'interazione umana per funzionare, secondo Chris Mattmann, il vicedirettore della tecnologia e dell'innovazione presso JPL. "Parte del motivo sono i limiti dei processori in esecuzione su di essi. Una delle missioni principali di questi nuovi chip è l'apprendimento profondo e l'apprendimento automatico, come facciamo noi terrestri, a bordo. Quali sono le app killer dato quel nuovo ambiente informatico?"

Il programma MAARS (Machine Learning-based Analytics for Autonomous Rover Systems), iniziato tre anni fa e che si concluderà quest'anno, abbraccia una serie di aree in cui l'intelligenza artificiale potrebbe essere utile. Il team ha presentato i risultati del progetto MAARS alla hIEEE Aerospace Conference nel marzo 2020. Il progetto è stato finalista per il NASA Software Award.

"Il calcolo terrestre ad alte prestazioni ha consentito incredibili scoperte nella navigazione autonoma dei veicoli, apprendimento automatico, e analisi dei dati per applicazioni terrestri, " Il team ha scritto nel loro articolo IEEE. "Il principale ostacolo all'esplorazione di Marte di tali progressi è che i migliori computer sono sulla Terra, mentre i dati più preziosi si trovano su Marte".

Addestramento di modelli di machine learning sul supercomputer Maverick2 presso il Texas Advanced Computing Center (TACC), così come su Amazon Web Services e cluster JPL, Ono, Mattmann e il loro team hanno sviluppato due nuove funzionalità per i futuri rover su Marte, che chiamano Drive-By Science e Energy-Optimal Autonomous Navigation.

Navigazione autonoma ottimale dal punto di vista energetico

Ono faceva parte del team che ha scritto il software di ricerca percorsi integrato per Perseverance. Il software di Perseverance include alcune capacità di apprendimento automatico, ma il modo in cui fa il percorso è ancora abbastanza ingenuo.

"Vorremmo che i futuri rover avessero una capacità simile a quella umana di vedere e comprendere il terreno, " disse Ono. "Per i rover, l'energia è molto importante. Non ci sono strade asfaltate su Marte. La guidabilità varia sostanzialmente in base al terreno, ad esempio spiaggia rispetto a. roccia di fondo. Questo non è attualmente considerato. Trovare un percorso con tutti questi vincoli è complicato, ma questo è il livello di calcolo che possiamo gestire con i chip HPSC o Snapdragon. But to do so we're going to need to change the paradigm a little bit."

Ono explains that new paradigm as commanding by policy, a middle ground between the human-dictated:"Go from A to B and do C, " and the purely autonomous:"Go do science."

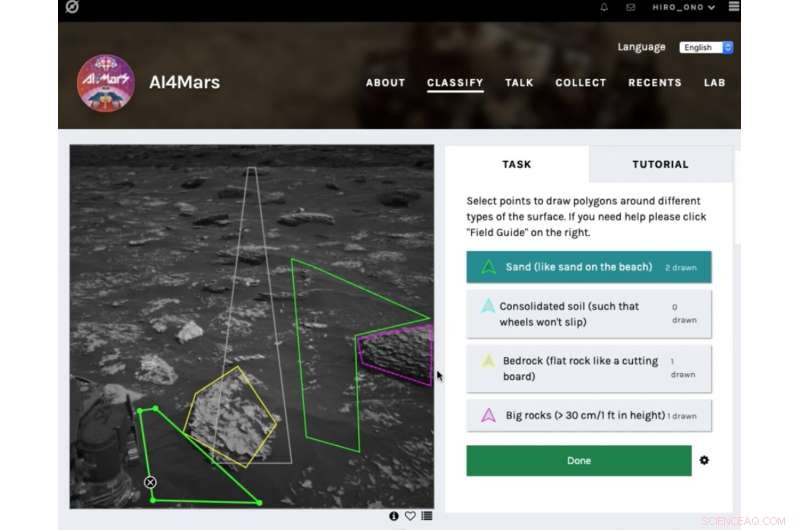

The public tool AI4Mars shows different kinds of Martian terrain as seen by NASA's Curiosity rover. By drawing borders around terrain features and assigning one of four labels to them, users can help train an algorithm that will automatically identify favorable and hazardous terrain for Curiosity's rover planners. Credito:NASA/JPL-Caltech

Commanding by policy involves pre-planning for a range of scenarios, and then allowing the rover to determine what conditions it is encountering and what it should do.

"We use a supercomputer on the ground, where we have infinite computational resources like those at TACC, to develop a plan where a policy is:if X, then do this; if y, then do that, " Ono explained. "We'll basically make a huge to-do list and send gigabytes of data to the rover, compressing it in huge tables. Then we'll use the increased power of the rover to de-compress the policy and execute it."

The pre-planned list is generated using machine learning-derived optimizations. The on-board chip can then use those plans to perform inference:taking the inputs from its environment and plugging them into the pre-trained model. The inference tasks are computationally much easier and can be computed on a chip like those that may accompany future rovers to Mars.

"The rover has the flexibility of changing the plan on board instead of just sticking to a sequence of pre-planned options, " Ono said. "This is important in case something bad happens or it finds something interesting."

Drive-By Science

Current Mars missions typically use tens of images a Sol from the rover to decide what to do the next day, according to Mattmann. "But what if in the future we could use one million image captions instead? That's the core tenet of Drive-By Science, " he said. "If the rover can return text labels and captions that were scientifically validated, our mission team would have a lot more to go on."

Mattmann and the team adapted Google's Show and Tell software—a neural image caption generator first launched in 2014—for the rover missions, the first non-Google application of the technology.

The algorithm takes in images and spits out human-readable captions. These include basic, but critical information, like cardinality—how many rocks, how far away?—and properties like the vein structure in outcrops near bedrock. "The types of science knowledge that we currently use images for to decide what's interesting, " Mattmann said.

Negli ultimi anni, planetary geologists have labeled and curated Mars-specific image annotations to train the model.

"We use the one million captions to find 100 more important things, " Mattmann said. "Using search and information retrieval capabilities, we can prioritize targets. Humans are still in the loop, but they're getting much more information and are able to search it a lot faster."

Results of the team's work appear in the September 2020 issue of Scienze planetarie e spaziali .

TACC's supercomputers proved instrumental in helping the JPL team test the system. On Maverick 2, the team trained, validated, and improved their model using 6, 700 labels created by experts.

The ability to travel much farther would be a necessity for future Mars rovers. An example is the Sample Fetch Rover, proposed to be developed by the European Space Association and launched in late 2020s, whose main task will be to pick up samples dug up by the Mars 2020 rover and collect them.

"Those rovers in a period of years would have to drive 10 times further than previous rovers to collect all the samples and to get them to a rendezvous site, " Mattmann said. "We'll need to be smarter about the way we drive and use energy."

Before the new models and algorithms are loaded onto a rover destined for space, they are tested on a dirt training ground next to JPL that serves as an Earth-based analog for the surface of Mars.

The team developed a demonstration that shows an overhead map, streaming images collected by the rover, and the algorithms running live on the rover, and then exposes the rover doing terrain classification and captioning on board. They had hoped to finish testing the new system this spring, but COVID-19 shuttered the lab and delayed testing.

Intanto, Ono and his team developed a citizen science app, AI4Mars, that allows the public to annotate more than 20, 000 images taken by the Curiosity rover. These will be used to further train machine learning algorithms to identify and avoid hazardous terrains.

The public have generated 170, 000 labels so far in less than three months. "People are excited. It's an opportunity for people to help, " Ono said. "The labels that people create will help us make the rover safer."

The efforts to develop a new AI-based paradigm for future autonomous missions can be applied not just to rovers but to any autonomous space mission, from orbiters to fly-bys to interstellar probes, Ono says.

"The combination of more powerful on-board computing power, pre-planned commands computed on high performance computers like those at TACC, and new algorithms has the potential to allow future rovers to travel much further and do more science."