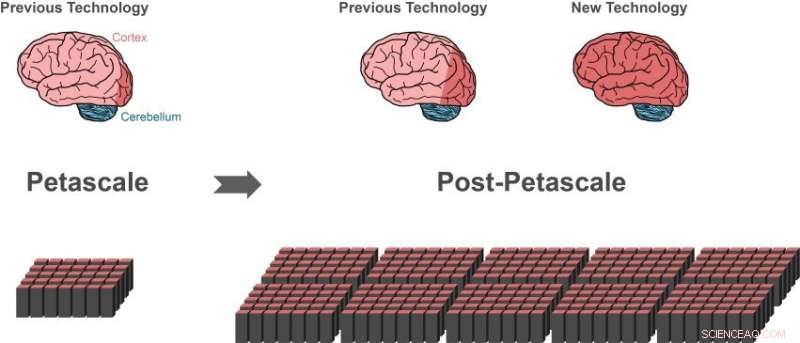

La precedente tecnologia di simulazione può rappresentare circa l'1% delle cellule nervose (neuroni) in un cervello umano (area rosso scuro del cervello a sinistra) utilizzando un supercomputer a petascala (in basso a sinistra). Solo piccoli progressi (area rosso scuro del centro del cervello) sarebbero possibili sulla prossima generazione di supercomputer che supereranno le prestazioni dei supercomputer di fascia alta di oggi da 10 a 100 volte. Parti più grandi del cervello umano possono essere rappresentate con la nuova tecnologia, utilizzando la stessa quantità di memoria del computer (in basso a destra).i Il 10% del cervello ha approssimativamente le dimensioni dell'intera corteccia (area del cervello rosso scuro a destra), che è essenziale per l'elaborazione superiore. Una gran parte degli altri neuroni si trova nel cervelletto (blu). Attestazione:Forschungszentrum Jülich

Un gruppo internazionale di ricercatori ha compiuto un passo decisivo verso la creazione della tecnologia per realizzare simulazioni di reti su scala cerebrale sui futuri supercomputer della classe exascale. La svolta, pubblicato in Le frontiere della neuroinformatica , permette di rappresentare parti più grandi del cervello umano, utilizzando la stessa quantità di memoria del computer. Contemporaneamente, il nuovo algoritmo accelera notevolmente le simulazioni cerebrali sui supercomputer esistenti.

Il cervello umano è un organo di incredibile complessità, composto da 100 miliardi di cellule nervose interconnesse. Però, anche con l'aiuto dei più potenti supercomputer disponibili, è attualmente impossibile simulare lo scambio di segnali neuronali in reti di queste dimensioni.

"Dal 2014 il nostro software può simulare circa l'uno per cento dei neuroni del cervello umano con tutte le loro connessioni, "dice Markus Diesmann, Direttore dell'Istituto Jülich di Neuroscienze e Medicina (INM-6). Al fine di realizzare questa impresa impressionante, il software richiede l'intera memoria principale dei supercomputer a petascala, come il computer K a Kobe e JUQUEEN a Jülich.

Diesmann lavora da più di 20 anni sul software di simulazione NEST, un software di simulazione gratuito, codice di simulazione open source ampiamente utilizzato dalla comunità neuroscientifica e un simulatore di base dell'European Human Brain Project, in cui conduce progetti nelle aree delle neuroscienze teoriche e sulla piattaforma di calcolo e analisi ad alte prestazioni.

Con NIDO, il comportamento di ogni neurone della rete è rappresentato da una manciata di equazioni matematiche. I futuri computer exascale, come il computer post-K progettato a Kobe e JUWELS a Jülich, supererà le prestazioni dei supercomputer di fascia alta di oggi da 10 a 100 volte. Per la prima volta, i ricercatori avranno a disposizione la potenza del computer per simulare reti neuronali sulla scala del cervello umano.

Apparentemente un vicolo cieco

Mentre l'attuale tecnologia di simulazione ha permesso ai ricercatori di iniziare a studiare grandi reti neuronali, rappresentava anche un vicolo cieco sulla via dell'esascala della tecnologia. I supercomputer sono composti da circa 100, 000 piccoli computer, chiamati nodi, ciascuno dotato di un numero di processori che eseguono i calcoli effettivi.

"Prima che possa aver luogo una simulazione di rete neuronale, i neuroni e le loro connessioni devono essere creati virtualmente, il che significa che devono essere istanziati nella memoria dei nodi. Durante la simulazione un neurone non sa su quale dei nodi ha i neuroni bersaglio, perciò, i suoi brevi impulsi elettrici devono essere inviati a tutti i nodi. Ogni nodo controlla quindi quale di tutti questi impulsi elettrici è rilevante per i neuroni virtuali che esistono su questo nodo, " spiega Susanne Kunkel del KTH Royal Institute of Technology di Stoccolma.

L'attuale algoritmo per la creazione della rete è efficiente perché tutti i nodi costruiscono contemporaneamente la loro parte particolare della rete. Tuttavia, l'invio di tutti gli impulsi elettrici a tutti i nodi non è adatto per le simulazioni su sistemi a esascala.

"Controllare in modo efficiente la pertinenza di ogni impulso elettrico richiede un bit di informazione per processore per ogni neurone dell'intera rete. Per una rete di 1 miliardo di neuroni, gran parte della memoria in ogni nodo è consumata proprio da questo singolo Bit di informazione per neurone, " aggiunge Markus Diesmann.

Questo è il problema principale quando si simulano reti ancora più grandi:la quantità di memoria del computer richiesta per processore per i Bit extra per neurone aumenta con la dimensione della rete neuronale. Alla scala del cervello umano, ciò richiederebbe che la memoria disponibile per ciascun processore sia 100 volte più grande rispetto ai supercomputer di oggi. Questo, però, è improbabile che accada nella prossima generazione di supercomputer. Il numero di processori per nodo di calcolo aumenterà, ma la memoria per processore e il numero di nodi di calcolo rimarranno invariati.

Innovazione con un nuovo algoritmo

La svolta pubblicata su Le frontiere della neuroinformatica è un nuovo modo di costruire la rete neuronale nel supercomputer. A causa degli algoritmi, la memoria richiesta su ogni nodo non aumenta più con la dimensione della rete. All'inizio della simulazione, la nuova tecnologia consente ai nodi di scambiare informazioni su chi deve inviare i dati sull'attività neuronale a chi. Una volta che questa conoscenza è disponibile, lo scambio di dati sull'attività neuronale tra i nodi può essere organizzato in modo tale che un nodo riceva solo le informazioni di cui ha bisogno. Non è più necessario un Bit aggiuntivo per ogni neurone della rete.

Un benefico effetto collaterale

Mentre testavano le loro nuove idee, gli scienziati hanno fatto un'ulteriore intuizione chiave, riporta Susanne Kunkel:"Durante l'analisi dei nuovi algoritmi ci siamo resi conto che la nostra nuova tecnologia non solo avrebbe consentito simulazioni su sistemi esascala, ma renderebbe anche le simulazioni più veloci sui supercomputer attualmente disponibili".

Infatti, poiché il consumo di memoria è ora sotto controllo, la velocità delle simulazioni diventa il fulcro di ulteriori sviluppi tecnologici. Per esempio, una grande simulazione di 0,52 miliardi di neuroni collegati da 5,8 trilioni di sinapsi in esecuzione sul supercomputer JUQUEEN a Jülich in precedenza richiedeva 28,5 minuti per calcolare un secondo di tempo biologico. Con la simulazione delle strutture dati migliorata, il tempo è ridotto a 5,2 minuti.

"Con la nuova tecnologia possiamo sfruttare l'accresciuto parallelismo dei moderni microprocessori molto meglio di prima, che diventerà ancora più importante nei computer exascale, " commenta Jakob Jordan, autore principale dello studio, dal Forschungszentrum Jülich.

"La combinazione di hardware exascale e software appropriato porta a indagini su aspetti fondamentali della funzione cerebrale, come la plasticità e l'apprendimento che si dispiegano in minuti di tempo biologico alla nostra portata, " aggiunge Markus Diesmann.

Con una delle prossime versioni del software di simulazione NEST, i ricercatori renderanno il loro risultato disponibile gratuitamente alla comunità come open source.

"Abbiamo utilizzato NEST per simulare le complesse dinamiche dei circuiti dei gangli della base nella salute e nel morbo di Parkinson sul computer K. Siamo entusiasti di apprendere le notizie sulla nuova generazione di NEST, che ci consentirà di eseguire simulazioni su tutta la scala del cervello sul computer post-K per chiarire i meccanismi neurali del controllo motorio e delle funzioni mentali, " afferma Kenji Doya dell'Okinawa Institute of Science and Technology (OIST).

"Lo studio è un meraviglioso esempio della collaborazione internazionale nel tentativo di costruire computer esascala. È importante che abbiamo applicazioni pronte in grado di utilizzare queste preziose macchine dal primo giorno in cui sono disponibili, " conclude Mitsuhisa Sato del RIKEN Advanced Institute for Computer Science di Kobe.