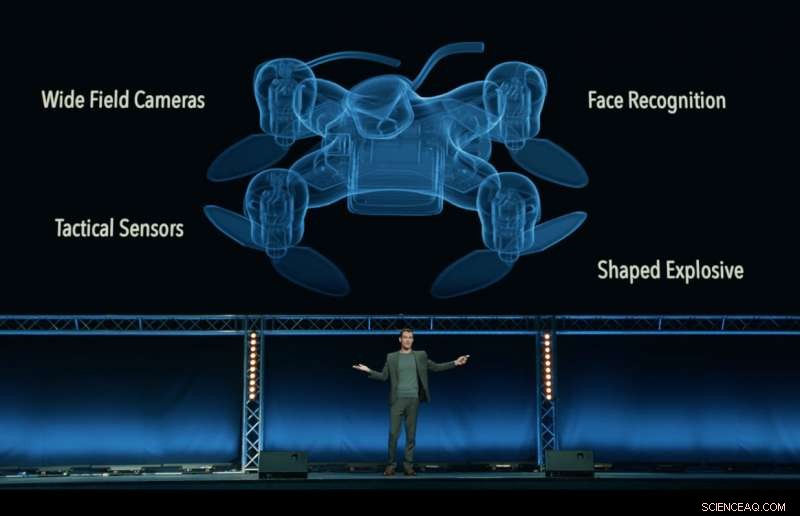

Sempre dal video di "Slaughterbots", prodotto dal Future of Life Institute, che mostra un immaginario futuro distopico di droni killer che sciamano nel mondo. Credito:Future of Life Institute

Un who's who degli amministratori delegati, ingegneri e scienziati del settore tecnologico, tra cui Google DeepMind, la Fondazione XPRIZE ed Elon Musk, hanno firmato un impegno a "né partecipare né sostenere lo sviluppo, produzione, commercio, o l'uso di armi letali autonome".

Pubblicato a Stoccolma in occasione della Conferenza internazionale congiunta sull'intelligenza artificiale (IJCAI) del 2018 il principale incontro mondiale sulla ricerca sull'IA con oltre 5, 000 partecipanti, il pegno è stato sottoscritto da 150 aziende e più di 2, 400 persone provenienti da 90 paesi che lavorano nel campo dell'intelligenza artificiale (AI) e della robotica.

I firmatari aziendali includono Google DeepMind, University College London, la Fondazione XPRIZE, Robotica ClearPath/Motori OTTO, l'Associazione Europea per l'IA, e la Società svedese per l'intelligenza artificiale. Gli individui includono il capo della ricerca presso Google.ai Jeff Dean, I pionieri dell'intelligenza artificiale Stuart Russell, Yoshua Bengio, Anca Dragan e Toby Walsh, e il deputato laburista britannico Alex Sobel.

Il pegno, organizzato dal Future of Life Institute, sfida i governi, il mondo accademico e l'industria a seguire il loro esempio, dicendo:"Noi, il sottoscritto, invitare i governi e i leader di governo a creare un futuro con forti norme internazionali, regolamenti e leggi contro le armi letali autonome. ... Chiediamo che le aziende e le organizzazioni tecnologiche, così come i leader, politici, e altri individui, unisciti a noi in questo impegno".

Max Tegmark, professore di fisica al Massachusetts Institute of Technology e presidente del Future of Life Institute, annunciato l'impegno.

"Sono entusiasta di vedere i leader dell'IA passare dalla conversazione all'azione, attuare una politica che i politici finora non sono riusciti a mettere in atto, " Tegmark ha detto. "L'intelligenza artificiale ha un enorme potenziale per aiutare il mondo, se stigmatizziamo e preveniamo il suo abuso. Le armi AI che decidono autonomamente di uccidere le persone sono disgustose e destabilizzanti quanto le armi biologiche, e dovrebbe essere trattato allo stesso modo».

I sistemi di armi autonome letali (LEGGI) - soprannominati anche "robot killer" - sono armi in grado di identificare, obbiettivo, e uccidere una persona, senza un 'in-the-loop' umano. Questo è, nessuno prende la decisione finale di autorizzare la forza letale:la decisione e l'autorizzazione sulla morte o meno di qualcuno è lasciata al sistema d'arma autonomo. Questo non include i droni di oggi, che sono sotto il controllo umano; né sistemi autonomi che si limitano a difendersi da altre armi.

L'impegno inizia con la dichiarazione:"L'intelligenza artificiale è pronta a svolgere un ruolo crescente nei sistemi militari. C'è un'urgente opportunità e necessità per i cittadini, politici, e leader per distinguere tra usi accettabili e inaccettabili dell'IA".

Un altro organizzatore chiave dell'impegno, Toby Walsh, un professore di intelligenza artificiale presso l'Università australiana del New South Wales a Sydney, sottolinea le spinose questioni etiche che circondano LEGGI:"Non possiamo affidare la decisione su chi vive e chi muore alle macchine. Non hanno l'etica per farlo. Incoraggio voi e le vostre organizzazioni a impegnarvi a garantire che la guerra non diventare più terribile in questo modo."

Ryan Gariepy, Fondatore e CTO di Clearpath Robotics e OTTO Motors, un forte oppositore delle armi letali autonome, ha fatto eco all'appello:"Clearpath continua a credere che la proliferazione di sistemi d'arma autonomi letali rimanga un pericolo chiaro e presente per i cittadini di ogni paese del mondo. Nessuna nazione sarà al sicuro, non importa quanto potente.

"Le preoccupazioni di Clearpath sono condivise da un'ampia varietà di altre importanti aziende e sviluppatori di sistemi autonomi, e speriamo che i governi di tutto il mondo decidano di investire il loro tempo e i loro sforzi in sistemi autonomi che rendano le loro popolazioni più sane, più sicuro, e più produttivi rispetto ai sistemi il cui unico uso è il dispiegamento della forza letale, " Ha aggiunto.

Toby Walsh, professore di intelligenza artificiale presso l'Università australiana del New South Wales a Sydney, con un robot Baxter. Credito:Grant Turner/UNSW

Oltre alle preoccupanti questioni etiche che circondano le armi letali autonome, molti sostenitori di un divieto internazionale di LEGGI sono preoccupati che saranno difficili da controllare, più facili da hackerare, più probabilità di finire sul mercato nero, e più facile da ottenere per terroristi e despoti, il che potrebbe diventare destabilizzante per tutti i paesi. Questo scenario viene riprodotto nel video pubblicato da FLI Slaughterbots.

A dicembre 2016, la Conferenza di revisione delle Nazioni Unite sulla Convenzione sulle armi convenzionali (CCW) ha avviato una discussione formale sulle leggi. 26 paesi che partecipano alla conferenza hanno finora annunciato il sostegno a un qualche tipo di divieto, compresa la Cina.

Tale divieto non è senza precedenti:sono state vietate anche le armi biologiche e chimiche, non solo per ragioni etiche e umanitarie, ma anche per la minaccia destabilizzante che rappresentavano.

La prossima riunione delle Nazioni Unite su LEGGI si terrà nell'agosto 2018, e i firmatari dell'impegno sperano che il loro impegno incoraggerà i legislatori a sviluppare un impegno per un accordo internazionale tra i paesi.

Come afferma il pegno:"Noi, il sottoscritto, invitare i governi e i leader di governo a creare un futuro con forti norme internazionali, regolamenti e leggi contro le armi letali autonome. ... Chiediamo che le aziende e le organizzazioni tecnologiche, così come i leader, politici, e altri individui, unisciti a noi in questo impegno".

Il testo integrale dell'impegno

L'intelligenza artificiale (AI) è destinata a svolgere un ruolo crescente nei sistemi militari. C'è un'urgente opportunità e necessità per i cittadini, politici, e leader per distinguere tra usi accettabili e inaccettabili dell'IA.

In questa luce, noi sottoscritti concordiamo che la decisione di togliere una vita umana non dovrebbe mai essere delegata a una macchina. C'è una componente morale in questa posizione, che non dovremmo permettere alle macchine di prendere decisioni vitali per le quali altri, o nessuno, saranno colpevoli.

C'è anche un potente argomento pragmatico:armi letali autonome, selezionare e coinvolgere obiettivi senza intervento umano, sarebbe pericolosamente destabilizzante per ogni paese e individuo. Migliaia di ricercatori di intelligenza artificiale concordano sul fatto che rimuovendo il rischio, attribuibilità, e la difficoltà di togliere vite umane, armi letali autonome potrebbero diventare potenti strumenti di violenza e oppressione, soprattutto se collegato a sistemi di sorveglianza e dati.

Inoltre, le armi autonome letali hanno caratteristiche del tutto diverse dal nucleare, armi chimiche e biologiche, e le azioni unilaterali di un singolo gruppo potrebbero troppo facilmente innescare una corsa agli armamenti che la comunità internazionale non ha gli strumenti tecnici e i sistemi di governance globale per gestire. Stigmatizzare e prevenire tale corsa agli armamenti dovrebbe essere una priorità assoluta per la sicurezza nazionale e globale.

Noi, il sottoscritto, invitare i governi e i leader di governo a creare un futuro con forti norme internazionali, regolamenti e leggi contro le armi letali autonome. Questi attualmente assenti, scegliamo di mantenere uno standard elevato:non parteciperemo né sosterremo lo sviluppo, produzione, commercio, o l'uso di armi letali autonome. Chiediamo che le aziende e le organizzazioni tecnologiche, così come i leader, politici, e altri individui, unisciti a noi in questo impegno.