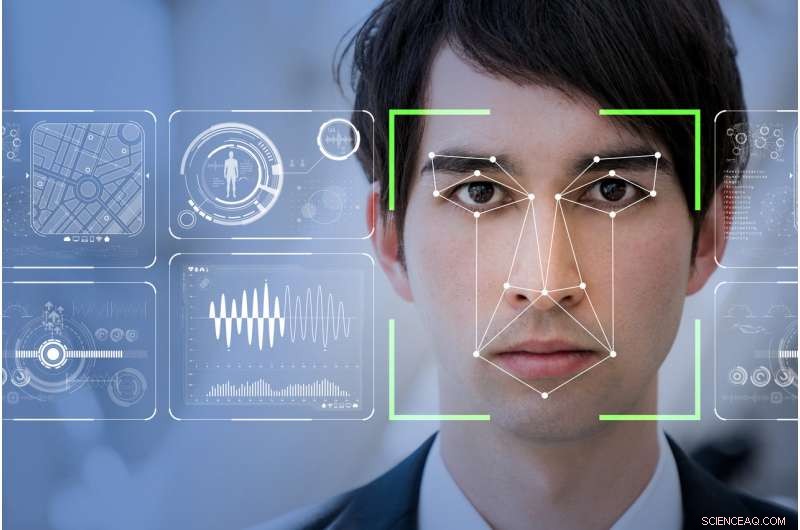

Il software di riconoscimento facciale renderà il mondo un posto più sicuro, come affermano le aziende tecnologiche, o renderà gli emarginati più vulnerabili e monitorati? Credito:Shutterstock

Mia madre diceva sempre che avevo un volto per la radio. Grazie Dio, poiché la radio potrebbe essere l'ultimo posto in questo mondo potenziato dalla tecnologia in cui la tua faccia non determinerà il tuo stato sociale o il potenziale per commettere un crimine.

RealNetwork, il leader globale di una tecnologia che consente la distribuzione digitale senza interruzioni di file audio e video su Internet, ha appena rilasciato la sua ultima visione artificiale:un pacchetto software per l'apprendimento automatico. La speranza è che questo nuovo software rilevi, e potenzialmente prevedere, comportamento sospetto attraverso il riconoscimento facciale.

Chiamato SAFR (sicuro, Riconoscimento facciale accurato), il set di strumenti è stato commercializzato come un modo conveniente per integrarsi senza problemi nei sistemi di monitoraggio video CCTV esistenti. Sarà in grado di "rilevare e abbinare milioni di volti in tempo reale, "in particolare all'interno degli ambienti scolastici.

Apparentemente, RealNetworks vede la sua tecnologia come qualcosa che può rendere il mondo più sicuro. Il marchio accattivante, però, maschera i veri problemi etici che circondano l'implementazione di sistemi di rilevamento facciale. Alcuni di questi problemi includono domande sui pregiudizi intrinseci incorporati nel codice e, in definitiva, come vengono utilizzati i dati acquisiti.

Il modello cinese

Il Grande Fratello sta guardando. Nessun altro paese al mondo ha più videosorveglianza della Cina. Con 170 milioni di telecamere CCTV e circa 400 milioni di nuove installate, è un paese che ha adottato e implementato il riconoscimento facciale in modo orwelliano.

Nel futuro prossimo, i suoi cittadini, e quelli di noi che ci viaggiano, sarà esposto a una vasta e integrata rete di sistemi di riconoscimento facciale che monitorano tutto, dall'uso dei mezzi pubblici, all'accelerazione di quanta carta igienica si usa nel bagno pubblico.

L'elemento più inquietante finora è la recente introduzione del riconoscimento facciale per monitorare il comportamento dei bambini delle scuole all'interno delle scuole pubbliche cinesi.

Come parte della piena integrazione della Cina del loro sistema di credito sociale altrettanto orwelliano, un programma di incentivi che premia l'impegno di ogni cittadino nei confronti della morale dettata dallo stato, questo sistema digitale completamente integrato identificherà automaticamente una persona. Può quindi determinare la capacità di una persona di progredire nella società e, per estensione, lo stato economico e sociale della famiglia immediata di quella persona, monitorando il comportamento non autorizzato dello stato.

In sostanza, il riconoscimento facciale sta rendendo impossibile per le persone esposte il lusso di avere una brutta giornata.

I sistemi di riconoscimento facciale ora in uso nelle scuole cinesi stanno monitorando tutto, dalla frequenza in classe al fatto che un bambino stia sognando ad occhi aperti o prestando attenzione. È un sistema di monitoraggio completo che determina, in larga misura, futuro di un bambino senza considerare che alcune qualità, come il pensiero astratto, non può essere facilmente individuato o, nella migliore delle ipotesi, guardato con favore, con riconoscimento facciale.

Solleva anche alcune nozioni molto scomode di etica o la sua mancanza, specialmente verso i membri più vulnerabili della società.

Necessità di una regolamentazione pubblica

Il lancio di SAFR da parte di RealNetworks segue a ruota l'appassionato manifesto del presidente di Microsoft Brad Smith sulla necessità di una regolamentazione pubblica e della responsabilità aziendale nello sviluppo e nell'implementazione della tecnologia di riconoscimento facciale.

Smith ha giustamente sottolineato che gli strumenti di riconoscimento facciale sono ancora in qualche modo distorti e hanno "tassi di errore maggiori per le donne e le persone di colore". Questo problema è duplice, con il riconoscimento che le persone che codificano possono incorporare inconsciamente pregiudizi culturali.

I set di dati attualmente disponibili potrebbero non avere la solidità oggettiva necessaria per garantire che i volti delle persone non vengano identificati erroneamente, o peggio ancora predeterminato attraverso pregiudizi codificati come sta cominciando ad accadere nel sistema scolastico cinese.

Nel tentativo di affrontare questo e una miriade di altri problemi correlati, Microsoft ha istituito un comitato per l'intelligenza artificiale e l'etica nell'ingegneria e nella ricerca (AETHER). Questo comitato è anche istituito per aiutarli a conformarsi al Regolamento generale sulla protezione dei dati (GDPR) dell'Unione Europea recentemente entrato in vigore e alla sua eventuale futura adozione, in qualche forma, nel Nord America.

L'ardente appello di Smith interroga giustamente l'uso previsto e il dispiegamento attuali e futuri dei sistemi di riconoscimento facciale, ma non riesce ad affrontare come Microsoft o, per estensione, altri leader della tecnologia AI, possono eliminare sin dall'inizio i pregiudizi all'interno del loro codice di base o dei set di dati.

Rapporto di minoranza

I tratti del nostro volto sono poco più che gesti che la forza dell'abitudine ha reso permanenti .-Marcel Proust, 1919

Come molte tecnologie, Pandora ha già lasciato la scatola. Se possiedi uno smartphone e utilizzi Internet, hai già rinunciato a qualsiasi nozione di base di anonimato personale all'interno della società occidentale.

Con il GDPR ora pienamente impegnato in Europa, visitare un sito Web ora richiede di "accettare" la possibilità che quel sito Web possa raccogliere dati personali. I sistemi di riconoscimento facciale non hanno i mezzi per seguire le regole del GDPR, così come tale, noi come società siamo automaticamente "opzionati" e quindi completamente alla mercé di come vengono registrati i nostri volti, elaborati e conservati da enti governativi, sistemi TVCC aziendali o anche dispiegati privatamente.

Le prove di riconoscimento facciale svolte in Inghilterra dalla polizia metropolitana di Londra hanno costantemente prodotto un tasso di fallimento del 98%. Allo stesso modo, nel Galles sudoccidentale, i test sono andati solo leggermente meglio con meno del 10% di successo.

Al contrario, Università della California, Berkeley, gli scienziati hanno concluso che la variazione facciale sostanziale è un tratto evolutivo unico per gli esseri umani. Allora dov'è la disconnessione?

Se come ha suggerito Marcel Proust, le nostre vite e quindi le nostre personalità sono identificabili in modo univoco dai nostri volti, perché i sistemi di riconoscimento facciale non possono restituire facilmente risultati positivi?

La risposta risale al modo in cui viene scritta la programmazione del computer e ai set di dati utilizzati da quel codice per restituire una corrispondenza positiva. Inevitabilmente, il codice è scritto per supportare una nozione idealizzata di tipo facciale.

Come tale, outlying variations like naturally occurring facial deformities or facial features affected by physical or mental trauma represent only a small fraction of the infinite possible facial variations in the world. The data sets assume we are homogeneous doppelgängers of each other, without addressing the micro-variations of peoples faces.

Se è il caso, we are all subject to the possibility that our faces as interpreted by the ever-increasing deployment of immature facial recognition systems will betray the reality of who we are.

Questo articolo è stato originariamente pubblicato su The Conversation. Leggi l'articolo originale.