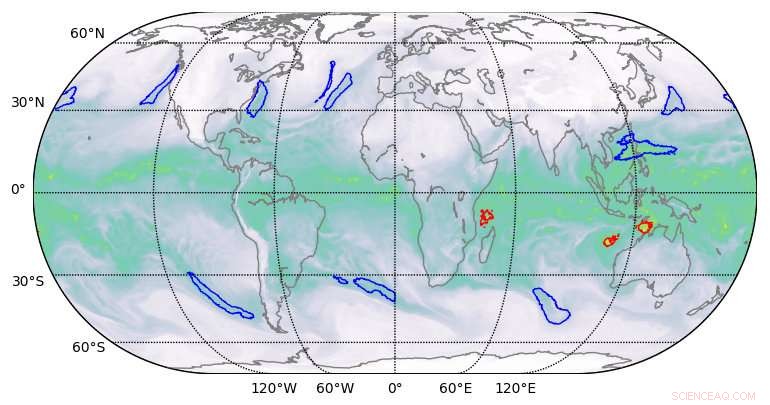

Risultati di segmentazione di alta qualità prodotti dal deep learning sui set di dati climatici. Credito:Berkeley Lab

Un team di scienziati computazionali del Lawrence Berkeley National Laboratory (Berkeley Lab) e dell'Oak Ridge National Laboratory (ORNL) e ingegneri di NVIDIA ha, per la prima volta, ha dimostrato un'applicazione di deep learning di classe exascale che ha infranto la barriera exaop.

Utilizzando un set di dati climatici dal Berkeley Lab sul sistema Summit dell'ORNL presso l'Oak Ridge Leadership Computing Facility (OLCF), hanno addestrato una rete neurale profonda per identificare modelli meteorologici estremi da simulazioni climatiche ad alta risoluzione. Summit è un supercomputer IBM Power Systems AC922 alimentato da più di 9, 000 CPU IBM POWER9 e 27, 000 GPU Tensor Core NVIDIA Tesla V100. Attingendo ai Tensor Core specializzati di NVIDIA integrati nelle GPU su larga scala, i ricercatori hanno raggiunto una performance di picco di 1,13 exaops e una performance sostenuta di 0,999, l'algoritmo di deep learning più veloce riportato fino ad oggi e un risultato che gli è valso un posto nell'elenco dei finalisti di quest'anno per il Gordon Bell Prize.

"Questa collaborazione ha prodotto una serie di risultati unici, " disse Prabhat, che guida il team di Data &Analytics Services presso il National Energy Research Scientific Computing Center del Berkeley Lab ed è coautore della proposta di Gordon Bell. "È il primo esempio di architettura di deep learning che è stata in grado di risolvere i problemi di segmentazione nella scienza del clima, e nel campo dell'apprendimento profondo, è il primo esempio di una vera applicazione che ha infranto la barriera dell'esascala."

Questi risultati sono stati possibili grazie a una combinazione innovativa di funzionalità hardware e software. Per quanto riguarda l'hardware, Summit è stato progettato per fornire 200 petaflop di prestazioni di elaborazione ad alta precisione ed è stato recentemente nominato il computer più veloce del mondo, in grado di eseguire più di tre exaops (3 miliardi di miliardi di calcoli) al secondo. Il sistema presenta un'architettura ibrida; ciascuno dei suoi 4, 608 nodi di calcolo contengono due CPU IBM POWER9 e sei GPU NVIDIA Volta Tensor Core, tutti collegati tramite l'interconnessione ad alta velocità NVIDIA NVLink. Le GPU NVIDIA sono un fattore chiave nelle prestazioni di Summit, consentendo teraflop di picco fino a 12 volte superiori per l'addestramento e teraflop di picco fino a 6 volte superiori per l'inferenza nelle applicazioni di deep learning rispetto al suo predecessore, la Tesla P100.

"La nostra collaborazione con Berkeley Lab e Oak Ridge National Laboratory ha mostrato il vero potenziale delle GPU NVIDIA Tensor Core per applicazioni AI e HPC, " ha detto Michael Houston, illustre ingegnere senior di deep learning presso NVIDIA. "Per rendere Exascale una realtà, il nostro team ha sfruttato le capacità multi-precisione racchiuse nelle migliaia di GPU NVIDIA Volta Tensor Core su Summit per ottenere le massime prestazioni nella formazione e nell'inferenza nelle applicazioni di deep learning".

Scalabilità e comunicazione migliorate

Dal lato software, oltre a fornire il set di dati climatici, il team del Berkeley Lab ha sviluppato algoritmi di riconoscimento dei modelli per addestrare la rete neurale DeepLabv3+ per estrarre classificazioni a livello di pixel di modelli meteorologici estremi, che potrebbe aiutare nella previsione di come gli eventi meteorologici estremi stanno cambiando con il riscaldamento del clima. Secondo Thorsten Kurth, uno specialista delle prestazioni delle applicazioni presso NERSC che ha guidato questo progetto, il team ha apportato modifiche a DeepLabv3+ che hanno migliorato la scalabilità della rete e le capacità di comunicazione e hanno reso possibile il raggiungimento di exaops. Ciò includeva la messa a punto della rete per addestrarla a estrarre le funzionalità a livello di pixel e la classificazione per pixel e migliorare la comunicazione da nodo a nodo.

"La cosa impressionante di questo sforzo è che potremmo scalare un framework ad alta produttività come TensorFlow, che è tecnicamente progettato per la prototipazione rapida su piccola e media scala, a 4, 560 nodi su Summit, " ha detto. "Con una serie di miglioramenti delle prestazioni, siamo stati in grado di far funzionare il framework su quasi l'intero supercomputer e ottenere prestazioni di livello exaop, che per quanto ne so è il miglior risultato ottenuto finora in un'applicazione strettamente accoppiata."

Altre innovazioni includevano lo staging dei dati in parallelo ad alta velocità, una pipeline di acquisizione dati ottimizzata e segmentazione multicanale. Le attività di segmentazione delle immagini tradizionali funzionano su immagini rosso/blu/verde a tre canali. Ma i set di dati scientifici spesso comprendono molti canali; nel clima, Per esempio, questi possono includere la temperatura, velocità del vento, valori di pressione e umidità. Eseguendo la rete neurale ottimizzata su Summit, le capacità computazionali aggiuntive hanno permesso l'uso di tutti i 16 canali disponibili, che ha notevolmente migliorato la precisione dei modelli.

"Abbiamo dimostrato che possiamo applicare metodi di deep learning per la segmentazione a livello di pixel sui dati climatici, e potenzialmente su altri domini scientifici, " disse Prabhat. "Più in generale, il nostro progetto ha gettato le basi per l'exascale deep learning per la scienza, così come le applicazioni commerciali."