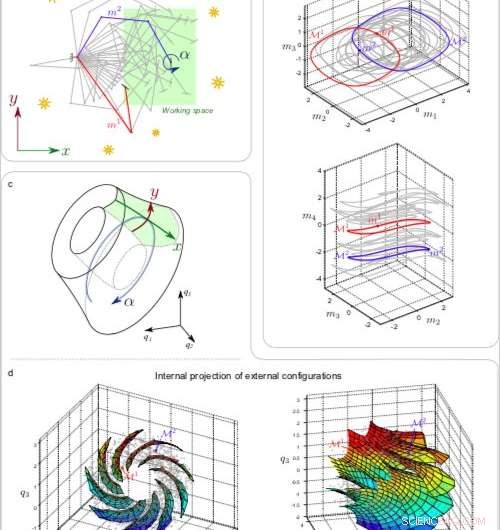

a) 1% delle 2500 configurazioni del braccio esplorativo mi . b) Due proiezioni 3D dell'1% dei set Mi incorporati nello spazio motorio 4D. c) Schema del collettore proiettato e cattura dei parametri esterni. d) Proiezione in 3D delle 2500 varietà Mi (punti grigi) con superfici corrispondenti a traslazioni nello spazio di lavoro per diversi orientamenti retinici. Credito:Laflaquière et al.

I ricercatori della Sorbonne Universités e del CNRS hanno recentemente studiato i prerequisiti per l'emergere di nozioni spaziali semplificate nei sistemi robotici, basato sul flusso sensomotorio di un robot. Il loro studio, pre-pubblicato su arXiv, fa parte di un progetto più ampio, in cui hanno esplorato come le nozioni percettive fondamentali (ad esempio corpo, spazio, oggetto, colore, ecc.) potrebbero essere instillate in sistemi biologici o artificiali.

Finora, i progetti dei sistemi robotici hanno rispecchiato principalmente il modo in cui gli esseri umani percepiscono il mondo. Progettare robot guidati esclusivamente dall'intuizione umana, però, potrebbero limitare le loro percezioni a quelle vissute dagli esseri umani.

Per progettare robot completamente autonomi, i ricercatori potrebbero quindi aver bisogno di allontanarsi dai costrutti legati all'uomo, permettendo agli agenti robotici di sviluppare il proprio modo di percepire il mondo. Secondo il team di ricercatori della Sorbonne Universités e del CNRS, un robot dovrebbe sviluppare gradualmente le proprie nozioni percettive esclusivamente analizzando le sue esperienze sensomotorie e identificando modelli significativi.

"L'ipotesi generale è che nessuno dia nozioni percettive agli organismi biologici, "Alessandro Terechov, uno dei ricercatori che ha condotto lo studio, ha detto a TechXplore. "Questi concetti si sviluppano invece nel tempo, come strumenti utili che li aiutano a dare un senso ai vasti dati sensomotori a cui sono costantemente esposti. Come conseguenza, la nozione di spazio di una rana molto probabilmente differirà da quella di un pipistrello, che a sua volta sarà diverso da quello degli umani. Quindi, quando si costruisce un robot, quale nozione di spazio dovremmo dargli? Probabilmente nessuno di questi. Se vogliamo che i robot siano veramente intelligenti, non dovremmo costruirli usando nozioni astratte, ma invece, fornire loro algoritmi che consentiranno loro di sviluppare tali nozioni da soli".

Terekhov e i suoi colleghi hanno dimostrato che la nozione di spazio come indipendente dall'ambiente non può essere dedotta solo da informazioni esterocettive, poiché queste informazioni variano molto a seconda di ciò che si trova nell'ambiente. Questa nozione potrebbe essere meglio definita esaminando le funzioni che collegano i comandi motori ai cambiamenti negli stimoli esterni all'agente.

"Un'importante intuizione è venuta da un vecchio studio del famoso matematico francese Henri Poincaré, che era interessato a come la matematica in generale e la geometria in particolare potessero emergere dalla percezione umana, " Ha detto Terekhov. "Ha suggerito che la coincidenza nell'input sensoriale può svolgere un ruolo cruciale".

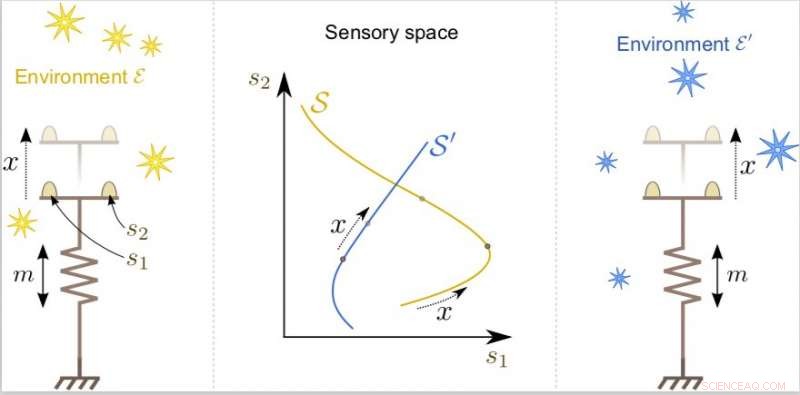

L'agente può muovere i suoi sensori nello spazio esterno usando il suo motore. Sebbene la configurazione dell'agente esterno x possa essere la stessa, la sua esperienza sensoriale varia molto a seconda della struttura dell'ambiente. Credito:Laflaquière et al.

Le idee introdotte da Poincaré possono essere meglio spiegate con un semplice esempio. Quando osserviamo un dato oggetto, gli occhi catturano un'immagine particolare, che cambierà se l'oggetto si sposta di 10 cm a sinistra. Però, se ci spostiamo di 10 cm a sinistra, l'immagine che vediamo rimarrà quasi esattamente la stessa.

"Questa proprietà sembra miracolosa se si pensa a quanti recettori ha il corpo umano, " Disse Terekhov. "È quasi impossibile avere lo stesso input due volte nella vita, eppure lo sperimentiamo costantemente. Questi eventi a bassa probabilità possono essere usati dal cervello per costruire nozioni percettive generali".

Per applicare queste idee alla progettazione di sistemi robotici, i ricercatori hanno programmato un braccio robotico virtuale con una telecamera sulla punta. Il robot annotava le misurazioni provenienti dalle articolazioni del braccio ogni volta che riceveva lo stesso input visivo. "Associando tutte queste misure, il robot costruisce un'astrazione matematicamente equivalente alla posizione e all'orientamento della sua telecamera, anche se non ha accesso esplicito a queste informazioni, " Ha detto Terekhov. "La cosa più importante è che anche se questa nozione astratta viene appresa in base all'input visivo, finisce per esserne indipendente, e quindi funziona per tutti gli ambienti; allo stesso modo la nostra nozione di spazio non dipende dalla scena particolare che vediamo."

Applicando lo stesso principio in un altro studio, i ricercatori hanno spinto con successo un robot a compensare una distorsione ottica causata da un obiettivo posizionato davanti alla sua fotocamera. Tipicamente, questo sarebbe ottenuto addestrando algoritmi su coppie di immagini distorte e non distorte.

"La parte difficile del nostro studio è stata che il robot doveva completare questo compito guardando solo le immagini distorte, proprio come gli umani imparano a compensare la distorsione introdotta dagli occhiali, " Disse Terekhov. "Crediamo che i principi introdotti da Poincaré, che sono alla base dei nostri algoritmi, potrebbero essere più generali e sono utilizzati dal cervello a più livelli. Attualmente stiamo esplorando la possibilità di utilizzare questi principi per costruire reti neurali che non soffrano di dimenticanze catastrofiche e possano accumulare gradualmente conoscenza".

© 2018 Tech Xplore