Crediti:Tautkutè &Trzcinski

I ricercatori dell'Accademia di tecnologia dell'informazione polacco-giapponese e dell'Università di tecnologia di Varsavia hanno sviluppato un modello di rete di allineamento profondo (DAN) per classificare e visualizzare le emozioni. È stato scoperto che il loro metodo supera i metodi di classificazione delle emozioni all'avanguardia su due set di dati di riferimento.

Lo sviluppo di modelli in grado di riconoscere e classificare le emozioni umane è una sfida chiave nel campo dell'apprendimento automatico e della visione artificiale. La maggior parte degli strumenti di riconoscimento delle emozioni esistenti utilizza reti convoluzionali multistrato, che non inferiscano esplicitamente i tratti somatici in fase di classificazione.

Ivona Tautkute e Tomasz Trzcinski, i ricercatori che hanno condotto il recente studio, inizialmente stavano lavorando a un sistema per una startup con sede in California che potesse essere integrato in auto autonome. Questo sistema era in grado di contare i passeggeri in base ai dati estratti da una singola videocamera montata all'interno dell'auto.

In una fase successiva, i due ricercatori hanno iniziato a esplorare modelli che potrebbero fare di più, creare statistiche più ampie sui passeggeri stimandone l'età e il sesso. Un'ovvia estensione di questo sistema consisteva nel rilevare le espressioni facciali e le emozioni, anche.

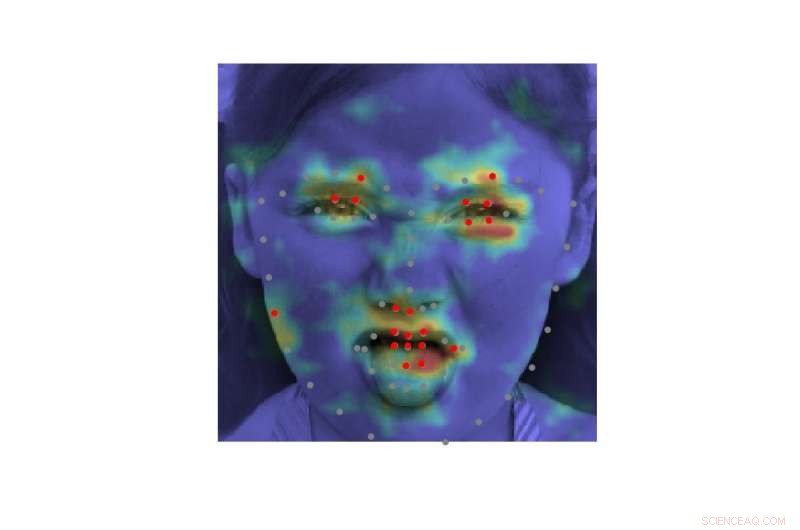

"Dato che il sistema doveva essere utilizzato con passeggeri anziani, era importante catturare le emozioni negative e positive associate al disimpegno del conducente, " ha spiegato Tautkute. "Gli approcci esistenti per il riconoscimento delle emozioni sono tutt'altro che perfetti, quindi abbiamo iniziato a cercare nuovi modi interessanti per migliorare. Un'idea ci è venuta dopo una discussione con un collega ricercatore di computer vision, Marek Kowalski, che stava lavorando sull'allineamento facciale con la rete di allineamento profondo (DAN). La posizione dei punti di riferimento facciali è direttamente correlata all'emozione espressa, quindi eravamo curiosi di sapere se potevamo costruire un sistema che combinasse questi due compiti".

EmotivoDAN, il modello ideato da Tautkute e Trzcinski, è un adattamento del modello DAN di Kowalski, che include un termine relativo alle caratteristiche del viso. Grazie a questa modifica, il loro modello apprende simultaneamente la posizione di entrambi i punti di riferimento facciali e le emozioni espresse.

Crediti:Tautkutè &Trzcinski

Crediti:Tautkutè &Trzcinski

Crediti:Tautkutè &Trzcinski

Crediti:Tautkutè &Trzcinski

"Abbiamo raggiunto questo obiettivo estendendo la funzione di perdita del DAN originale con un termine responsabile della classificazione delle emozioni, " Tautkute ha detto. "La rete neurale è addestrata in fasi consecutive che consentono il perfezionamento dei punti di riferimento facciali e delle emozioni apprese. C'è anche un trasferimento di informazioni tra le fasi, che tiene traccia dell'input del volto normalizzato, mappa delle caratteristiche e mappa termica dei punti di riferimento."

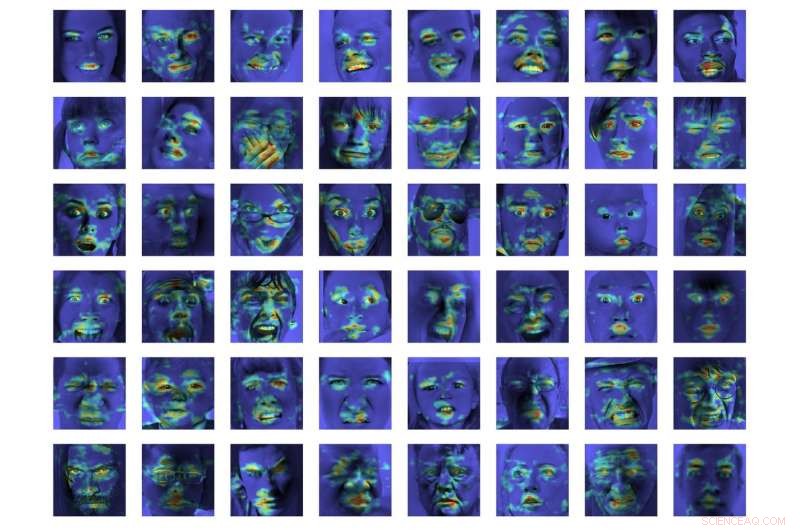

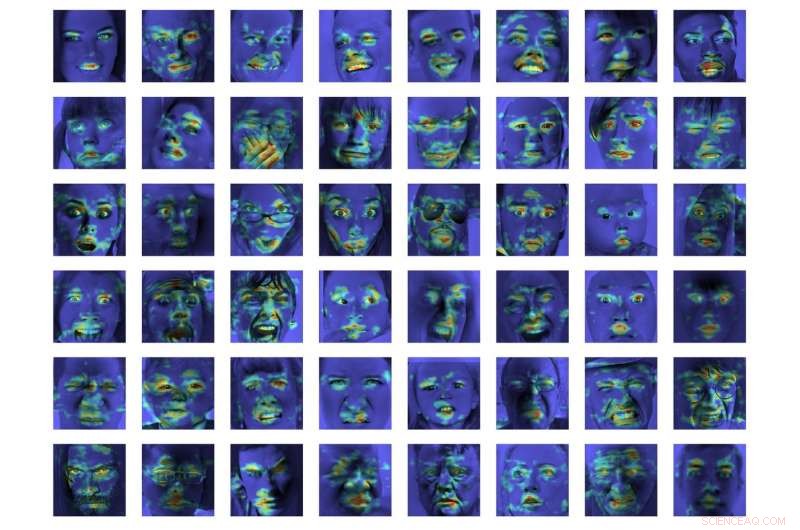

In una prima valutazione, EmotionalDAN ha superato i metodi di classificazione all'avanguardia del 5% su due set di dati di riferimento, vale a dire CK+ e ISED. I ricercatori sono stati anche in grado di visualizzare le regioni dell'immagine analizzate dal loro modello al momento di prendere una decisione. Le loro osservazioni hanno rivelato che EmotionalDAN potrebbe identificare correttamente i punti di riferimento facciali associati all'espressione delle emozioni negli esseri umani.

"Ciò che è veramente interessante del nostro studio è che anche se non forniamo alla rete alcuna informazione spaziale correlata alle emozioni, il modello è in grado di apprendere da solo quali regioni del viso dovrebbero essere osservate quando si cerca di capire le espressioni facciali, " disse Tautkute. "Noi umani guardiamo intuitivamente gli occhi e la bocca di una persona per notare sorrisi o tristezza, ma la rete neurale vede solo una matrice di pixel. Verificare quali regioni dell'immagine sono attivate per una determinata decisione di classificazione ci avvicina di un passo alla comprensione del modello e del modo in cui prende le decisioni".

Crediti:Tautkutè &Trzcinski.

Nonostante i risultati molto promettenti ottenuti da EmotionalDAN e da altri strumenti di riconoscimento delle emozioni, comprendere le emozioni umane rimane un compito molto complesso. Mentre i sistemi esistenti hanno ottenuto risultati notevoli, sono stati principalmente in grado di farlo quando le emozioni sono espresse in misura significativa.

In situazioni di vita reale, però, i segnali emotivi espressi dagli umani sono spesso molto più sottili. Ad esempio, la felicità di una persona potrebbe non essere sempre trasmessa mostrando tutti i denti in un ampio sorriso, ma potrebbe semplicemente comportare un leggero movimento degli angoli delle labbra.

"Sarebbe davvero interessante capire aspetti più soggettivi delle emozioni e come la loro espressione differisca tra gli individui, " Tautkute ha detto. "Per andare oltre, si potrebbe provare a distinguere le emozioni false da quelle genuine. Per esempio, i neurologi affermano che diversi muscoli facciali sono coinvolti in sorrisi veri e falsi. In particolare, i muscoli oculari non si contraggono nell'espressione forzata. Sarebbe interessante scoprire relazioni simili utilizzando le informazioni apprese dai dati".

© 2018 Science X Network