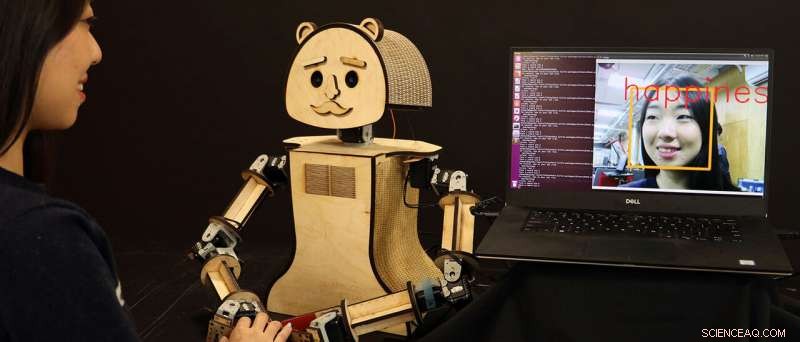

"Legnoso, " un robot sociale a basso costo, è leggere le emozioni sul volto dell'essere umano, basato sugli algoritmi sviluppati dalla ricercatrice Kiju Lee e dal suo team presso la Case Western Reserve University. Credito:Case Western Reserve University

I robot stanno diventando più intelligenti e più veloci nel sapere cosa provano e pensano gli umani semplicemente "guardandoli" in faccia, uno sviluppo che un giorno potrebbe consentire a macchine più emotivamente percettive di rilevare i cambiamenti nella salute o nello stato mentale di una persona.

I ricercatori della Case Western Reserve University affermano che stanno migliorando l'intelligenza artificiale (AI) che ora alimenta i videogiochi interattivi e che presto migliorerà la prossima generazione di robot personalizzati che probabilmente coesisteranno insieme agli umani.

E i robot di Case Western Reserve lo stanno facendo in tempo reale.

Nuove macchine sviluppate da Kiju Lee, il Nord Distinguished Assistant Professor in ingegneria meccanica e aerospaziale presso la Case School of Engineering, e lo studente laureato Xiao Liu, identificano correttamente le emozioni umane dalle espressioni facciali il 98 percento delle volte, quasi istantaneamente. I risultati precedenti di altri ricercatori avevano ottenuto risultati simili, ma i robot spesso rispondevano troppo lentamente.

"Anche una pausa di tre secondi può essere imbarazzante, "Ha detto Lee. "È già abbastanza difficile per gli umani, e ancora più difficile per i robot, capire cosa prova qualcuno basandosi esclusivamente sulle espressioni facciali o sul linguaggio del corpo. "Tutti i livelli e tutti i livelli di tecnologia, inclusa l'acquisizione video, per fare questo purtroppo rallentano anche la risposta".

Lee e Liu hanno accelerato il tempo di risposta combinando due filtri video di pre-elaborazione a un'altra coppia di programmi esistenti per aiutare il robot a classificare le emozioni in base a più di 3, 500 variazioni nell'espressione facciale umana.

Ma questa non è certo l'estensione della nostra variazione facciale:gli umani possono registrarne più di 10, 000 espressioni, e ognuno ha anche un modo unico di rivelare molte di quelle emozioni, ha detto Lee.

Ma i computer "deep learning" possono elaborare grandi quantità di informazioni una volta che tali dati sono stati inseriti nel software e classificati.

E, per fortuna, le caratteristiche espressive più comuni tra gli umani si dividono facilmente in sette emozioni:neutra, felicità, rabbia, tristezza, disgusto, sorpresa e paura, anche tenendo conto delle variazioni tra i diversi background e culture.

Applicazioni ora e futuro

Questo recente lavoro di Lee e Liu, svelato agli IEEE Games 2018, Divertimento, e conferenza stampa, potrebbe portare a una serie di applicazioni se combinato con i progressi di dozzine di altri ricercatori nel campo dell'IA, ha detto Lee.

I due stanno anche lavorando su un altro approccio basato sull'apprendimento automatico per il riconoscimento delle emozioni facciali, che finora ha raggiunto oltre il 99% di precisione con un'efficienza computazionale ancora maggiore.

un giorno, un robot personale può essere in grado di notare con precisione cambiamenti significativi in una persona attraverso l'interazione quotidiana, fino al punto di rilevare i primi segni di depressione, Per esempio.

"Il robot potrebbe essere programmato per catturarlo presto e aiutare con semplici interventi, come musica e video, per le persone che necessitano di terapie sociali, "Ha detto Lee. "Questo potrebbe essere molto utile per gli anziani che potrebbero soffrire di depressione o cambiamenti di personalità associati all'invecchiamento".

Lee sta pianificando di esplorare il potenziale uso dei robot sociali per l'intervento sociale ed emotivo negli anziani attraverso la collaborazione con l'Ohio Living Breckenridge Village. Ci si aspetta che i residenti anziani interagiscano con un ambiente user-friendly, robot socialmente interattivo e aiuta a testare l'accuratezza e l'affidabilità degli algoritmi incorporati.

Un'altra possibilità futura:un robot sociale che apprende i cambiamenti facciali più sottili in qualcuno nello spettro autistico e che aiuta a "insegnare" agli umani a riconoscere accuratamente le emozioni l'uno nell'altro.

"Ci vorrà del tempo per catturare questi robot sociali negli Stati Uniti, " ha detto Lee. "Ma in posti come il Giappone, dove c'è una forte cultura intorno ai robot, questo sta già cominciando ad accadere. In ogni caso, il nostro futuro sarà fianco a fianco con robot emotivamente intelligenti".