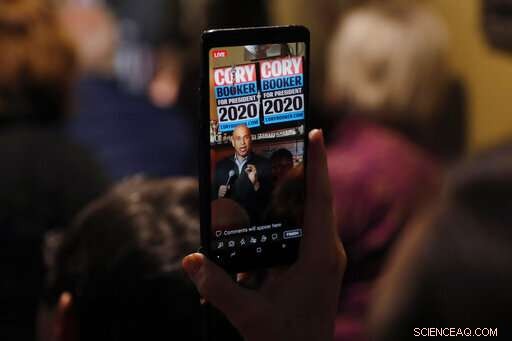

In questo 9 febbraio, 2019, foto d'archivio, Sen. Cory Booker, D-NJ, è visto su un telefono cellulare mentre parla durante un incontro con i residenti locali a Marshalltown, Iowa. Il Congresso sta iniziando a mostrare interesse nell'aprire la "scatola nera" dell'intelligenza artificiale delle aziende tecnologiche più o meno allo stesso modo in cui il governo federale controlla sotto i cofani delle auto e controlla le banche. Una proposta presentata mercoledì, 19 aprile e co-sponsorizzato da Booker, richiederebbe alle grandi aziende di testare la "responsabilità algoritmica" dei loro sistemi di intelligenza artificiale ad alto rischio, come la tecnologia che rileva i volti o prende decisioni importanti in base ai dati personali più sensibili. (Foto AP/Charlie Neibergall, File)

Il Congresso sta iniziando a mostrare interesse nell'aprire la "scatola nera" dell'intelligenza artificiale delle aziende tecnologiche con una supervisione che è parallela al modo in cui il governo federale controlla sotto i cofani delle auto e controlla le banche.

Una proposta presentata mercoledì e co-sponsorizzata da un candidato presidenziale democratico, Sen. Cory Booker, richiederebbe alle grandi aziende di testare la "responsabilità algoritmica" dei loro sistemi di intelligenza artificiale ad alto rischio, come la tecnologia che rileva i volti o prende decisioni importanti in base ai dati personali più sensibili.

"I computer sono sempre più coinvolti in molte delle decisioni chiave che gli americani prendono in relazione alla loro vita quotidiana:se qualcuno può comprare una casa, trovare un lavoro o anche andare in prigione, Il senatore Ron Wyden ha detto in un'intervista all'Associated Press. L'Oregon Democratic è co-sponsor del disegno di legge.

"Quando le aziende entrano davvero in questo, cercheranno distorsioni nei loro sistemi, "Ha detto Wyden. "Penso che troveranno molto."

La proposta dei Democratici è la prima del suo genere, e potrebbe affrontare una dura battaglia nel Senato guidato dai repubblicani. Ma riflette un esame crescente e bipartisan dell'economia dei dati in gran parte non regolamentata, tutto dai feed dei social media, brokeraggio di dati online, algoritmi finanziari e software a guida autonoma che incidono sempre più sulla vita quotidiana. Un disegno di legge bipartisan del Senato introdotto il mese scorso richiederebbe alle aziende di informare le persone prima di utilizzare su di loro un software di riconoscimento facciale, richiedendo anche test di terze parti per verificare la presenza di problemi di bias.

Studi accademici ed esempi di vita reale hanno portato alla luce sistemi di riconoscimento facciale che identificano erroneamente le donne dalla pelle più scura, strumenti di prestito computerizzati che addebitano tassi di interesse più elevati ai mutuatari latini e neri, e strumenti di reclutamento di lavoro che favoriscono gli uomini nei settori in cui già dominano.

In questo 20 marzo 2019, i fotografi scattano foto con i loro telefoni mentre il presidente Donald Trump parla al Joint Systems Manufacturing Center di Lima, Ohio. Il Congresso sta iniziando a mostrare interesse nell'aprire la "scatola nera" dell'intelligenza artificiale delle aziende tecnologiche più o meno allo stesso modo in cui il governo federale controlla sotto i cofani delle auto e controlla le banche. Anche l'amministrazione del presidente Donald Trump ne sta prendendo atto e ha reso lo sviluppo di algoritmi "affidabili" una parte della nuova iniziativa di intelligenza artificiale della Casa Bianca. (Foto AP/Michael Conroy, File)

"C'è questo mito che gli algoritmi siano così neutri, cose oggettive, "ha detto Aaron Rieke, amministratore delegato del gruppo di advocacy Upturn. "Il machine learning raccoglie modelli nella società:chi fa cosa, chi compra cosa, o chi ha quale lavoro. Questi sono modelli modellati da problemi con cui abbiamo lottato per decenni".

Anche l'amministrazione del presidente Donald Trump ne sta prendendo atto e ha fatto dello sviluppo di algoritmi "sicuri e affidabili" uno degli obiettivi principali della nuova iniziativa di intelligenza artificiale della Casa Bianca. Ma lo farebbe principalmente rafforzando un processo di creazione di standard tecnologici guidato dall'industria.

"Serve maggiore trasparenza e comparabilità dei dati, " e per rilevare e ridurre i bias in questi sistemi, ha affermato il sottosegretario al Commercio Walter Copan, che dirige il National Institute of Standards and Technology. "I consumatori stanno essenzialmente volando alla cieca".

Decine di sviluppatori di riconoscimento facciale, comprese aziende di marca come Microsoft, l'anno scorso hanno presentato i loro algoritmi proprietari all'agenzia di Copan in modo che potessero essere valutati e confrontati l'uno con l'altro. I risultati hanno mostrato miglioramenti significativi in termini di accuratezza rispetto agli anni precedenti.

Ma Wyden ha detto che gli standard volontari non sono sufficienti.

"L'autoregolamentazione è chiaramente fallita qui, " Egli ha detto.

In questo 28 giugno 2018, file foto Sen. Ron Wyden, D-Ore., membro di rango della Commissione Finanze del Senato, parla durante un'udienza a Capitol Hill a Washington. Il Congresso sta iniziando a mostrare interesse per aprire la "scatola nera" dell'intelligenza artificiale delle aziende tecnologiche con una supervisione che è parallela a come il governo federale controlla sotto i cofani delle auto e controlla le banche. Una proposta presentata mercoledì, 10 aprile 2018 e co-sponsorizzato da Wyden richiederebbe alle grandi aziende di testare la "responsabilità algoritmica" dei loro sistemi di intelligenza artificiale che stanno aiutando a prendere importanti decisioni di giustizia penale e influenzando l'accesso delle persone all'alloggio, credito e posti di lavoro. (Foto AP/Jacquelyn Martin, File)

Con una mossa più audace dell'amministrazione Trump, il Dipartimento federale per l'edilizia abitativa e lo sviluppo urbano ha incaricato Facebook di consentire ai proprietari e agli agenti immobiliari di escludere sistematicamente gruppi come i non cristiani, agli immigrati e alle minoranze di vedere annunci di case e appartamenti.

Prenotatore, in una dichiarazione sulla sua proposta di legge, ha detto che mentre l'azione su Facebook di HUD è un passo importante, è necessario scavare più a fondo per affrontare i "modi perniciosi" che la discriminazione opera sulle piattaforme tecnologiche, a volte involontariamente.

Booker ha affermato che algoritmi distorti stanno causando lo stesso tipo di pratiche immobiliari discriminatorie che hanno cercato di allontanare i suoi genitori del New Jersey e altre coppie nere da alcuni quartieri degli Stati Uniti alla fine degli anni '60. Questa volta, Egli ha detto, è più difficile da individuare e combattere.

Il disegno di legge che lui e Wyden hanno introdotto consentirebbe alla Federal Trade Commission di stabilire e applicare nuove regole per le aziende per verificare l'accuratezza, pregiudizi e potenziali problemi di privacy o sicurezza nei loro sistemi automatizzati, e correggerli se si riscontrano problemi. Esenta le aziende più piccole che guadagnano meno di $ 50 milioni all'anno, a meno che non siano intermediari di dati con informazioni su almeno 1 milione di consumatori.

La rappresentante democratica di New York Yvette Clarke, chi presenta alla Camera una proposta di legge di accompagnamento, ha detto che l'obiettivo è risolvere i problemi, non solo per valutarli. Ha detto che ha senso dare all'FTC l'autorità di monitorare regolarmente le prestazioni di questi sistemi perché "ha il dito sul polso di ciò che sta accadendo ai consumatori".

© 2019 The Associated Press. Tutti i diritti riservati.