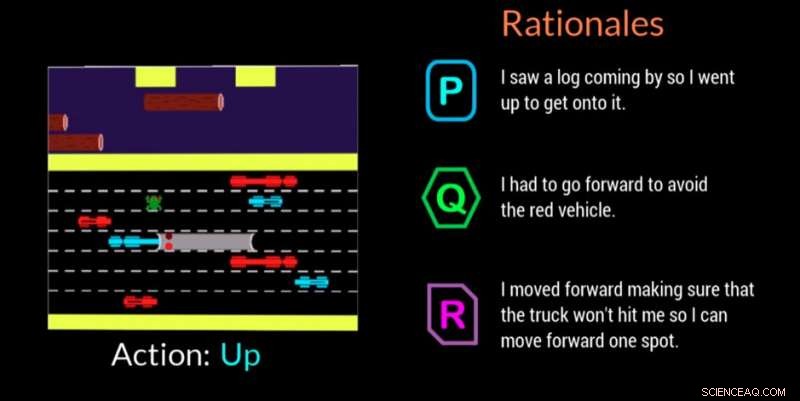

Un agente di intelligenza artificiale fornisce la motivazione per prendere una decisione in questo videogioco. Credito:Georgia Tech

ricercatori del Georgia Institute of Technology, in collaborazione con la Cornell University e l'Università del Kentucky, hanno sviluppato un agente artificialmente intelligente (AI) in grado di generare automaticamente spiegazioni in linguaggio naturale in tempo reale per trasmettere le motivazioni alla base delle sue azioni. Il lavoro è progettato per dare agli esseri umani che interagiscono con agenti di intelligenza artificiale o robot la certezza che l'agente sta eseguendo l'attività correttamente e può spiegare un errore o un comportamento errato.

L'agente usa anche un linguaggio quotidiano che i non esperti possono capire. Le spiegazioni, o "razionali" come le chiamano i ricercatori, sono progettati per essere riconoscibili e ispirare fiducia in coloro che potrebbero essere sul posto di lavoro con macchine AI o interagire con loro in situazioni sociali.

"Se il potere dell'IA deve essere democratizzato, deve essere accessibile a chiunque indipendentemente dalle proprie capacità tecniche, " disse Upol Ehsan, dottorato di ricerca studente presso la School of Interactive Computing presso la Georgia Tech e capo ricercatore.

"Poiché l'intelligenza artificiale pervade tutti gli aspetti della nostra vita, c'è una netta necessità di un design di intelligenza artificiale incentrato sull'uomo che renda i sistemi di intelligenza artificiale in scatola nera spiegabili agli utenti di tutti i giorni. Il nostro lavoro fa un passo formativo verso la comprensione del ruolo delle spiegazioni basate sul linguaggio e di come gli umani le percepiscono".

Lo studio è stato sostenuto dall'Office of Naval Research (ONR).

I ricercatori hanno sviluppato uno studio partecipante per determinare se il loro agente di intelligenza artificiale potesse offrire motivazioni che imitassero le risposte umane. Gli spettatori hanno guardato l'agente dell'IA giocare al videogioco Frogger e poi hanno classificato tre motivazioni sullo schermo in ordine di quanto bene ciascuna descrivesse la mossa di gioco dell'IA.

Delle tre giustificazioni anonime per ogni mossa:una risposta generata dall'uomo, la risposta dell'agente AI, e una risposta generata casualmente:i partecipanti hanno preferito prima le motivazioni generate dall'uomo, ma le risposte generate dall'IA sono state un secondo vicino.

Frogger ha offerto ai ricercatori la possibilità di addestrare un'IA in un "ambiente decisionale sequenziale, " che è una sfida significativa per la ricerca perché le decisioni che l'agente ha già preso influenzano le decisioni future. Pertanto, spiegare la catena del ragionamento agli esperti è difficile, e ancora di più quando si comunica con i non esperti, secondo i ricercatori.

Gli spettatori umani hanno compreso l'obiettivo di Frogger nel riportare la rana a casa sana e salva senza essere investita da veicoli in movimento o annegata nel fiume. Le semplici meccaniche di gioco di salire, fuori uso, sinistra o destra, ha permesso ai partecipanti di vedere cosa stava facendo l'IA, e valutare se le motivazioni sullo schermo giustificassero chiaramente la mossa.

Gli spettatori hanno giudicato le motivazioni in base a:

Le motivazioni generate dall'intelligenza artificiale che sono state classificate più in alto dai partecipanti sono state quelle che hanno mostrato il riconoscimento delle condizioni ambientali e dell'adattabilità, così come quelli che hanno comunicato la consapevolezza dei pericoli imminenti e pianificato per loro. È stato riscontrato che le informazioni ridondanti che hanno appena affermato l'ovvio o la caratterizzazione errata dell'ambiente hanno un impatto negativo.

"Questo progetto riguarda più la comprensione delle percezioni e delle preferenze umane di questi sistemi di intelligenza artificiale che la creazione di nuove tecnologie, " ha detto Ehsan. "Al centro della spiegazione c'è il senso. Stiamo cercando di capire quel fattore umano".

Un secondo studio correlato ha convalidato la decisione dei ricercatori di progettare il loro agente di intelligenza artificiale per essere in grado di offrire uno dei due distinti tipi di razionali:

In questo secondo studio, ai partecipanti sono state offerte motivazioni generate dall'intelligenza artificiale solo dopo aver visto l'intelligenza artificiale giocare a Frogger. È stato chiesto loro di selezionare la risposta che preferivano in uno scenario in cui un'IA commetteva un errore o si comportava in modo imprevisto. Non sapevano che le motivazioni erano raggruppate nelle due categorie.

Con un margine di 3 a 1, i partecipanti hanno preferito le risposte che sono state classificate nella categoria "quadro completo". Le risposte hanno mostrato che le persone hanno apprezzato l'intelligenza artificiale pensando ai passi futuri piuttosto che solo a ciò che era nel momento, che potrebbe renderli più inclini a commettere un altro errore. Le persone volevano anche saperne di più in modo da poter aiutare direttamente l'IA a correggere il comportamento errante.

"La comprensione situata delle percezioni e delle preferenze delle persone che lavorano con le macchine AI ci fornisce una potente serie di intuizioni utilizzabili che possono aiutarci a progettare meglio incentrati sull'uomo, generazione di razionalità, agenti autonomi, " ha detto Mark Riedl, professore di Interactive Computing e membro principale della facoltà del progetto.

Una possibile direzione futura per la ricerca applicherà i risultati ad agenti autonomi di vario tipo, come agenti di accompagnamento, e come potrebbero rispondere in base al compito da svolgere. I ricercatori esamineranno anche come gli agenti potrebbero rispondere in diversi scenari, come durante una risposta di emergenza o quando si aiutano gli insegnanti in classe.

La ricerca è stata presentata a marzo alla conferenza sulle interfacce utente intelligenti 2019 dell'Association for Computing Machinery. L'articolo si intitola "Generazione razionale automatizzata:una tecnica per l'IA spiegabile e i suoi effetti sulle percezioni umane". Ehsan presenterà un documento di posizione che evidenzierà le sfide di progettazione e valutazione dei sistemi di IA spiegabile incentrati sull'uomo al prossimo workshop Emerging Perspectives in Human-Centered Machine Learning alla conferenza ACM CHI 2019, 4-9 maggio, a Glasgow, Scozia.