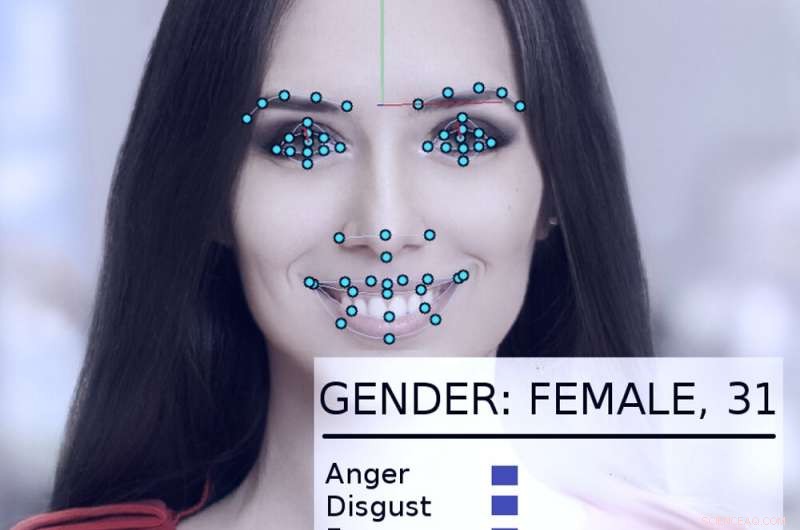

Un sistema di tracciamento e analisi del volto prende in esame il volto di una donna. Credito:Abyssus/Wikimedia Commons, CC BY-SA

I sistemi di intelligenza artificiale possono, se utilizzati correttamente, contribuire a rendere il governo più efficace e reattivo, migliorare la vita dei cittadini. Usato in modo improprio, però, le visioni distopiche di "1984" di George Orwell diventano più realistiche.

Da soli e sollecitati da un nuovo ordine esecutivo presidenziale, governi negli Stati Uniti, comprese le agenzie statali e federali, stanno esplorando modi per utilizzare le tecnologie AI.

Come ricercatore di intelligenza artificiale da oltre 40 anni, che è stato consulente o partecipante a molti progetti governativi, Credo che valga la pena notare che a volte l'hanno fatto bene – e altre volte non così bene. I potenziali danni e benefici sono significativi.

Un primo successo

Nel 2015, il Dipartimento per la sicurezza interna degli Stati Uniti ha sviluppato un sistema di intelligenza artificiale chiamato "Emma, " un chatbot in grado di rispondere alle domande postegli in inglese normale, senza bisogno di sapere come il "suo" sito web introduttivo chiama "parlare del governo" - tutti i termini e gli acronimi ufficiali utilizzati nei documenti dell'agenzia.

Entro la fine del 2016, Il DHS ha riferito che Emma stava già aiutando a rispondere a quasi mezzo milione di domande al mese, consentendo al DHS di gestire molte più richieste rispetto a prima, e lasciare che i dipendenti umani trascorrano più tempo ad aiutare le persone con domande più complicate che vanno oltre le capacità di Emma. Questa sorta di intelligenza artificiale che automatizza la conversazione è stata ora utilizzata da altre agenzie governative, nelle città e nei paesi di tutto il mondo.

L'acqua di Flint

Un esempio più complicato di come i governi potrebbero applicare in modo appropriato l'IA può essere visto in Flint, Michigan. Mentre i governi locali e statali lottavano per combattere la contaminazione da piombo nell'acqua potabile della città, divenne chiaro che avrebbero dovuto sostituire i restanti tubi dell'acqua di piombo della città. Però, i registri della città erano incompleti, e sarebbe stato estremamente costoso scavare tutti i tubi della città per vedere se erano di piombo o di rame.

Anziché, scienziati informatici e dipendenti del governo hanno collaborato per analizzare una vasta gamma di dati su ciascuno dei 55, 000 proprietà in città, compreso quanti anni aveva la casa, per calcolare la probabilità che fosse servito da tubi di piombo. Prima che il sistema fosse utilizzato, L'80% dei tubi dissotterrati doveva essere sostituito, il che significava il 20% delle volte, denaro e fatica venivano sprecati su tubi che non avevano bisogno di essere sostituiti.

Il sistema di intelligenza artificiale ha aiutato gli ingegneri a concentrarsi su proprietà ad alto rischio, identificare un insieme di proprietà che più probabilmente necessitano di sostituzioni di tubi. Quando gli ispettori della città hanno visitato per verificare la situazione, l'algoritmo aveva ragione il 70% delle volte. Ciò prometteva di risparmiare enormi quantità di denaro e di accelerare il processo di sostituzione dei tubi.

Però, la politica locale si è messa in mezzo. Molti membri del pubblico non hanno capito perché il sistema stava identificando le case che ha fatto, e si oppose, dicendo che il metodo AI stava ignorando ingiustamente le loro case. Dopo che i funzionari della città hanno smesso di usare l'algoritmo, solo il 15% dei tubi dissotterrati era di piombo. Ciò ha reso il progetto di sostituzione più lento e più costoso.

Esempi angoscianti

Il problema in Flint era che la gente non capiva che la tecnologia AI veniva usata bene, e che le persone stavano verificando i suoi risultati con ispezioni indipendenti. In parte, questo perché non si fidavano dell'IA – e in alcuni casi c'è una buona ragione per questo.

Nel 2017, Facevo parte di un gruppo di oltre quattro dozzine di ricercatori di intelligenza artificiale che hanno inviato una lettera al segretario ad interim del Dipartimento per la sicurezza interna degli Stati Uniti. Abbiamo espresso preoccupazione per la proposta di utilizzare sistemi automatizzati per determinare se una persona in cerca di asilo negli Stati Uniti sarebbe diventata un "membro della società che contribuiva positivamente" o era più probabile che fosse una minaccia terroristica.

"In parole povere, "La nostra lettera diceva, "nessun metodo computazionale può fornire valutazioni affidabili o obiettive dei tratti che [DHS] cerca di misurare". Abbiamo spiegato che l'apprendimento automatico è suscettibile di un problema chiamato "skew dei dati, " in cui la capacità del sistema di prevedere una caratteristica dipende in parte da quanto è comune quella caratteristica nei dati utilizzati per addestrare il sistema.

Quindi in un database di 300 milioni di americani, se una persona su 100 lo è, dire, di origine indiana, il sistema sarà abbastanza preciso nell'identificarli. Ma se si guarda a una caratteristica condivisa da un solo americano su un milione, non ci sono davvero abbastanza dati per l'algoritmo per fare una buona analisi.

Come spiegava la lettera, "sulla scala della popolazione americana e dei tassi di immigrazione, gli atti criminali sono relativamente rari, e gli atti terroristici sono estremamente rari." È estremamente improbabile che l'analisi algoritmica identifichi potenziali terroristi. Fortunatamente, le nostre argomentazioni si sono dimostrate convincenti. A maggio 2018, Il DHS ha annunciato che non utilizzerà un algoritmo di apprendimento automatico in questo modo.

Altri sforzi preoccupanti

Altri usi governativi dell'IA vengono messi in discussione, anche - come i tentativi di "polizia predittiva, " fissare importi di cauzione e condanne penali e assumere dipendenti pubblici. Tutti questi hanno dimostrato di essere soggetti a problemi tecnici e limitazioni dei dati che possono influenzare le loro decisioni in base alla razza, genere o background culturale.

Altre tecnologie AI come il riconoscimento facciale, la sorveglianza automatizzata e la raccolta di dati di massa stanno sollevando preoccupazioni reali sulla sicurezza, riservatezza, correttezza e precisione in una società democratica.

Come dimostra l'ordine esecutivo di Trump, c'è un interesse significativo nello sfruttare l'IA per il suo massimo potenziale positivo. Ma i notevoli pericoli di abuso, l'uso improprio e il pregiudizio, intenzionali o meno, hanno il potenziale per lavorare contro gli stessi principi su cui sono state costruite le democrazie internazionali.

Man mano che l'uso delle tecnologie AI cresce, sia originariamente ben intenzionato o deliberatamente autoritario, aumenta anche il potenziale di abuso. Senza alcuna supervisione attualmente esistente a livello di governo negli Stati Uniti, il modo migliore per evitare questi abusi è insegnare al pubblico gli usi appropriati dell'IA attraverso conversazioni tra scienziati, cittadini e amministratori pubblici interessati ad aiutare a determinare quando e dove è inappropriato utilizzare questi nuovi potenti strumenti.

Questo articolo è stato ripubblicato da The Conversation con una licenza Creative Commons. Leggi l'articolo originale.