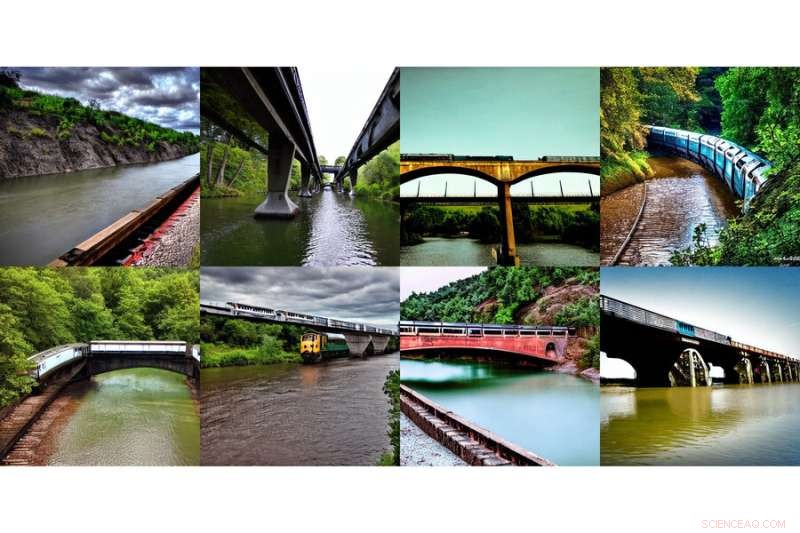

Questa serie di immagini generate, che mostrano "un treno su un ponte" e "un fiume sotto il ponte", è stata generata utilizzando un nuovo metodo sviluppato dai ricercatori del MIT. Credit:Massachusetts Institute of Technology

Internet ha avuto un momento di benessere collettivo con l'introduzione di DALL-E, un generatore di immagini basato sull'intelligenza artificiale ispirato dall'artista Salvador Dali e dall'adorabile robot WALL-E che usa il linguaggio naturale per produrre qualsiasi immagine misteriosa e bella il tuo cuore desidera . Vedere input digitati come "Gopher sorridente con in mano un cono gelato" prendono istantaneamente vita in chiara risonanza con il mondo.

Dire che il gopher sorridente e gli attributi che appaiono sullo schermo non è un compito da poco. DALL-E 2 utilizza qualcosa chiamato modello di diffusione, in cui tenta di codificare l'intero testo in una descrizione per generare un'immagine. Ma una volta che il testo ha molti più dettagli, è difficile per una singola descrizione catturarli tutti. Inoltre, sebbene siano altamente flessibili, a volte faticano a comprendere la composizione di determinati concetti, come confondere gli attributi o le relazioni tra oggetti diversi.

Per generare immagini più complesse con una migliore comprensione, gli scienziati del Computer Science and Artificial Intelligence Laboratory (CSAIL) del MIT hanno strutturato il modello tipico da una diversa angolazione:hanno aggiunto una serie di modelli insieme, in cui tutti cooperano per generare le immagini desiderate che catturano molteplici aspetti diversi come richiesto dal testo o dalle etichette di input. Per creare un'immagine con due componenti, diciamo, descritte da due frasi di descrizione, ogni modello affronterebbe un particolare componente dell'immagine.

Questa serie di immagini generate, che mostrano "un fiume che porta alle montagne" e "alberi rossi sul lato", è stata generata utilizzando un nuovo metodo sviluppato dai ricercatori del MIT. Credito:Massachusetts Institute of Technology

I modelli apparentemente magici alla base della generazione dell'immagine funzionano suggerendo una serie di passaggi di raffinamento iterativo per ottenere l'immagine desiderata. Inizia con un'immagine "cattiva" e poi la perfeziona gradualmente fino a diventare l'immagine selezionata. Componendo più modelli insieme, perfezionano insieme l'aspetto a ogni passaggio, quindi il risultato è un'immagine che mostra tutti gli attributi di ciascun modello. Facendo cooperare più modelli, puoi ottenere combinazioni molto più creative nelle immagini generate.

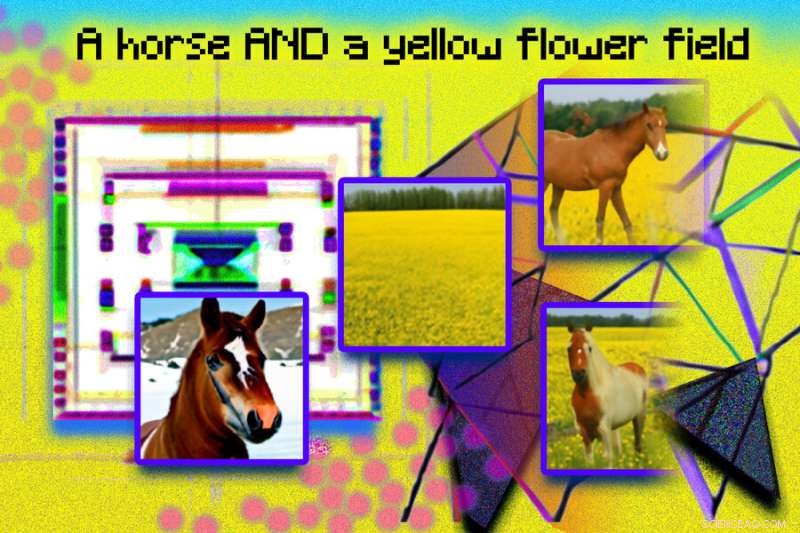

Prendi, ad esempio, un camion rosso e una serra. Il modello confonderà i concetti di camion rosso e casa verde quando queste frasi diventano molto complicate. Un tipico generatore come DALL-E 2 potrebbe creare un camion verde e una casa rossa, quindi scambierà questi colori. L'approccio del team è in grado di gestire questo tipo di associazione di attributi con oggetti e, soprattutto quando sono presenti più insiemi di cose, può gestire ogni oggetto in modo più accurato.

"Il modello può modellare efficacemente le posizioni degli oggetti e le descrizioni relazionali, il che è una sfida per i modelli di generazione di immagini esistenti. Ad esempio, metti un oggetto e un cubo in una determinata posizione e una sfera in un'altra. DALL-E 2 è bravo a generare immagini, ma a volte ha difficoltà a comprendere le relazioni oggettuali", afferma MIT CSAIL Ph.D. studente e co-autore principale Shuang Li, "Oltre all'arte e alla creatività, forse potremmo usare il nostro modello per insegnare. Se vuoi dire a un bambino di mettere un cubo sopra una sfera, e se lo diciamo in un linguaggio, potrebbe essere difficile da capire per loro. Ma il nostro modello può generare l'immagine e mostrarla."

I ricercatori sono stati in grado di creare alcune immagini sorprendenti e surreali con il testo, "un cane" e "il cielo". A sinistra compaiono un cane e delle nuvole separatamente, etichettati "cane" e "cielo" sotto, e a destra compaiono due immagini di cani simili a nuvole con l'etichetta "cane E cielo" sotto. Credito:Massachusetts Institute of Technology

Rendere orgoglioso Dali

Diffusione componibile, il modello del team, utilizza modelli di diffusione insieme a operatori compositivi per combinare descrizioni di testo senza ulteriore formazione. L'approccio del team acquisisce i dettagli del testo in modo più accurato rispetto al modello di diffusione originale, che codifica direttamente le parole come un'unica lunga frase. Ad esempio, dato "un cielo rosa" E "una montagna blu all'orizzonte" E "fiori di ciliegio davanti alla montagna", il modello del team è stato in grado di produrre esattamente quell'immagine, mentre il modello di diffusione originale rendeva il cielo azzurro e tutto davanti alle montagne rosa.

"Il fatto che il nostro modello sia componibile significa che puoi imparare diverse porzioni del modello, una alla volta. Puoi prima imparare un oggetto sopra un altro, quindi imparare un oggetto a destra di un altro e poi imparare qualcosa a sinistra di un altro", afferma il co-autore principale e MIT CSAIL Ph.D. studente Yilun Du. "Dal momento che possiamo comporli insieme, puoi immaginare che il nostro sistema ci consenta di apprendere in modo incrementale la lingua, le relazioni o la conoscenza, che riteniamo sia una direzione piuttosto interessante per il lavoro futuro."

Questa illustrazione fotografica è stata creata utilizzando immagini generate da un sistema MIT chiamato Composable Diffusion e disposte in Photoshop. Frasi come "modello di diffusione" e "rete" sono state utilizzate per generare i punti rosa e le immagini geometriche e angolari. La frase "un cavallo E un campo di fiori gialli" è inclusa nella parte superiore dell'immagine. A sinistra vengono visualizzate le immagini generate di un cavallo e un campo giallo, mentre a destra vengono visualizzate le immagini combinate di un cavallo in un campo di fiori gialli. Credito:Massachusetts Institute of Technology

Sebbene abbia mostrato abilità nella generazione di immagini fotorealistiche complesse, ha comunque dovuto affrontare delle sfide poiché il modello è stato addestrato su un set di dati molto più piccolo di quelli come DALL-E 2, quindi c'erano alcuni oggetti che semplicemente non poteva catturare.

Ora che Composable Diffusion può funzionare su modelli generativi, come DALL-E 2, gli scienziati vogliono esplorare l'apprendimento continuo come potenziale passo successivo. Dato che di solito viene aggiunto di più alle relazioni oggettuali, vogliono vedere se i modelli di diffusione possono iniziare a "imparare" senza dimenticare le conoscenze apprese in precedenza, in un luogo in cui il modello può produrre immagini sia con la conoscenza precedente che con quella nuova.

"Questa ricerca propone un nuovo metodo per comporre concetti nella generazione da testo a immagine non concatenandoli per formare un prompt, ma piuttosto calcolando i punteggi rispetto a ciascun concetto e componendoli utilizzando operatori di congiunzione e negazione", afferma Mark Chen, co-creatore di DALL-E 2 e ricercatore presso OpenAI. "Questa è una bella idea che sfrutta l'interpretazione basata sull'energia dei modelli di diffusione in modo che le vecchie idee sulla composizionalità utilizzando modelli basati sull'energia possano essere applicate. L'approccio è anche in grado di utilizzare una guida priva di classificatori ed è sorprendente che osserva che supera la linea di base GLIDE su vari benchmark compositivi e può produrre qualitativamente tipi molto diversi di generazioni di immagini."

"Gli esseri umani possono comporre scene che includono elementi diversi in una miriade di modi, ma questo compito è impegnativo per i computer", afferma Bryan Russel, ricercatore presso Adobe Systems. "Questo lavoro propone una formulazione elegante che compone in modo esplicito una serie di modelli di diffusione per generare un'immagine data una complessa richiesta di linguaggio naturale". + Esplora ulteriormente

Questa storia è stata ripubblicata per gentile concessione di MIT News (web.mit.edu/newsoffice/), un popolare sito che copre notizie sulla ricerca, l'innovazione e l'insegnamento del MIT.