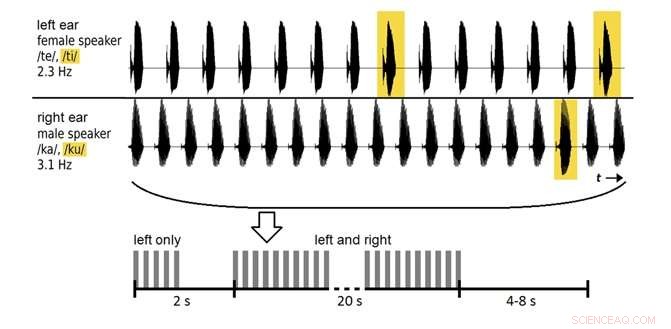

Un'interfaccia uditiva cervello-computer può dire a quale oratore sta prestando attenzione un ascoltatore con una precisione fino all'80%, a seconda del tempo di analisi. Credito:Souto et al. ©2016 IOP Publishing

(Phys.org)—I ricercatori stanno lavorando alle prime fasi di un'interfaccia cervello-computer (BCI) che può dire chi stai ascoltando in una stanza piena di rumore e altre persone che parlano. Nel futuro, la tecnologia potrebbe essere incorporata negli apparecchi acustici come minuscoli beamformer che puntano nella direzione di interesse in modo da sintonizzarsi su determinate conversazioni, suoni, o voci a cui un individuo sta prestando attenzione, mentre si elimina il rumore di fondo indesiderato.

I ricercatori, Carlos da Silva Souto e coautori presso il Dipartimento di Fisica Medica e Cluster of Excellence Hearing4all dell'Università di Oldenburg, hanno pubblicato un articolo su un BCI uditivo proof-of-concept in un recente numero di Fisica Biomedica e Ingegneria Express .

Finora, la maggior parte della ricerca BCI si è concentrata principalmente sugli stimoli visivi, che attualmente supera i sistemi che utilizzano stimoli uditivi, forse a causa della superficie corticale più ampia del sistema visivo rispetto alla corteccia uditiva. Però, per le persone ipovedenti o completamente paralizzate, BCI uditivo potrebbe offrire una potenziale alternativa.

Nel nuovo studio, 12 volontari hanno ascoltato due voci registrate (un maschio, una femmina) pronunciando sillabe ripetute, e gli è stato chiesto di prestare attenzione a una sola delle voci. Nelle prime sessioni, i dati dell'elettroencefalogramma (EEG) sull'attività elettrica del cervello sono stati usati per addestrare i partecipanti. Nelle sessioni successive, il sistema è stato testato sulla precisione con cui classificava i dati EEG per determinare a quale voce stava prestando attenzione il volontario.

All'inizio, il sistema ha classificato i dati con una precisione di circa il 60%, al di sopra del livello di probabilità, ma non abbastanza buono per l'uso pratico. Aumentando il tempo di analisi da 20 secondi a 2 minuti, i ricercatori potrebbero migliorare la precisione fino a quasi l'80%. Sebbene questa finestra di analisi sia troppo lunga per le situazioni della vita reale, e la precisione può essere ulteriormente migliorata, i risultati sono tra i primi a mostrare che è possibile classificare i dati EEG evocati da sillabe parlate.

Nel futuro, i ricercatori intendono ottimizzare i metodi di classificazione per migliorare ulteriormente le prestazioni del sistema.

© 2017 Phys.org