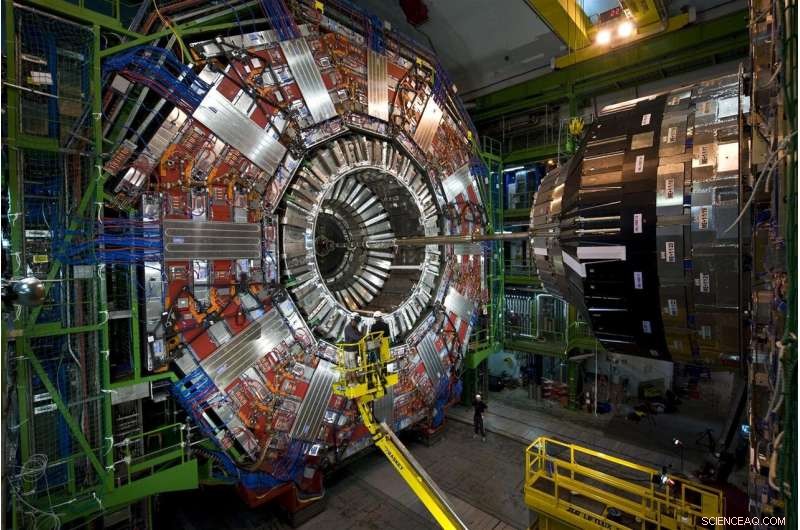

Le particelle che emergono dalle collisioni di protoni al Large Hadron Collider del CERN viaggiano attraverso questo strumento multistrato, il rilevatore CMS. Nel 2026, LHC produrrà 20 volte i dati che produce attualmente, e CMS è attualmente in fase di aggiornamento per leggere ed elaborare il diluvio di dati. Credito:Maximilien Brice, CERN

Ogni collisione di protoni al Large Hadron Collider è diversa, ma solo alcuni sono speciali. Le collisioni speciali generano particelle in schemi insoliti, possibili manifestazioni di nuove, fisica che infrange le regole o aiuta a riempire la nostra immagine incompleta dell'universo.

Trovare queste collisioni è più difficile della proverbiale ricerca dell'ago nel pagliaio. Ma un aiuto rivoluzionario è in arrivo. Gli scienziati del Fermilab e altri collaboratori hanno testato con successo un prototipo di tecnologia di apprendimento automatico che accelera l'elaborazione da 30 a 175 volte rispetto ai metodi tradizionali.

Affrontare 40 milioni di collisioni ogni secondo, gli scienziati dell'LHC usano potenti, agili computer per cogliere le gemme, che si tratti di una particella di Higgs o di accenni di materia oscura, dalla vasta statica delle normali collisioni.

Rifling attraverso i dati simulati di collisione LHC, la tecnologia di apprendimento automatico ha imparato con successo a identificare un particolare schema post-collisione, un particolare spruzzo di particelle che volano attraverso un rivelatore, mentre scorreva attraverso una sorprendente 600 immagini al secondo. I metodi tradizionali elaborano meno di un'immagine al secondo.

La tecnologia potrebbe anche essere offerta come servizio su computer esterni. L'utilizzo di questo modello di scaricamento consentirebbe ai ricercatori di analizzare più dati più rapidamente e di lasciare più spazio di calcolo LHC disponibile per svolgere altro lavoro.

È uno sguardo promettente su come i servizi di apprendimento automatico stiano supportando un campo in cui già enormi quantità di dati non potranno che aumentare.

La sfida:più dati, più potenza di calcolo

I ricercatori stanno attualmente aggiornando l'LHC per distruggere i protoni a cinque volte la sua velocità attuale. Entro il 2026, la macchina sotterranea circolare di 17 miglia presso il laboratorio europeo del CERN produrrà 20 volte più dati di quanto non faccia ora.

CMS è uno dei rivelatori di particelle del Large Hadron Collider, e i collaboratori di CMS sono nel bel mezzo di alcuni aggiornamenti propri, consentendo l'intricato, strumento di alto livello per scattare foto più sofisticate delle collisioni di particelle di LHC. Fermilab è il principale laboratorio statunitense per l'esperimento CMS.

Se gli scienziati di LHC volessero salvare tutti i dati grezzi sulle collisioni che raccoglierebbero in un anno dall'LHC ad alta luminosità, dovrebbero trovare un modo per memorizzare circa 1 exabyte (circa 1 trilione di dischi rigidi esterni personali), di cui solo una scheggia può svelare nuovi fenomeni. I computer LHC sono programmati per selezionare questa piccola frazione, prendere decisioni in frazioni di secondo su quali dati sono sufficientemente preziosi da essere inviati a valle per ulteriori studi.

Attualmente, il sistema informatico di LHC ne mantiene circa uno su 100, 000 eventi particellari. Ma gli attuali protocolli di archiviazione non saranno in grado di tenere il passo con il futuro flusso di dati, che si accumuleranno in decenni di acquisizione di dati. E le immagini ad alta risoluzione catturate dal rilevatore CMS aggiornato non renderanno il lavoro più semplice. Tutto si traduce in una necessità di risorse di elaborazione 10 volte superiori a quelle di cui dispone attualmente l'LHC.

I fisici delle particelle stanno esplorando l'uso di computer con capacità di apprendimento automatico per l'elaborazione di immagini di collisioni di particelle al CMS, insegnando loro a identificare rapidamente vari modelli di collisione. Credito:Eamonn Maguire/Antarctic Design

Il recente test del prototipo mostra che, con i progressi nell'apprendimento automatico e nell'hardware informatico, i ricercatori si aspettano di essere in grado di vagliare i dati che emergono dal prossimo LHC ad alta luminosità quando sarà online.

"La speranza qui è che tu possa fare cose molto sofisticate con l'apprendimento automatico e anche farle più velocemente, " ha detto Nhan Tran, uno scienziato del Fermilab sull'esperimento CMS e uno dei protagonisti del recente test. "Questo è importante, poiché i nostri dati diventeranno sempre più complessi con rilevatori aggiornati e ambienti di collisione più trafficati".

Apprendimento automatico in soccorso:la differenza di inferenza

L'apprendimento automatico nella fisica delle particelle non è nuovo. I fisici utilizzano l'apprendimento automatico per ogni fase dell'elaborazione dei dati in un esperimento di collisione.

Ma con la tecnologia di apprendimento automatico in grado di analizzare i dati LHC fino a 175 volte più velocemente rispetto ai metodi tradizionali, i fisici delle particelle stanno salendo un passo rivoluzionario nel corso del calcolo delle collisioni.

I tassi rapidi sono grazie all'hardware intelligentemente progettato nella piattaforma, Azure Machine Learning di Microsoft, che accelera un processo chiamato inferenza.

Per comprendere l'inferenza, considera un algoritmo che è stato addestrato per riconoscere l'immagine di una motocicletta:l'oggetto ha due ruote e due maniglie che sono attaccate a un corpo di metallo più grande. L'algoritmo è abbastanza intelligente da sapere che una carriola, che ha attributi simili, non è una moto. Mentre il sistema scansiona nuove immagini di altre due ruote, oggetti a due manici, predice, o deduce, quali sono le motociclette. E man mano che gli errori di previsione dell'algoritmo vengono corretti, diventa piuttosto abile nell'identificarli. Un miliardo di scansioni dopo, è nel suo gioco di inferenza.

La maggior parte delle piattaforme di machine learning sono costruite per capire come classificare le immagini, ma non immagini specifiche per la fisica. I fisici devono insegnare loro la parte di fisica, come riconoscere tracce create dal bosone di Higgs o cercare accenni di materia oscura.

Ricercatori del Fermilab, CERN, MIT, l'Università di Washington e altri collaboratori hanno addestrato Azure ML per identificare le immagini dei quark top, una particella elementare di breve durata che è circa 180 volte più pesante di un protone, da dati CMS simulati. Nello specifico, Azure doveva cercare immagini di getti di quark top, nubi di particelle estratte dal vuoto da un singolo quark top che si allontanava dalla collisione.

"Gli abbiamo inviato le immagini, addestrandolo su dati fisici, ", ha affermato lo scienziato del Fermilab Burt Holzman, una guida nel progetto. "E ha mostrato prestazioni all'avanguardia. È stato molto veloce. Ciò significa che possiamo convogliare un gran numero di queste cose. In generale, queste tecniche sono piuttosto buone."

Una delle tecniche alla base dell'accelerazione dell'inferenza è combinare processori tradizionali con processori specializzati, un matrimonio noto come architettura informatica eterogenea.

I dati degli esperimenti di fisica delle particelle sono archiviati in fattorie di calcolo come questa, il Grid Computing Center del Fermilab. Le organizzazioni esterne offrono le loro fattorie informatiche come servizio per esperimenti di fisica delle particelle, rendere disponibile più spazio sui server degli esperimenti. Attestazione:Reidar Hahn

Piattaforme diverse utilizzano architetture diverse. I processori tradizionali sono CPU (unità di elaborazione centrale). I processori specializzati più noti sono le GPU (unità di elaborazione grafica) e gli FPGA (matrici di porte programmabili sul campo). Azure Machine Learning combina CPU e FPGA.

"La ragione per cui questi processi devono essere accelerati è che si tratta di grandi calcoli. Stai parlando di 25 miliardi di operazioni, " Disse Tran. "Montandolo su un FPGA, mappandolo su, e farlo in un ragionevole lasso di tempo è un vero successo".

E inizia ad essere offerto come servizio, pure. Il test è stata la prima volta che qualcuno ha dimostrato come questo tipo di eterogeneità, l'architettura as-a-service può essere utilizzata per la fisica fondamentale.

Nel mondo informatico, usare qualcosa "come servizio" ha un significato specifico. Un'organizzazione esterna fornisce risorse (apprendimento automatico o hardware) come servizio, e gli utenti, gli scienziati, attingono a tali risorse quando necessario. È simile al modo in cui la tua azienda di streaming video offre ore di abbuffata TV come servizio. Non è necessario possedere i propri DVD e lettori DVD. Utilizzi invece la loro libreria e interfaccia.

I dati del Large Hadron Collider vengono in genere archiviati ed elaborati su server di computer presso il CERN e istituzioni partner come Fermilab. Con l'apprendimento automatico offerto con la stessa facilità con cui potrebbe essere qualsiasi altro servizio Web, calcoli intensivi possono essere eseguiti ovunque sia offerto il servizio, anche fuori sede. Ciò rafforza le capacità dei laboratori con potenza e risorse di calcolo aggiuntive, evitando loro di dover fornire i propri server.

"L'idea di fare calcolo accelerato è da decenni, ma il modello tradizionale era acquistare un cluster di computer con GPU e installarlo localmente presso il laboratorio, " ha detto Holzman. "L'idea di scaricare il lavoro in una fattoria fuori sede con hardware specializzato, fornendo l'apprendimento automatico come servizio, che ha funzionato come pubblicizzato."

La farm di Azure Machine Learning si trova in Virginia. Ci vogliono solo 100 millisecondi per i computer del Fermilab vicino a Chicago, Illinois, per inviare un'immagine di un evento particella al cloud di Azure, elaborarlo, e restituirlo. Questo è un 2, 500 chilometri, viaggio denso di dati in un batter d'occhio.

"L'impianto idraulico che accompagna tutto ciò è un altro risultato, " Ha detto Tran. "Il concetto di astrarre quei dati come qualcosa che si invia da qualche altra parte, e torna solo, è stata la cosa più piacevolmente sorprendente di questo progetto. Non dobbiamo sostituire tutto nel nostro centro di calcolo con un sacco di cose nuove. Lo teniamo tutto, invia i calcoli e fallo tornare più tardi."

Gli scienziati non vedono l'ora di scalare la tecnologia per affrontare altre sfide legate ai big data all'LHC. Hanno anche in programma di testare altre piattaforme, come Amazon AWS, Google Cloud e IBM Cloud, mentre esplorano cos'altro può essere realizzato attraverso l'apprendimento automatico, che ha visto una rapida evoluzione negli ultimi anni.

"I modelli che erano all'avanguardia per il 2015 sono oggi standard, " ha detto Tran.

Come strumento, l'apprendimento automatico continua a fornire alla fisica delle particelle nuovi modi di intravedere l'universo. È anche impressionante di per sé.

"Che possiamo prendere qualcosa che è addestrato a discriminare tra immagini di animali e persone, fare qualche calcolo di modesta quantità, e mi ha detto la differenza tra un getto di quark top e uno sfondo?" ha detto Holzman. "È qualcosa che mi fa impazzire".