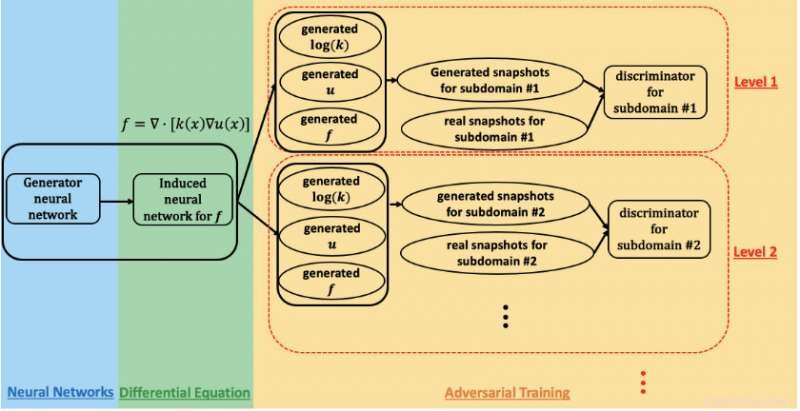

Uno schema della rete generativa avversaria basata sulla fisica utilizzata per stimare i parametri e quantificare l'incertezza nel flusso sotto la superficie nel sito di Hanford. Attestazione:Prabhat, Laboratorio Nazionale Lawrence Berkeley

Una collaborazione di ricerca tra Lawrence Berkeley National Laboratory (Berkeley Lab), Laboratorio nazionale nord-occidentale del Pacifico (PNNL), Università Brown, e NVIDIA ha ottenuto prestazioni exaflop sul supercomputer Summit con un'applicazione di deep learning utilizzata per modellare il flusso del sottosuolo nello studio della bonifica delle scorie nucleari. Il loro successo, che sarà presentato durante il workshop "Deep Learning on Supercomputers" presso SC19, dimostra la promessa delle reti generative avversarie (GAN) basate sulla fisica per l'analisi di complessi, problemi scientifici su larga scala.

"Nella scienza conosciamo le leggi della fisica e i principi di osservazione:massa, quantità di moto, energia, eccetera., " disse George Karniadakis, professore di matematica applicata alla Brown e coautore del documento del workshop SC19. "Il concetto di GAN informato dalla fisica è quello di codificare le informazioni precedenti dalla fisica nella rete neurale. Ciò consente di andare ben oltre il dominio dell'addestramento, che è molto importante nelle applicazioni in cui le condizioni possono cambiare."

I GAN sono stati applicati per modellare l'aspetto del viso umano con notevole precisione, ha osservato Prabhat, un coautore del documento SC19 che guida il team dei servizi di dati e analisi presso il National Energy Research Scientific Computing Center del Berkeley Lab. "Nella scienza, Berkeley Lab ha esplorato l'applicazione dei GAN vanigliati per la creazione di universi sintetici ed esperimenti di fisica delle particelle; una delle sfide aperte finora è stata l'incorporazione di vincoli fisici nelle previsioni, " ha detto. "George e il suo gruppo alla Brown hanno aperto la strada all'approccio di incorporare la fisica nei GAN e usarli per sintetizzare i dati, in questo caso, campi di flusso sotterranei".

Per questo studio, i ricercatori si sono concentrati sul sito di Hanford, fondata nel 1943 come parte del Progetto Manhattan per produrre plutonio per armi nucleari e infine sede del primo reattore di produzione di plutonio su vasta scala al mondo, altri otto reattori nucleari, e cinque complessi per la lavorazione del plutonio. Quando la produzione di plutonio terminò nel 1989, sono rimasti decine di milioni di galloni di rifiuti radioattivi e chimici in grandi serbatoi sotterranei e più di 100 miglia quadrate di acque sotterranee contaminate derivanti dallo smaltimento di circa 450 miliardi di galloni di liquidi nei siti di smaltimento del suolo. Quindi negli ultimi 30 anni il Dipartimento dell'Energia degli Stati Uniti ha lavorato con l'Agenzia per la protezione dell'ambiente e il Dipartimento di ecologia dello Stato di Washington per ripulire Hanford, che si trova su 580 miglia quadrate (quasi 500, 000 acri) nel centro-sud di Washington, intere parti di esso adiacenti al fiume Columbia, il più grande fiume nel nord-ovest del Pacifico e un'arteria fondamentale per l'industria e la fauna selvatica.

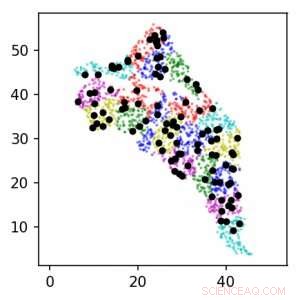

Utilizzando i GAN basati sulla fisica sul supercomputer Summit, il team di ricerca è stato in grado di stimare i parametri e quantificare l'incertezza nel flusso sotterraneo. Questa immagine mostra le posizioni dei sensori intorno al sito di Hanford per i livelli 1 (nero) e 2 (colore). Le unità sono in km. Credito:Lawrence Berkeley National Laboratory

Per monitorare lo sforzo di pulizia, i lavoratori hanno fatto affidamento sulla perforazione di pozzi presso il sito di Hanford e sul posizionamento di sensori in quei pozzi per raccogliere dati sulle proprietà geologiche e sul flusso delle acque sotterranee e osservare la progressione dei contaminanti. Gli ambienti sotterranei come il sito di Hanford sono molto eterogenei con proprietà spaziali variabili, ha spiegato Alex Tartakovsky, un matematico computazionale al PNNL e coautore dell'articolo SC19. "Stimare le proprietà del sito di Hanford solo dai dati richiederebbe più di un milione di misurazioni, e in pratica ne abbiamo forse un migliaio. Le leggi della fisica ci aiutano a compensare la mancanza di dati".

"L'approccio standard alla stima dei parametri consiste nell'assumere che i parametri possano assumere molte forme diverse, e poi per ogni forma devi risolvere le equazioni del flusso sotto la superficie forse milioni di volte per determinare i parametri che meglio si adattano alle osservazioni, " Ha aggiunto Tartakovsky. Ma per questo studio il team di ricerca ha adottato una strategia diversa:utilizzare un GAN informato dalla fisica e un calcolo ad alte prestazioni per stimare i parametri e quantificare l'incertezza nel flusso sotto la superficie.

Per questo primo lavoro di validazione, i ricercatori hanno scelto di utilizzare dati sintetici, dati generati da un modello calcolato basato su conoscenze specialistiche sul sito di Hanford. Ciò ha permesso loro di creare una rappresentazione virtuale del sito che potevano quindi manipolare secondo necessità in base ai parametri che erano interessati a misurare, principalmente conducibilità idraulica e carico idraulico, entrambi fondamentali per modellare la posizione dei contaminanti. Gli studi futuri includeranno i dati dei sensori reali e le condizioni del mondo reale.

"Lo scopo iniziale di questo progetto era quello di stimare l'accuratezza dei metodi, quindi abbiamo usato dati sintetici invece di misurazioni reali, " Ha detto Tartakovsky. "Questo ci ha permesso di stimare le prestazioni del GANS informato dalla fisica in funzione del numero di misurazioni".

Nell'addestrare il GAN sul supercomputer Summit presso l'Oak Ridge Leadership Computing Facility OLCF, il team è stato in grado di raggiungere un picco di 1.2 exaflop e prestazioni sostenute, il primo esempio di un'architettura GAN su larga scala applicata agli SPDE. L'estensione geografica, eterogeneità spaziale, e più scale di lunghezza di correlazione del sito di Hanford hanno richiesto l'addestramento del modello GAN a migliaia di dimensioni, quindi il team ha sviluppato un'implementazione altamente ottimizzata che è stata scalata a 27, 504 GPU Tensor Core NVIDIA V100 e 4, 584 nodi su Summit con un'efficienza di ridimensionamento del 93,1%.

"Il raggiungimento di una scala e prestazioni così massicce ha richiesto l'ottimizzazione dell'intero stack e strategie multiple per estrarre il massimo parallelismo, " ha detto Mike Houston, che guida il team AI Systems di NVIDIA. "A livello di chip, abbiamo ottimizzato la struttura e il design della rete neurale per massimizzare l'utilizzo di Tensor Core tramite il supporto cuDNN in TensorFlow. A livello di nodo, abbiamo usato NCCL e NVLink per lo scambio di dati ad alta velocità. E a livello di sistema, abbiamo ottimizzato Horovod e MPI non solo per combinare dati e modelli, ma anche per gestire strategie parallele avversarie. Per massimizzare l'utilizzo delle nostre GPU, abbiamo dovuto suddividere i dati e poi distribuirli per allinearli con la tecnica di parallelizzazione."

"Questo è un nuovo record per le architetture GAN, " ha detto Prabhat. "Volevamo creare un surrogato economico per una simulazione molto costosa, e ciò che siamo stati in grado di mostrare qui è che un'architettura GAN vincolata dalla fisica può produrre campi spaziali coerenti con la nostra conoscenza della fisica. Inoltre, questo progetto esemplare ha riunito esperti di modellazione del sottosuolo, matematica applicata, apprendimento profondo, e HPC. Poiché il DOE prende in considerazione applicazioni più ampie del deep learning e, in particolare, GAN—a problemi di simulazione, Mi aspetto che più team di ricerca si ispirino a questi risultati".

La carta, "Altamente scalabile, GAN informati sulla fisica per soluzioni di apprendimento di PDE stocastiche, " sarà presentato al workshop SC19 Deep Learning on Supercomputers. I