Da sinistra:il dottor John H.L. Hansen, Chengzhu Yu PhD'17, Il dottor Abhijeet Sangwan e Lakshmish Kaushik posano con un modello di un astronauta al Johnson Space Center della NASA a Houston. I quattro hanno supervisionato il progetto per sviluppare tecniche di elaborazione del parlato per ricostruire e trasformare migliaia di ore di audio dalle missioni lunari della NASA. Credito:Università del Texas a Dallas

La NASA ha registrato migliaia di ore di audio dalle missioni lunari Apollo, eppure la maggior parte di noi è stata in grado di ascoltare solo i momenti salienti.

L'agenzia ha registrato tutte le comunicazioni tra gli astronauti, specialisti del controllo missione e personale di supporto durante le storiche missioni lunari oltre alle famose citazioni di Neil Armstrong dall'Apollo 11 nel luglio 1969.

La maggior parte dell'audio è rimasta archiviata su nastri analogici obsoleti per decenni fino a quando i ricercatori dell'Università del Texas a Dallas hanno lanciato un progetto per analizzare l'audio e renderlo accessibile al pubblico.

I ricercatori del Center for Robust Speech Systems (CRSS) della Erik Jonsson School of Engineering and Computer Science (ECS) hanno ricevuto una sovvenzione dalla National Science Foundation nel 2012 per sviluppare tecniche di elaborazione del parlato per ricostruire e trasformare l'enorme archivio di audio in Explore Apollo , un sito web che fornisce l'accesso pubblico ai materiali. Il progetto, in collaborazione con l'Università del Maryland, includeva l'audio di tutto l'Apollo 11 e della maggior parte dell'Apollo 13, Missioni Apollo 1 e Gemini 8.

Un gigantesco salto tecnologico

Trascrivere e ricostruire l'enorme archivio audio richiederebbe un passo da gigante nell'elaborazione del parlato e nella tecnologia del linguaggio. Ad esempio, le comunicazioni sono state catturate su più di 200 nastri analogici di 14 ore, ciascuno con 30 tracce audio. La soluzione dovrebbe decifrare la comunicazione con un discorso confuso, interferenze tecniche e loop audio sovrapposti. Immagina Siri di Apple che cerca di trascrivere discussioni tra interruzioni casuali e fino a 35 persone in luoghi diversi, spesso parlando con accenti regionali del Texas.

Il progetto, guidato dal fondatore e direttore del CRSS Dr. John H.L. Hansenand ricercatore scientifico Dr. Abhijeet Sangwan, incluso un team di studenti di dottorato che ha lavorato per stabilire soluzioni per digitalizzare e organizzare l'audio. Hanno anche sviluppato algoritmi per elaborare, riconoscere e analizzare l'audio per determinare chi ha detto cosa e quando. Gli algoritmi sono descritti nel numero di novembre di Transazioni IEEE/ACM su audio, Discorso, ed elaborazione del linguaggio .

Sette team di progettazione senior universitari supervisionati dal CRSS hanno contribuito a creare Explore Apollo per rendere le informazioni accessibili al pubblico. Il progetto ha anche ricevuto assistenza dal Centro di formazione scientifica e ingegneristica dell'Università (SEEC), che ha valutato il sito Explore Apollo.

Cinque anni dopo, la squadra sta completando il suo lavoro, che ha portato a progressi nella tecnologia per convertire la voce in testo, analizzare i relatori e capire come le persone hanno collaborato per realizzare le missioni.

"CRSS ha compiuto progressi significativi nell'apprendimento automatico e nell'estrazione della conoscenza per valutare l'interazione umana per uno dei compiti ingegneristici più impegnativi nella storia dell'umanità, " ha detto Hansen, decano associato per la ricerca in ECS, professore di ingegneria elettrica e informatica, professore presso la Scuola di Scienze Comportamentali e del Cervello, e illustre cattedra nelle telecomunicazioni. Raffinazione di apparecchiature retrò

Quando hanno iniziato il loro lavoro, i ricercatori hanno scoperto che la prima cosa che dovevano fare era digitalizzare l'audio. Il trasferimento dell'audio in un formato digitale si è rivelato di per sé un'impresa ingegneristica. L'unico modo per riprodurre i rulli era su un pezzo di equipaggiamento degli anni '60 al Johnson Space Center della NASA a Houston chiamato SoundScriber.

"La NASA ci ha indicato SoundScriber e ci ha detto di fare quello che devi fare, "Ha detto Hansen.

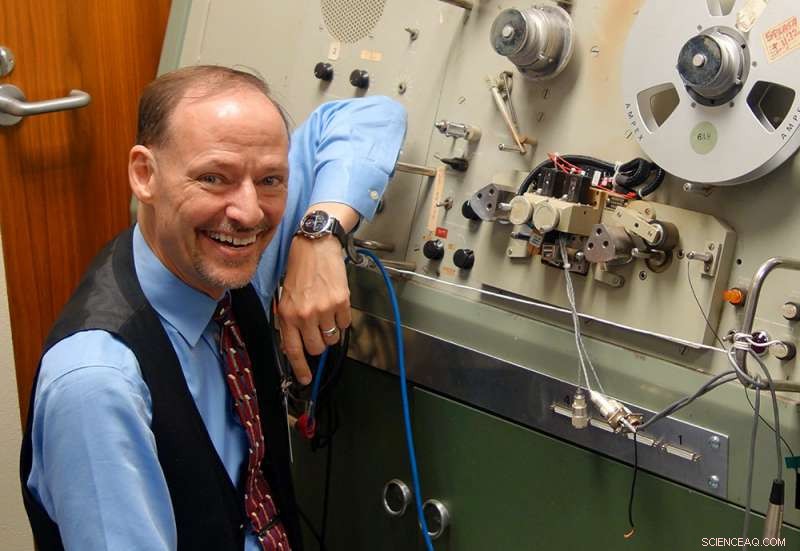

Il Dr. John H.L. Hansen è in piedi accanto a SoundScriber, l'unico dispositivo in grado di riprodurre le registrazioni analogiche di migliaia di ore di comunicazioni durante le missioni lunari della NASA. Credito:Università del Texas a Dallas

Il dispositivo potrebbe leggere solo una traccia alla volta. L'utente doveva ruotare meccanicamente una maniglia per spostare la testina di lettura del nastro da una traccia all'altra. Secondo la stima di Hansen, ci vorrebbero almeno 170 anni per digitalizzare solo l'audio della missione Apollo 11 utilizzando la tecnologia.

"Non potevamo usare quel sistema, quindi abbiamo dovuto progettarne uno nuovo, "Ha detto Hansen. "Abbiamo progettato la nostra testina di lettura a 30 tracce, e ha creato una soluzione parallela per acquisire tutte e 30 le tracce contemporaneamente. Questa è l'unica soluzione che esiste sul pianeta".

La nuova testina di lettura ha ridotto il processo di digitalizzazione da anni a mesi. Quel compito divenne il lavoro di Tuan Nguyen, un anziano di ingegneria biomedica che ha trascorso un semestre a lavorare a Houston.

Voci amplificate degli eroi dietro gli eroi

Una volta trasferito l'audio dalle bobine ai file digitali, i ricercatori avevano bisogno di creare un software in grado di rilevare l'attività vocale, incluso il monitoraggio di ogni persona che parla e cosa ha detto e quando, un processo chiamato diarizzazione. Avevano anche bisogno di tenere traccia delle caratteristiche dei parlanti per aiutare i ricercatori ad analizzare come le persone reagiscono in situazioni di tensione. Inoltre, i nastri includevano audio da vari canali che dovevano essere collocati in ordine cronologico.

I ricercatori che hanno lavorato al progetto hanno affermato che una delle parti più impegnative è stata capire come funzionavano le cose alla NASA durante le missioni in modo che potessero capire come ricostruire l'enorme quantità di audio.

"Questo non è qualcosa che puoi imparare in una classe, " ha detto Chengzhu Yu PhD'17. Yu ha iniziato il suo programma di dottorato all'inizio del progetto e si è laureato la scorsa primavera. Ora, lavora come ricercatore concentrandosi sulla tecnologia di riconoscimento vocale presso il centro di ricerca sull'intelligenza artificiale di Tencent a Seattle.

Lakshmish Kaushik, un dottorando che ha lasciato un precedente lavoro per lavorare al progetto, mira inoltre a dedicare la sua carriera alla tecnologia di riconoscimento vocale. Il suo ruolo era quello di sviluppare algoritmi che distinguessero l'array di voci su più canali.

"Gli ultimi quattro anni sono stati davvero esaltanti, "Ha detto Kaushik.

Il team ha dimostrato il sito Web interattivo presso il Perot Museum of Nature and Science di Dallas. Per Hansen, il progetto è stato un'occasione per mettere in luce il lavoro delle tante persone coinvolte nelle missioni lunari oltre agli astronauti.

"Quando si pensa ad Apollo, gravitiamo sugli enormi contributi degli astronauti che chiaramente meritano la nostra lode e ammirazione.

Però, gli eroi dietro gli eroi rappresentano gli innumerevoli ingegneri, scienziati e specialisti che hanno unito collettivamente la loro esperienza basata sulle discipline STEM per garantire il successo del programma Apollo, " ha detto Hansen. "Speriamo che gli studenti di oggi continuino a impegnare la loro esperienza nei campi STEM per affrontare le sfide di domani".