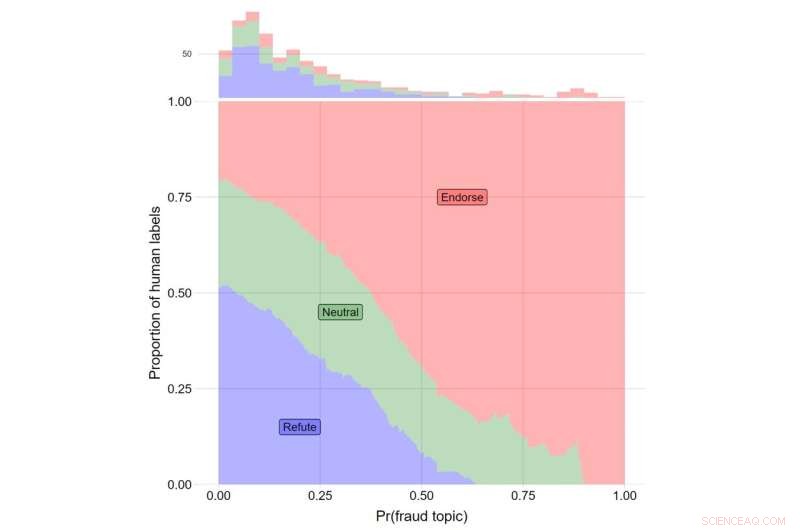

L'asse y indica la quota di etichette umane per i video che confutano le affermazioni di Trump (in blu), quelli che riportano le affermazioni di Trump in modo neutrale (verde) e quelli che avallano le affermazioni di Trump (rosso). L'asse x indica il valore θ per l'argomento #108. Il numero totale di video che rientrano in ciascuna categoria è indicato con l'istogramma nella parte superiore della trama. Credito:Journal of Online Trust and Safety (2022). https://doi.org/10.54501/jots.v1i3.60

YouTube era più propenso a consigliare video sulla frode elettorale agli utenti che erano già scettici sulla legittimità delle elezioni presidenziali statunitensi del 2020, mostra un nuovo studio che esamina l'impatto degli algoritmi del sito.

I risultati della ricerca, che sono pubblicati nel Journal of Online Trust and Safety , ha mostrato che i più scettici sulla legittimità delle elezioni sono stati mostrati tre volte più video relativi alle frodi elettorali rispetto ai partecipanti meno scettici, circa 8 consigli aggiuntivi su circa 400 video suggeriti a ciascun partecipante allo studio.

Sebbene la prevalenza complessiva di questi tipi di video fosse bassa, i risultati espongono le conseguenze di un sistema di raccomandazioni che fornisce agli utenti i contenuti desiderati. Per coloro che sono più preoccupati per possibili frodi elettorali, mostrare loro contenuti correlati ha fornito un meccanismo attraverso il quale disinformazione, disinformazione e cospirazioni possono trovare la loro strada verso coloro che hanno maggiori probabilità di crederci, osservano gli autori dello studio. È importante sottolineare che questi modelli riflettono l'influenza indipendente dell'algoritmo su ciò che viene mostrato agli utenti reali durante l'utilizzo della piattaforma.

"I nostri risultati scoprono le conseguenze dannose degli algoritmi di raccomandazione e mettono in dubbio l'opinione che gli ambienti informativi online siano determinati esclusivamente dalla scelta dell'utente", afferma James Bisbee, che ha condotto lo studio come ricercatore post-dottorato presso il Center for Social Media and Politics della New York University (CSMaP).

Quasi due anni dopo le elezioni presidenziali del 2020, un gran numero di americani, in particolare repubblicani, non crede nella legittimità del risultato.

"Circa il 70% dei repubblicani non vede Biden come il legittimo vincitore", nonostante "più riconteggi e audit che hanno confermato la vittoria di Joe Biden", ha scritto il PolitiFact del Poynter Institute all'inizio di quest'anno.

Sebbene sia noto che le piattaforme di social media, come YouTube, dirigono i contenuti agli utenti in base alle loro preferenze di ricerca, le conseguenze di questa dinamica potrebbero non essere pienamente realizzate.

Nello studio CSMaP, i ricercatori hanno campionato più di 300 americani con account YouTube a novembre e dicembre del 2020. Ai soggetti è stato chiesto quanto fossero preoccupati per una serie di aspetti della frode elettorale, tra cui il conteggio di schede fraudolente, lo scarto di schede valide, governi stranieri che interferiscono e cittadini non statunitensi che votano, tra le altre domande.

A questi partecipanti è stato quindi chiesto di installare un'estensione del browser che registrasse l'elenco dei consigli che erano stati mostrati. Ai soggetti è stato quindi chiesto di fare clic su un video YouTube assegnato in modo casuale (il video "seme"), quindi di fare clic su uno dei consigli che sono stati mostrati secondo una "regola di attraversamento" assegnata in modo casuale. Ad esempio, gli utenti assegnati alla "seconda regola di attraversamento" dovrebbero fare clic sempre sul secondo video nell'elenco di consigli mostrato, indipendentemente dal suo contenuto. By restricting user behavior in these ways, the researchers were able to isolate the recommendation algorithm's influence on what real users were being suggested in real time.

The subjects then proceeded through a sequence of YouTube recommended videos, allowing the researchers to observe what the YouTube algorithm suggested to its users. Bisbee and his colleagues then compared the number of videos about election fraud in the 2020 U.S. presidential election that were recommended to participants who were more skeptical about the legitimacy of the election to those recommended to participants who were less skeptical. These results showed that election skeptics were recommended an average of eight additional videos about possible fraud in the 2020 US election, relative to non-skeptical participants (12 vs. 4).

"Many believe that automated recommendation algorithms have little influence on online 'echo chambers' in which users only see content that reaffirms their preexisting views," observes Bisbee, now an assistant professor at Vanderbilt University.

"Our study, however, suggests that YouTube's recommendation algorithm was able to determine which users were more likely to be concerned about fraud in the 2020 U.S. presidential election and then suggested up to three times as many videos about election fraud to these users compared to those less concerned about election fraud. This highlights the need for further investigation into how opaque recommendation algorithms operate on an issue-by-issue basis." + Esplora ulteriormente