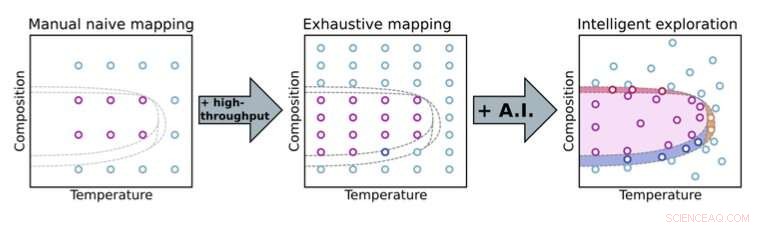

Il passaggio da un approccio di sperimentazione manuale a quello automatizzato consente agli scienziati di esplorare più a fondo gli spazi dei parametri. Con i metodi decisionali dell'intelligenza artificiale (AI), gli scienziati possono concentrarsi su parti chiave dello spazio dei parametri (qui, composizione e temperatura) per la scoperta accelerata di materiale. Credito:Brookhaven National Laboratory

Nella visione popolare della scienza tradizionale, gli scienziati sono in laboratorio in bilico sui loro esperimenti, microgestendo ogni minimo dettaglio. Per esempio, possono testare in modo iterativo un'ampia varietà di composizioni di materiali, sintesi e protocolli di elaborazione, e condizioni ambientali per vedere come questi parametri influenzano le proprietà dei materiali. Ad ogni iterazione, analizzano i dati raccolti, cercando modelli e facendo affidamento sulla loro conoscenza scientifica e intuizione per selezionare utili misurazioni successive.

Questo approccio manuale richiede un tempo strumentale limitato e l'attenzione di esperti umani che potrebbero altrimenti concentrarsi sul quadro più ampio. Anche gli esperimenti manuali possono essere inefficienti, soprattutto quando c'è un ampio set di parametri da esplorare, e sono soggetti a pregiudizi umani, ad esempio, nel decidere quando si sono raccolti dati sufficienti e si può interrompere un esperimento. Il modo convenzionale di fare scienza non può essere scalato per gestire l'enorme complessità delle future sfide scientifiche. I progressi negli strumenti scientifici e nelle capacità di analisi dei dati presso le strutture sperimentali continuano a consentire misurazioni più rapide. Sebbene questi progressi possano aiutare gli scienziati ad affrontare complessi problemi sperimentali, aggravano anche il collo di bottiglia umano; nessun essere umano può tenere il passo con i moderni strumenti sperimentali!

Immaginare l'automazione

Una di queste strutture che gestisce questi tipi di sfide è la National Synchrotron Light Source II (NSLS-II) presso il Brookhaven National Laboratory del Dipartimento dell'Energia degli Stati Uniti (DOE). Dirigendo i raggi luminosi, che vanno dagli infrarossi ai raggi X duri, verso i campioni nelle stazioni sperimentali (linee di luce), NSLS-II può rivelare l'elettronica, chimico, e strutture atomiche dei materiali. Quando gli scienziati stavano progettando queste linee di luce un decennio fa, hanno avuto la lungimiranza di incorporare l'automazione abilitata dall'apprendimento automatico (ML) e dall'intelligenza artificiale (AI), ora un campo in espansione, come parte della loro visione.

"Abbiamo pensato, non sarebbe fantastico se gli scienziati potessero non solo eseguire misurazioni più velocemente, ma anche eseguire esplorazioni intelligenti, ovvero esplorare i problemi scientifici in modo più intelligente, modi più efficienti sfruttando i moderni metodi dell'informatica, "ha detto Kevin Yager, leader dell'Electronic Nanomaterials Group del Center for Functional Nanomaterials (CFN) presso Brookhaven Lab. "Infatti, al CFN, abbiamo definito uno dei nostri temi di ricerca come scoperta accelerata di nanomateriali".

Questa idea per una linea di luce altamente automatizzata che potrebbe esplorare in modo intelligente i problemi scientifici ha finito per diventare un obiettivo a lungo termine della linea di luce Complex Materials Scattering (CMS), sviluppato e gestito da un team guidato da Masafumi Fukuto.

"Abbiamo iniziato costruendo capacità ad alto rendimento per misurazioni veloci, come un robot per lo scambio di campioni e molti strumenti in situ per esplorare diversi parametri come la temperatura, pressione del vapore, e umidità, " disse Fukuto. "Allo stesso tempo, abbiamo iniziato a pensare di automatizzare non solo l'hardware della linea di luce per la raccolta dei dati, ma anche l'analisi dei dati in tempo reale e il processo decisionale sperimentale. La capacità di effettuare misurazioni molto rapidamente è utile e necessaria, ma non sufficiente per la scoperta di materiali rivoluzionari perché gli spazi dei parametri dei materiali sono molto ampi e multidimensionali".

Per esempio, un esperimento può avere uno spazio dei parametri con cinque dimensioni e più di 25, 000 punti distinti all'interno di quello spazio da esplorare. Sia il software di acquisizione e analisi dei dati per affrontare questi grandi, spazi di parametri ad alta dimensionalità sono stati costruiti in casa a Brookhaven. Per la raccolta dei dati, hanno costruito sul software Bluesky, che NSLS-II ha sviluppato. Per analizzare i dati, Yager ha scritto il codice per un software di analisi delle immagini chiamato SciAnalysis.

Chiusura del ciclo

Nel 2017, Fukuto e Yager hanno iniziato a collaborare con Marcus Noack, poi un postdoc e ora un ricercatore nel Center for Advanced Mathematics for Energy Research Applications (CAMERA) presso il Lawrence Berkeley National Laboratory del DOE. Durante il suo periodo come postdoc, Noack è stato incaricato di collaborare con il team di Brookhaven al loro concetto di linea di luce autonoma. Nello specifico, hanno lavorato insieme per sviluppare l'ultimo pezzo per creare una configurazione sperimentale completamente automatizzata:un algoritmo decisionale. Il team di Brookhaven ha definito le proprie esigenze, mentre Noack ha fornito la sua esperienza in matematica applicata e ha scritto il software per soddisfare queste esigenze.

Sfruttando l'intelligenza artificiale e il machine learning, questo algoritmo determina le migliori misurazioni successive da effettuare mentre un esperimento è in corso. (AI si riferisce a una macchina che simula il comportamento umano, mentre ML è un sottocampo dell'IA in cui una macchina apprende automaticamente dai dati passati.) Affinché l'algoritmo inizi a modellare un sistema, è semplice come un utente che definisce gli input e gli output:quali sono le variabili che posso controllare nell'esperimento, e cosa misuro? Ma più informazioni gli umani forniscono in anticipo, come la risposta attesa del sistema o i vincoli noti basati sul particolare problema studiato, più robusta sarà la modellazione. Dietro le quinte, un processo gaussiano è all'opera per modellare il comportamento del sistema.

"Un processo gaussiano è un modo matematicamente rigoroso per stimare l'incertezza, " ha spiegato Yager. "Questo è un altro modo di dire conoscenza nella mia mente. E questo è un altro modo di dire scienza. Perché nella scienza, questo è ciò che ci interessa di più:cosa so, e quanto bene lo so?"

"Questa è la parte ML di esso, " ha aggiunto Fukuto. "L'algoritmo va un passo oltre. Prende automaticamente decisioni in base a questa conoscenza e agli input umani per selezionare quale punto avrebbe senso misurare successivamente".

In un caso semplicistico, questa misurazione successiva sarebbe la posizione nello spazio dei parametri in cui il guadagno di informazioni può essere massimizzato (o ridotto l'incertezza). Il team ha dimostrato per la prima volta questa prova di concetto nel 2019 alla linea di luce NSLS-II CMS, l'imaging di un film di nanomateriali realizzato appositamente per questa dimostrazione.

Da questo primo successo, il team ha reso l'algoritmo più sofisticato, applicandolo per studiare una vasta gamma di problemi scientifici reali (invece che inventati) da vari gruppi, ed estendendolo a tecniche e strutture più sperimentali.

Mentre la versione predefinita dell'algoritmo mira a ridurre al minimo l'incertezza o massimizzare il guadagno di conoscenza in modo iterativo, ci sono altri modi di pensare su dove focalizzare l'attenzione sperimentale per ottenere il massimo valore. Per esempio, per alcuni scienziati, il costo dell'esperimento, che si tratti della sua durata o della quantità di materiali utilizzati, è importante. In altre parole, non è solo dove prendi i dati ma come caro è prendere quei dati. Altri possono trovare valore nell'indirizzare su caratteristiche specifiche, come i confini all'interno di uno spazio parametrico o la dimensione dei grani di un cristallo. Il più sofisticato, La versione flessibile dell'algoritmo sviluppato da Noack può essere programmata per avere una maggiore sensibilità a queste caratteristiche.

"Puoi mettere a punto quali sono i tuoi obiettivi nell'esperimento, " ha spiegato Yager. "Quindi, può essere un guadagno di conoscenza, o guadagno di conoscenza regolato da costi sperimentali o associato a caratteristiche specifiche."

Altri miglioramenti includono la capacità dell'algoritmo di gestire la complessità dei sistemi reali, come il fatto che i materiali siano disomogenei, il che significa che non sono gli stessi in ogni punto di un campione. Una parte di un campione può avere una composizione uniforme, mentre un altro può avere una composizione variabile. Inoltre, l'algoritmo ora tiene conto dell'anisotropia, o come i singoli parametri possono essere molto diversi l'uno dall'altro in termini di come influenzano un sistema. Per esempio, "x" e "y" sono parametri equivalenti (sono entrambe coordinate posizionali) ma la temperatura e la pressione non lo sono.

"I processi gaussiani usano i kernel, funzioni che descrivono come i punti dati dipendono l'uno dall'altro nello spazio, per l'interpolazione, " ha detto Noack. "I kernel hanno tutti i tipi di interessanti proprietà matematiche. Ad esempio, possono codificare vari gradi di disomogeneità per un campione."

Aumentare la sofisticatezza dell'algoritmo è solo una parte della sfida. Quindi, Fukuto e Yager devono integrare l'algoritmo aggiornato nel flusso di lavoro sperimentale automatizzato a ciclo chiuso e testarlo su diversi esperimenti, non solo quelli eseguiti internamente, ma anche quelli eseguiti dagli utenti.

Distribuire il metodo alla più ampia comunità scientifica

Recentemente, Fukuto, Yager, noac, e colleghi hanno implementato il metodo autonomo in diversi esperimenti reali su varie linee di luce NSLS-II, inclusi CMS e interfacce soft-matter (SMI). Noack e collaboratori hanno anche implementato il metodo presso l'Advanced Light Source (ALS) di LBNL e l'Institut Laue-Langevin (ILL), un impianto di diffusione di neutroni in Francia. Il team ha rilasciato il proprio software decisionale, gpCAM, alla più ampia comunità scientifica in modo che chiunque possa organizzare i propri esperimenti autonomi.

In un esperimento, in collaborazione con l'U.S. Air Force Research Laboratory (AFRL), hanno usato il metodo in un esperimento di diffusione di raggi X di sincrotrone autonomo presso la linea di luce del CMS. Nella diffusione dei raggi X, i raggi X rimbalzano su un campione in direzioni diverse a seconda della struttura del campione. Il primo obiettivo dell'esperimento era esplorare come la struttura ordinata dei film compositi nanorod-polimero dipende da due parametri di fabbricazione:la velocità del rivestimento del film e il rivestimento chimico del substrato. Il secondo obiettivo era usare questa conoscenza per localizzare e localizzare le regioni dei film con i più alti gradi di ordine.

"Questi materiali sono di interesse per i rivestimenti ottici e i sensori, " ha spiegato Ruipeng Li, scienziato di CMS beamline. "Abbiamo utilizzato un particolare metodo di fabbricazione che imita i processi industriali roll-to-roll per scoprire il modo migliore per formare questi film ordinati utilizzando processi scalabili industrialmente".

In un altro esperimento di diffusione dei raggi X, alla linea di luce SMI, l'algoritmo ha identificato con successo regioni di ordinamento inaspettato in uno spazio dei parametri relativo all'autoassemblaggio di film di copolimero a blocchi. I copolimeri a blocchi sono polimeri costituiti da due o più "blocchi" chimicamente distinti collegati tra loro. Identificando queste caratteristiche, l'esperimento autonomo ha messo in luce un problema con il metodo di fabbricazione.

"Non era ipotetico:abbiamo lavorato a questo progetto per molti anni, ", ha detto lo scienziato dei materiali CFN Gregory Doerk. "Avevamo iterato alla vecchia maniera, facendo degli esperimenti, scattare immagini in luoghi che abbiamo scelto arbitrariamente, guardando le immagini, ed essere perplesso su cosa sta succedendo. Con l'approccio autonomo, in un giorno di esperimenti alla linea di luce, siamo riusciti a trovare i difetti e poi a correggerli subito nel giro successivo. È una drammatica accelerazione del normale ciclo di ricerca in cui si fa uno studio, scoprire che non ha funzionato, e torna al tavolo da disegno."

Noack e i suoi collaboratori hanno anche applicato il metodo a un diverso tipo di tecnica a raggi X chiamata mappatura dell'infrarosso di sincrotrone autonomo, che può fornire informazioni chimiche su un campione. E hanno dimostrato come il metodo potrebbe essere applicato a una tecnica di spettroscopia per scoprire autonomamente fasi in cui gli elettroni si comportano in modo fortemente correlato e allo scattering di neutroni per misurare autonomamente le correlazioni magnetiche.

Plasmare il futuro della sperimentazione autonoma

Secondo Yager, il loro metodo può essere applicato a qualsiasi tecnica per la quale la raccolta e l'analisi dei dati siano già automatizzate. Uno dei vantaggi dell'approccio è che è "agnostico dalla fisica, " nel senso che non è legato a nessun tipo particolare di materiale, problema fisico, o tecnica. Le quantità fisicamente significative per il processo decisionale vengono estratte attraverso l'analisi dei dati grezzi.

"Volevamo rendere il nostro approccio molto generale in modo che potesse essere applicato a qualsiasi cosa e poi lungo la strada adattato a problemi specifici, " ha detto Yager. "Come struttura utente, vogliamo consentire al maggior numero di persone di fare scienza interessante".

Nel futuro, il team aggiungerà funzionalità per consentire agli utenti di incorporare la consapevolezza della fisica, o la conoscenza dei materiali o dei fenomeni che stanno studiando, se lo desiderano. Ma il team lo farà in un modo che non distrugga la flessibilità generale dell'approccio; gli utenti potranno attivare o disattivare questa conoscenza aggiuntiva.

Un altro aspetto del lavoro futuro è l'applicazione del metodo per controllare i processi in tempo reale, in altre parole, controllare un sistema che si evolve dinamicamente nel tempo man mano che l'esperimento procede.

"Fino a questo punto, ci siamo concentrati sul prendere decisioni su come misurare o caratterizzare i sistemi di materiali preparati, " ha detto Fukuto. "Vogliamo anche prendere decisioni su come cambiare i materiali o che tipo di materiali vogliamo fare. Comprendere la scienza fondamentale alla base dei cambiamenti materiali è importante per migliorare i processi di produzione".

Realizzare questa capacità di esplorare in modo intelligente i materiali che si evolvono in tempo reale richiederà il superamento di sfide algoritmiche e strumentali.

"Il processo decisionale deve essere molto veloce, e devi costruire ambienti campione per fare la sintesi dei materiali in tempo reale mentre stai effettuando misurazioni con un raggio di raggi X, " ha spiegato Yager.

Nonostante queste sfide, il team è entusiasta di ciò che riserva il futuro della sperimentazione autonoma.

"Abbiamo iniziato questo sforzo su una scala molto piccola, ma è cresciuto in qualcosa di molto più grande, " disse Fukuto. "Molte persone sono interessate a questo, non solo noi. La comunità degli utenti si è ampliata, e con gli utenti che studiano diversi tipi di problemi, questo approccio potrebbe avere un grande impatto sull'accelerazione di una serie di scoperte scientifiche".

"Rappresenta davvero un grande cambiamento nel modo di pensare passare dal vecchio modo di gestire gli esperimenti a questa nuova visione di sistemi automatizzati che eseguono esperimenti con esseri umani che li orchestrano ad un livello molto alto perché capiscono cosa deve essere fatto e cosa significa la scienza, " ha detto Yager. "Questa è una visione molto eccitante per il futuro della scienza. Saremo in grado di affrontare problemi in futuro che 10 anni fa la gente avrebbe detto impossibili".