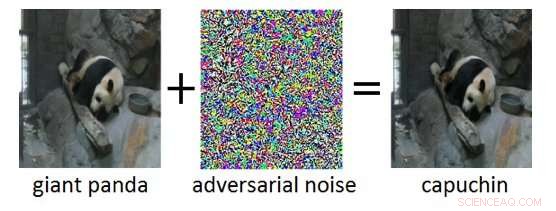

Figura 1:Esempio contraddittorio (a destra) ottenuto aggiungendo rumore contraddittorio (al centro) a un'immagine di input pulita (a sinistra). Mentre il rumore aggiunto nell'esempio contraddittorio è impercettibile per un essere umano, porta la Deep Neural Network a classificare erroneamente l'immagine come "cappuccino" invece di "panda gigante". Credito:IBM Blog Research

Gli ultimi anni hanno visto enormi progressi nello sviluppo dell'intelligenza artificiale (AI). I moderni sistemi di intelligenza artificiale raggiungono prestazioni a livello umano su compiti cognitivi come il riconoscimento di oggetti nelle immagini, video di annotazione, convertire la voce in testo, o tradurre tra lingue diverse. Molti di questi risultati rivoluzionari si basano su reti neurali profonde (DNN). I DNN sono modelli complessi di apprendimento automatico che presentano alcune somiglianze con i neuroni interconnessi nel cervello umano. I DNN sono in grado di gestire input ad alta dimensionalità (ad esempio milioni di pixel in immagini ad alta risoluzione), rappresentare modelli in quegli input a vari livelli di astrazione, e mettere in relazione tali rappresentazioni con concetti semantici di alto livello.

Una proprietà intrigante dei DNN è che, mentre sono normalmente molto accurati, sono vulnerabili ai cosiddetti esempi contraddittori. Esempi contraddittori sono input (diciamo, immagini) che sono stati deliberatamente modificati per produrre una risposta desiderata da un DNN. Un esempio è mostrato nella Figura 1:qui l'aggiunta di una piccola quantità di rumore contraddittorio all'immagine di un panda gigante porta il DNN a classificare erroneamente questa immagine come un cappuccino. Spesso, l'obiettivo degli esempi contraddittori è una classificazione errata o una previsione errata specifica che andrebbe a beneficio di un aggressore.

Gli attacchi contraddittori rappresentano una minaccia reale per l'implementazione di sistemi di intelligenza artificiale nelle applicazioni critiche per la sicurezza. Alterazioni delle immagini praticamente impercettibili, video, discorso, e altri dati sono stati creati per confondere i sistemi di intelligenza artificiale. Tali alterazioni possono essere realizzate anche se l'attaccante non ha una conoscenza esatta dell'architettura del DNN o non ha accesso ai suoi parametri. Ancora più preoccupante, gli attacchi avversari possono essere lanciati nel mondo fisico:invece di manipolare i pixel di un'immagine digitale, gli avversari potrebbero eludere i sistemi di riconoscimento facciale indossando occhiali appositamente progettati, o sconfiggere i sistemi di riconoscimento visivo nei veicoli autonomi applicando toppe ai segnali stradali.

IBM Research Ireland sta rilasciando l'Adversarial Robustness Toolbox, una libreria software open source, per supportare sia i ricercatori che gli sviluppatori nella difesa dei DNN dagli attacchi avversari e quindi rendere più sicuri i sistemi di intelligenza artificiale. Il rilascio sarà annunciato alla conferenza RSA dal Dr. Sridhar Muppidi, Fellow IBM, VP e CTO IBM Security, e Koos Lodewijkx, Vicepresidente e CTO di Security Operations and Response (SOAR), IBM Sicurezza.

L'Adversarial Robustness Toolbox è progettato per supportare ricercatori e sviluppatori nella creazione di nuove tecniche di difesa, così come nell'implementazione di difese pratiche dei sistemi di intelligenza artificiale del mondo reale. I ricercatori possono utilizzare l'Adversarial Robustness Toolbox per confrontare nuove difese rispetto allo stato dell'arte. Per gli sviluppatori, la libreria fornisce interfacce che supportano la composizione di sistemi di difesa completi utilizzando metodi individuali come elementi costitutivi.

La libreria è scritta in Python, il linguaggio di programmazione più comunemente usato per lo sviluppo, testare e distribuire DNN. Comprende algoritmi all'avanguardia per la creazione di esempi contraddittori e metodi per difendere i DNN da questi. L'approccio per difendere i DNN è triplice:

Per iniziare con l'Adversarial Robustness Toolbox, controlla la versione open source su github.com/IBM/adversarial-robustness-toolbox . La versione include un'ampia documentazione e tutorial per aiutare ricercatori e sviluppatori a iniziare rapidamente. È in preparazione un white paper che illustra i dettagli dei metodi implementati nella biblioteca.

Questa prima versione di Adversarial Robustness Toolbox supporta i DNN implementati nei framework di deep learning TensorFlow e Keras. Le versioni future estenderanno il supporto ad altri framework popolari come PyTorch o MXNet. Attualmente, la biblioteca è principalmente destinata a migliorare la robustezza contraddittoria dei sistemi di riconoscimento visivo, però, stiamo lavorando su versioni future che comprenderanno adattamenti ad altre modalità dati come voce, testo o serie temporali.

Come progetto open source, l'ambizione di Adversarial Robustness Toolbox è quella di creare un vivace ecosistema di collaboratori sia dall'industria che dal mondo accademico. La principale differenza rispetto a simili sforzi in corso è l'attenzione ai metodi di difesa, e sulla componibilità dei sistemi pratici di difesa. Ci auguriamo che il progetto Adversarial Robustness Toolbox stimolerà la ricerca e lo sviluppo sulla robustezza contraddittoria dei DNN, e far progredire l'implementazione dell'IA sicura nelle applicazioni del mondo reale. Condividi con noi la tua esperienza di lavoro con Adversarial Robustness Toolbox e qualsiasi suggerimento per miglioramenti futuri.