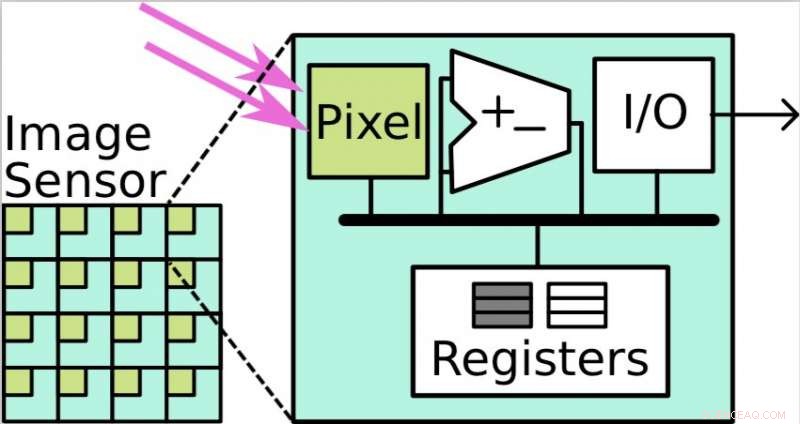

Gli array di sensori e processori sul piano focale (FPSP) sono sistemi di elaborazione paralleli, dove ogni pixel ha un elemento di elaborazione. Credito:Saeedi et al.

Un folto gruppo di ricercatori dell'Imperial College di Londra, l'Università di Edimburgo, l'Università di Manchester, e la Stanford University hanno recentemente collaborato a un progetto che esplora l'applicazione di strumenti di localizzazione e mappatura in tempo reale per la robotica, veicoli autonomi, realtà virtuale (VR) e realtà aumentata (AR). La loro carta, pubblicato su arXiv e Atti dell'IEEE , delinea lo sviluppo di metodi per valutare algoritmi di localizzazione e mappatura simultanee (SLAM), così come una serie di altri strumenti interessanti.

"L'obiettivo del nostro lavoro era quello di portare ricercatori esperti di visione artificiale, comunità hardware e compilatori insieme per costruire sistemi futuri per la robotica, VR/AR, e l'Internet delle cose (IoT), " I ricercatori hanno detto a Tech Xplore in una e-mail. "Volevamo costruire sistemi di visione artificiale robusti in grado di percepire il mondo con un budget energetico molto basso ma con la precisione desiderata; siamo interessati alla percezione per metrica Joule."

I ricercatori coinvolti nel progetto hanno unito le loro capacità e competenze per assemblare algoritmi, architetture, utensili, e software necessari per fornire SLAM. I loro risultati potrebbero aiutare coloro che applicano SLAM in una varietà di campi per selezionare e configurare algoritmi e hardware in grado di raggiungere livelli ottimali di prestazioni, precisione, e consumo di energia.

"Un punto importante del progetto è l'idea di ricerca interdisciplinare:riunire esperti di diversi campi può consentire risultati che altrimenti non sarebbero possibili, " hanno detto i ricercatori.

Gli algoritmi SLAM sono metodi che possono costruire o aggiornare una mappa di un ambiente sconosciuto tenendo traccia della posizione di un particolare agente al suo interno. Questa tecnologia può avere applicazioni utili in numerosi campi, ad esempio nello sviluppo di veicoli autonomi, robotica, realtà virtuale, e AR.

Nel loro studio, i ricercatori hanno sviluppato e valutato diversi strumenti, compresi compilatori e sistemi software runtime, oltre ad architetture hardware e algoritmi di computer vision per SLAM. Ad esempio, hanno sviluppato strumenti di benchmarking che hanno permesso loro di selezionare un set di dati adeguato e utilizzarlo per valutare gli algoritmi SLAM.

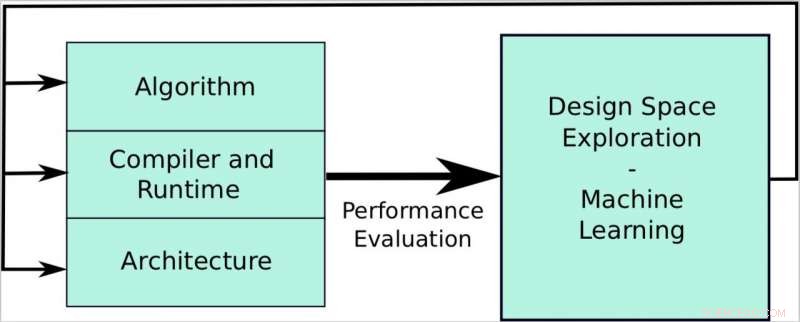

L'obiettivo del documento è creare una pipeline che allinei i requisiti di visione artificiale con le capacità hardware. Il lavoro si concentra su tre livelli:algoritmi, compilatore e runtime, e architettura. L'obiettivo è sviluppare un sistema che ci permetta di raggiungere potenza ed efficienza energetica, miglioramento della velocità e dell'autonomia, e precisione/robustezza a ogni livello e anche olisticamente attraverso l'esplorazione dello spazio di progettazione e le tecniche di apprendimento automatico. Credito:Saeedi et al.

Ad esempio, hanno utilizzato un'applicazione chiamata SLAMBench per valutare l'algoritmo KinectFusion su diverse piattaforme hardware e SLAMBench2 per confrontare diversi algoritmi SLAM. I ricercatori hanno anche esteso l'algoritmo KinectFusion, in modo che possa essere utilizzato nella pianificazione del percorso robotico e negli algoritmi di navigazione; mappare sia lo spazio occupato che quello libero nell'ambiente.

"Questo progetto era davvero ampio, così, i risultati sono stati piuttosto numerosi, " hanno detto i ricercatori. "Ad esempio, abbiamo mostrato applicazioni pratiche in cui il calcolo approssimativo può svolgere un ruolo importante nel raggiungimento della percezione per Joule, ad esempio l'applicazione SLAMBench sviluppata per smartphone. Il calcolo approssimativo è l'idea di completare un'attività di calcolo con un dato errore accettabile, e quindi produrre una soluzione approssimata."

Il progetto ha esplorato l'uso di nuove tecnologie di rilevamento, come array di processori-sensori sul piano focale, che hanno un basso consumo energetico e frame rate elevati. Inoltre, ha studiato l'applicazione della statica, dinamico, e approcci ibridi di programmazione del programma su sistemi multicore, in particolare per l'algoritmo KinectFusion.

"La nostra ricerca sta già avendo un impatto su molti campi come la robotica, VR/AR, e IoT, dove le macchine sono sempre attive e sono in grado di comunicare ed eseguire i propri compiti con ragionevole accuratezza, senza interruzioni, con un consumo energetico minimo, " hanno detto i ricercatori.

Questo progetto globale ha portato a diversi risultati importanti, e allo sviluppo di nuovi strumenti che potrebbero in gran parte facilitare l'implementazione di SLAM nella robotica, realtà virtuale, AR, e veicoli autonomi.

Lo studio ha anche fornito una serie di contributi nel contesto della progettazione hardware, ad esempio, sviluppo di strumenti di profilazione per individuare e valutare i colli di bottiglia delle prestazioni nelle applicazioni sia native che gestite. I ricercatori hanno presentato un flusso di lavoro completo per la creazione di hardware per applicazioni di visione artificiale, che potrebbe essere applicato a piattaforme future.

"Ora useremo i nostri risultati per costruire un sistema integrato per robotica e VR/AR, " hanno detto i ricercatori. "Per esempio, Il Dr. Luigi Nardi della Stanford University sta continuando la sua ricerca applicando concetti simili a Deep Neural Networks (DNN), ovvero l'ottimizzazione di hardware e software per eseguire DNN in modo efficiente, mentre il Dr. Sajad Saeedi dell'Imperial College di Londra sta esaminando tecnologie analogiche alternative come gli array di processori e sensori sul piano focale (FPSP) che consentono l'esecuzione di DNN a frame rate molto elevati, ordine di 1000 FPS, per dispositivi sempre attivi e auto autonome."

© 2018 Tech Xplore