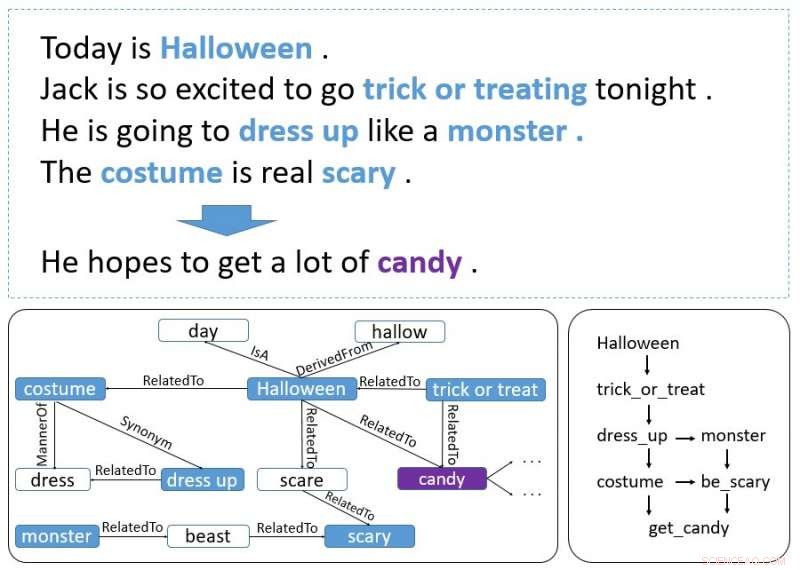

Un esempio di storia. Le parole in grassetto sono eventi ed entità. Il grafico in basso a sinistra viene recuperato da ConceptNet e il grafico in basso a destra rappresenta il modo in cui gli eventi e le entità formano l'indizio del contesto. Credito:Guan, Wang &Huang

I ricercatori dell'AI Lab della Tsinghua University hanno recentemente sviluppato un modello incrementale basato su encoder in grado di generare finali di storie. Un codificatore incrementale è un tipo di algoritmo di compressione della codifica che viene spesso utilizzato per comprimere i dati ordinati, come elenchi di parole o frasi.

Il nuovo modello, delineato in un documento pre-pubblicato su arXiv, impiega uno schema di codifica incrementale con attenzione multi-sorgente per elaborare indizi di contesto che si estendono in tutta una storia, generando una conclusione adeguata.

Inizialmente, i ricercatori erano interessati allo Story Cloze Test (SCT), in cui un sistema sceglie un finale corretto per una storia tra due possibilità disponibili. La ricerca precedente si è concentrata su questo particolare test per sviluppare strumenti di generazione di storie finali, ma il recente studio porta questa idea un passo avanti.

"Abbiamo pensato, perché non sviluppare un modello che da solo possa generare un finale? Quindi ci siamo inventati il compito di generazione della fine della storia, "Yansen Wang, uno dei ricercatori che hanno condotto lo studio ha detto a TechXplore. "Però, presto, abbiamo scoperto che generare un finale ragionevole della storia è un compito molto più impegnativo di quello originale perché richiede di catturare informazioni logiche e di causalità che possono estendersi su più frasi di un contesto di storia. L'uso del buon senso è necessario anche in questo compito, che non è così importante se vengono dati due possibili finali."

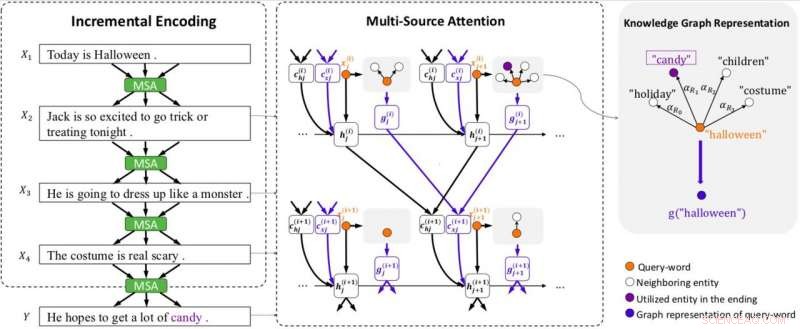

Panoramica del modello. Il modello è dotato di codifica incrementale (IE) e attenzione multi-sorgente (MSA) (inclusa l'attenzione del grafico per rappresentare i grafici della conoscenza). MSA produce vettori di contesto di stato (c (i) hj ) occupandosi degli stati nascosti (h (i) j ), e vettori di contesto di conoscenza (c (i) xj ) prestando attenzione ai vettori di grafo (g (i) j ) della frase precedente. IE utilizza i vettori del contesto di stato e conoscenza per creare codifiche di contesto in modo incrementale. Ogni grafico è rappresentato da un vettore (g (i) j ) usando l'attenzione del grafico. x (i) j denota la j-esima parola nella frase i. Credito:Guan, Wang &Huang

Per affrontare queste due sfide, i ricercatori hanno sviluppato uno schema di codifica incrementale con un meccanismo di attenzione multi-fonte in grado di generare finali efficaci per le storie. Questo sistema funziona codificando il contesto di una storia in modo incrementale, con il suo meccanismo di attenzione multi-fonte che utilizza sia indizi di contesto che conoscenza di buon senso.

"Lo schema di codifica incrementale che abbiamo sviluppato può codificare gli stati precedenti contenenti informazioni e relazioni tra le parole in modo incrementale, " Wang ha detto. "Il meccanismo di attenzione multi-fonte troverà e catturerà l'ordine cronologico o la relazione causale tra entità o eventi in frasi adiacenti. Per utilizzare la conoscenza del buon senso, un capo dell'attenzione multi-fonte indicherà una rappresentazione logica delle parole, che contiene la conoscenza di buon senso recuperata da ConceptNet."

La progettazione di questo modello si è rivelata un compito difficile e complesso, poiché diverse sfide dovevano essere superate per garantire che il sistema producesse conclusioni sensate. Infatti, un finale di una storia efficace dovrebbe considerare diversi aspetti della storia, si adattano bene al contesto e hanno anche un senso ragionevole.

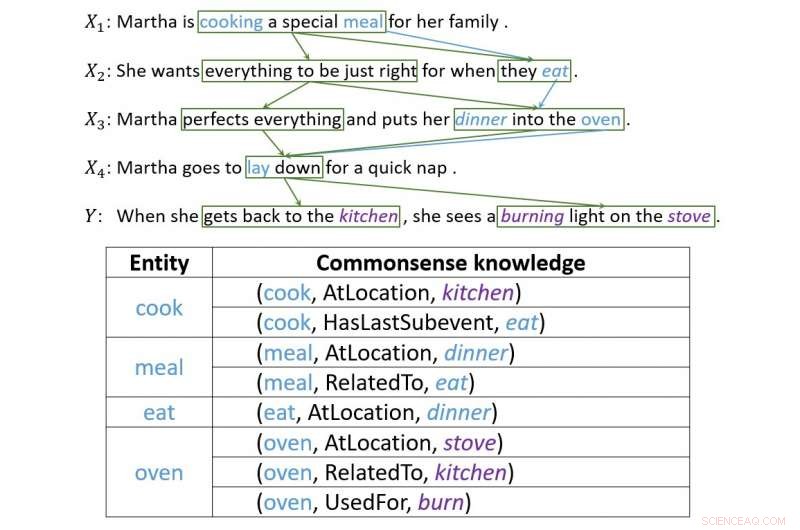

"La generazione del finale della storia richiede di catturare la logica e la causalità delle informazioni, " Wang ha spiegato. "Questo tipo di informazioni non è solo punto-punto. Nella maggior parte dei casi, forma una struttura più complessa, che la gente chiama "indizio del contesto". Abbiamo dedicato molto tempo alla progettazione del nostro modello, quindi è apparso lo schema di codifica incrementale. L'attenzione tra le frasi forma naturalmente una struttura a rete, e le informazioni logiche passate dall'attenzione sono proprio ciò che volevamo."

Un esempio che illustra come la codifica incrementale crea connessioni tra indizi di contesto. Credito:Guan, Wang &Huang

I ricercatori hanno valutato il loro modello e lo hanno confrontato con altri sistemi di generazione di fine storia. Hanno scoperto che potrebbe generare finali di storie molto più appropriati e ragionevoli rispetto alle linee di base allo stato dell'arte.

"Durante il test del modello, abbiamo ottenuto risultati affascinanti, " Wang ha detto. "Nei seguenti esperimenti, abbiamo anche scoperto che questo schema potrebbe trasmettere più informazioni, compresa la conoscenza del senso comune, solo se siamo in grado di rappresentare correttamente questo tipo di informazioni. Questo dimostra la flessibilità del nostro schema".

Il modello progettato da Wang e dai suoi colleghi dimostra fino a che punto può spingersi la tecnologia più recente, anche in compiti che finora sono stati principalmente completati da esseri umani. Pur avendo ottenuto risultati molto promettenti, i ricercatori ritengono che ci sia ancora un grande spazio di miglioramento.

"Stiamo ora cercando di applicare questo quadro a un corpus di storie più lunghe, poiché la lunghezza delle storie in SCT non è troppo lunga, " disse Wang. "Inoltre, poiché il framework di codifica incrementale può trasportare diversi tipi di informazioni, stiamo cercando di applicarlo ad altri tipi di attività che comportano il passaggio di informazioni a lungo termine, come la generazione di conversazioni a più turni."

© 2018 Tech Xplore