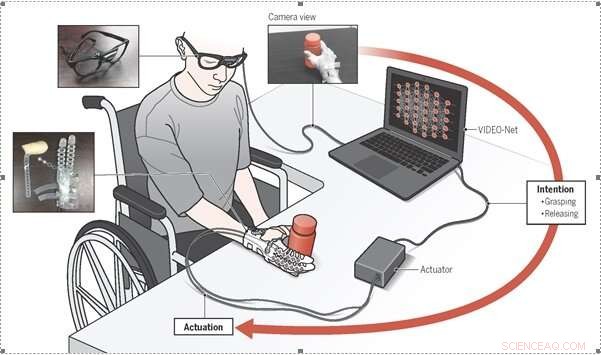

Un team di ricerca coreano ha creato un robot portatile indossabile che può aiutare i disabili che hanno perso la mobilità della mano. Il robot può rilevare l'intenzione dell'utente raccogliendo i comportamenti con l'algoritmo di apprendimento automatico. Credito:Centro di ricerca sulla robotica morbida, Università Nazionale di Seoul

Un team di ricerca coreano ha proposto un nuovo paradigma per un robot manuale indossabile che può aiutare le persone con mobilità ridotta della mano. Il robot manuale raccoglie i comportamenti degli utenti con un algoritmo di apprendimento automatico per determinare l'intenzione dell'utente.

Il professor Sungho Jo (KAIST) e Kyu-Jin Cho (Seoul National University) hanno proposto un nuovo paradigma di rilevamento dell'intenzione per i robot manuali indossabili. Il paradigma proposto prevede intenzioni di afferrare/rilasciare basate sui comportamenti degli utenti, consentendo ai pazienti con lesioni del midollo spinale (SCI) con perdita di mobilità della mano di raccogliere e posizionare oggetti.

Hanno sviluppato il metodo basato su un algoritmo di apprendimento automatico che prevede le intenzioni dell'utente tramite una telecamera in prima persona. Il loro sviluppo si basa sull'ipotesi che le intenzioni dell'utente possano essere dedotte attraverso la raccolta dei comportamenti del braccio dell'utente e delle interazioni mano-oggetto.

Il modello di apprendimento automatico utilizzato in questo studio, Rete di rilevamento dell'intenzione basata sulla visione da una vista EgOcentrica (VIDEO-Net), è progettato sulla base di questa ipotesi. VIDEO-Net è composto da sottoreti spaziali e temporali, che riconoscono i comportamenti del braccio dell'utente, e una sottorete spaziale che riconosce le interazioni mano-oggetto.

Un paziente con LM che indossa Exo-Glove Poly II, un robot mano morbido e indossabile, raccoglieva e posizionava con successo vari oggetti e svolgeva attività essenziali della vita quotidiana, come bere il caffè, senza alcun aiuto aggiuntivo.

Questo sviluppo è vantaggioso in quanto rileva le intenzioni dell'utente senza richiedere calibrazioni da persona a persona o azioni aggiuntive. Ciò consente a un essere umano di utilizzare il robot manuale indossabile senza problemi.

Intervista con il professor Kyu-Jin Cho

D:Come funziona questo sistema?

R:Questa tecnologia mira a prevedere le intenzioni dell'utente, afferrare e rilasciare in modo specifico l'intento verso un oggetto bersaglio, utilizzando una telecamera in prima persona montata su occhiali. VIDEONet, un algoritmo basato sul deep learning, è concepito per prevedere le intenzioni dell'utente dalla telecamera in base ai comportamenti del braccio dell'utente e alle interazioni mano-oggetto. Invece di usare bio-segnali, che viene spesso utilizzato per il rilevamento intenzionale delle persone disabili, usiamo una semplice telecamera per scoprire se la persona sta cercando di afferrare o meno. Funziona perché gli utenti target sono in grado di muovere il braccio, ma non le loro mani. Possiamo prevedere l'intenzione di afferrare dell'utente osservando il movimento del braccio e la distanza dall'oggetto e dalla mano, e interpretare l'osservazione utilizzando l'apprendimento automatico.

D:Chi trae vantaggio da questa tecnologia?

R:Come accennato in precedenza, questa tecnologia rileva le intenzioni dell'utente dai comportamenti del braccio umano e dalle interazioni mano-oggetto. Questa tecnologia può essere utilizzata da chiunque abbia perso la mobilità della mano a causa di lesioni del midollo spinale, ictus, paralisi cerebrale o qualsiasi altra condizione, purché possano muovere volontariamente il braccio.

D:Quali sono i limiti e i lavori futuri?

R:La maggior parte dei limiti deriva dagli svantaggi dell'utilizzo di una fotocamera monoculare. Per esempio, se un oggetto target è occluso da un altro oggetto, le prestazioni di questa tecnologia diminuiscono. Anche, se il gesto della mano dell'utente non è visibile nella scena della telecamera, la tecnologia non è utilizzabile. Per superare la mancanza di generalità dovuta a questi problemi, l'algoritmo deve essere migliorato incorporando altre informazioni del sensore o altri metodi di rilevamento delle intenzioni esistenti, come l'utilizzo di un sensore per elettromiografia o il monitoraggio dello sguardo.

D:Per utilizzare questa tecnologia nella vita quotidiana, di che cosa hai bisogno?

A:Affinché questa tecnologia possa essere utilizzata nella vita quotidiana, un utente ha bisogno di un robot manuale indossabile con un modulo di attuazione, un dispositivo informatico, e occhiali con una telecamera montata. Miriamo a ridurre le dimensioni e il peso del dispositivo informatico in modo che il robot possa essere portatile per essere utilizzato nella vita quotidiana. Abbiamo utilizzato un dispositivo informatico compatto che soddisfa le nostre esigenze, ma ci aspettiamo che siano disponibili in commercio chip neuromorfici in grado di eseguire calcoli di deep learning.