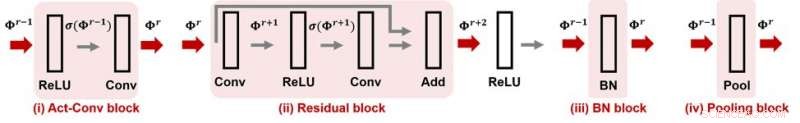

Figura 1. CNN-Cert supporta molti moduli popolari e operazioni sui livelli nelle reti neurali convoluzionali. Credito:IBM

Quando acquisti un orologio, potresti notare il suo grado di resistenza all'acqua, che indica che l'orologio è garantito per essere impermeabile fino a un certo livello. E la tua rete neurale? Si può garantire che una rete neurale sia "a prova di attacco", significa che la sua funzionalità è robusta contro le perturbazioni contraddittorie? Se è così, come può essere quantificato con un numero di resistenza all'attacco? All'AAAI 2019, il nostro gruppo di ricercatori del MIT e dell'IBM Research propone un metodo efficiente ed efficace per certificare la resistenza agli attacchi delle reti neurali convoluzionali a dati di input. Questo paper è selezionato per la presentazione orale all'AAAI 2019 (30 gennaio, 14:00-15:30 @ coral 1).

Gli attuali modelli di reti neurali profonde sono noti per essere vulnerabili alle perturbazioni contraddittorie. Una perturbazione accuratamente realizzata ma piccola per i dati di input potrebbe facilmente manipolare la previsione dell'output del modello, comprese le attività di apprendimento automatico come il riconoscimento di oggetti, traduzione vocale, didascalia delle immagini, e classificazione dei testi, per dirne alcuni. La mancanza di solidità alle perturbazioni contraddittorie comporta nuove sfide nella ricerca sull'IA e può ostacolare la nostra fiducia nei sistemi di intelligenza artificiale.

Data una rete neurale e considerando un modello di minaccia contraddittorio in cui la forza di attacco è caratterizzata dalla norma Lp della perturbazione, per qualsiasi inserimento di dati, la sua robustezza contraddittoria può essere quantificata come la forza di attacco minima richiesta per alterare la previsione del modello (vedi Figura 1 nel post precedente per un'illustrazione visiva). Qui, un certificato di robustezza a prova di attacco per un input specifica una forza di attacco ε e offre la seguente resistenza agli attacchi garantita:sotto il modello di minaccia limitato dalla norma, nessuna perturbazione contraddittoria può alterare la previsione dell'input se la loro forza di attacco è inferiore a . In altre parole, più grande significa che l'input è più robusto. Questa certificazione di robustezza può essere cruciale nelle applicazioni di intelligenza artificiale critiche per la sicurezza o sensibili ai costi che richiedono alta precisione e affidabilità, come i sistemi di guida autonoma.

Il nostro metodo proposto, CNN-Cert, fornisce un quadro generale ed efficiente per certificare il livello di robustezza contraddittoria delle reti neurali convoluzionali a dati di input. Il nostro framework è generale:possiamo gestire varie architetture inclusi layer convoluzionali, strati di massimo raggruppamento, livello di normalizzazione batch, blocchi residui, oltre a funzioni generali di attivazione come ReLU, tan, sigmoideo e arctano. La Figura 1 mostra alcuni elementi costitutivi comunemente usati considerati nel nostro framework CNN-Cert. La tecnica chiave in CNN-Cert è derivare l'output di rete esplicito vincolato considerando le relazioni input/output di ciascun blocco costitutivo, contrassegnati da frecce rosse. Il livello di attivazione può essere attivazioni generali diverse da ReLU. Il nostro approccio è anche efficiente:sfruttando la struttura speciale degli strati convoluzionali, otteniamo fino a 17 e 11 volte di accelerazione rispetto agli algoritmi di certificazione all'avanguardia e 366 volte di accelerazione rispetto a un approccio standard dual-LP mentre il nostro metodo ottiene limiti di resistenza agli attacchi simili o addirittura migliori .

Questa storia è stata ripubblicata per gentile concessione di IBM Research. Leggi la storia originale qui.