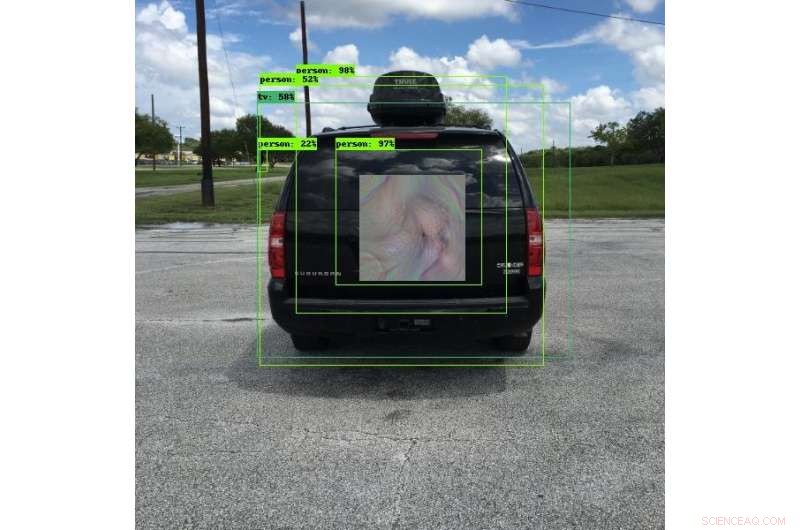

Molti dei veicoli odierni utilizzano sistemi di rilevamento degli oggetti per evitare collisioni. Gli ingegneri SwRI hanno sviluppato modelli unici che possono indurre questi sistemi a vedere qualcos'altro, vedere gli oggetti in un'altra posizione o non vederli affatto. In questa foto, il sistema di rilevamento oggetti vede una persona piuttosto che un veicolo. Questa ricerca consentirà agli ingegneri di testare a fondo i sistemi di rilevamento degli oggetti e migliorare la sicurezza degli algoritmi di deep learning che utilizzano. Credito:Southwest Research Institute

Nuove tecniche contraddittorie sviluppate dagli ingegneri del Southwest Research Institute possono rendere gli oggetti "invisibili" ai sistemi di rilevamento delle immagini che utilizzano algoritmi di deep learning. Queste tecniche possono anche indurre i sistemi a pensare di vedere un altro oggetto o di modificare la posizione degli oggetti. La tecnica riduce il rischio di compromissione nei sistemi di elaborazione automatica delle immagini.

"Le reti neurali di deep learning sono molto efficaci in molti compiti, " afferma l'ingegnere di ricerca Abe Garza della divisione SwRI Intelligent Systems. "Tuttavia, il deep learning è stato adottato così rapidamente che le implicazioni sulla sicurezza di questi algoritmi non sono state completamente considerate."

Gli algoritmi di deep learning eccellono nell'uso di forme e colori per riconoscere le differenze tra esseri umani e animali o automobili e camion, Per esempio. Questi sistemi rilevano in modo affidabile gli oggetti in una serie di condizioni e, come tale, sono utilizzati in una miriade di applicazioni e industrie, spesso per usi critici per la sicurezza. L'industria automobilistica utilizza sistemi di rilevamento di oggetti ad apprendimento profondo sulle strade per l'assistente di corsia, tecnologie di abbandono della corsia e di prevenzione delle collisioni. Questi veicoli si affidano a telecamere per rilevare oggetti potenzialmente pericolosi intorno a loro. Mentre i sistemi di elaborazione delle immagini sono vitali per proteggere vite e proprietà, gli algoritmi possono essere ingannati da parti intente a causare danni.

I ricercatori di sicurezza che lavorano nell'"adversarial learning" stanno trovando e documentando le vulnerabilità negli algoritmi di apprendimento automatico e in profondità. Utilizzando i fondi di ricerca interni SwRI, Garza e l'ingegnere di ricerca senior David Chambers hanno sviluppato quello che sembra futuristico, Motivi in stile bohémien. Se indossato da una persona o montato su un veicolo, i modelli inducono le telecamere di rilevamento degli oggetti a pensare che gli oggetti non ci siano, che sono qualcos'altro o che si trovano in un'altra posizione. Le parti malintenzionate potrebbero posizionare questi modelli vicino alle strade, potenzialmente creando caos per i veicoli dotati di rilevatori di oggetti.

Quello che all'occhio umano sembra un motivo colorato sembra una bicicletta a un sistema di rilevamento di oggetti. Sebbene gli algoritmi di deep learning utilizzati in questi sistemi siano affidabili, possono essere ingannati con immagini speciali. I ricercatori di SwRI stanno sviluppando tecniche per mitigare il rischio di compromissione in questi sistemi. Credito:Southwest Research Institute

"Questi modelli fanno sì che gli algoritmi della fotocamera classifichino o identifichino erroneamente gli oggetti, creare una vulnerabilità, " ha detto Garza. "Chiamiamo questi modelli 'percezione invariante' esempi contraddittori perché non hanno bisogno di coprire l'intero oggetto o essere paralleli alla telecamera per ingannare l'algoritmo. Gli algoritmi possono classificare erroneamente l'oggetto purché percepiscano una parte del modello".

Anche se all'occhio umano potrebbero sembrare esibizioni d'arte uniche e colorate, questi modelli sono progettati in modo tale che i sistemi di telecamere di rilevamento degli oggetti li vedano in modo molto specifico. Un motivo mascherato da pubblicità sul retro di un autobus fermo potrebbe far credere a un sistema di prevenzione delle collisioni di vedere una borsa della spesa innocua invece dell'autobus. Se la telecamera del veicolo non riesce a rilevare l'oggetto reale, potrebbe continuare ad andare avanti e colpire l'autobus, provocando una collisione potenzialmente grave.

"Il primo passo per risolvere questi exploit è testare gli algoritmi di deep learning, " ha affermato Garza. Il team ha creato un framework in grado di testare ripetutamente questi attacchi contro una varietà di programmi di rilevamento di deep learning, che sarà estremamente utile per testare le soluzioni.

I ricercatori SwRI continuano a valutare quanto, o quanto poco, del modello è necessario per classificare o localizzare erroneamente un oggetto. Lavorare con i clienti, questa ricerca consentirà al team di testare i sistemi di rilevamento degli oggetti e, in definitiva, di migliorare la sicurezza degli algoritmi di deep learning.