Credito:Marquez, Suarez-Vargas &Shastri.

Un team di ricercatori della Queen's University, in Canada, hanno recentemente proposto un nuovo metodo per ridimensionare le reti neurali ricorrenti casuali (rRNN), una classe di reti neurali artificiali che viene spesso utilizzata per fare previsioni dai dati. Il loro approccio, presentato in un articolo pre-pubblicato su arXiv, consente agli sviluppatori di ridurre al minimo il numero di neuroni nel livello nascosto di un rRNN, migliorando di conseguenza le sue prestazioni di previsione.

"Il nostro laboratorio si concentra sulla progettazione di hardware per applicazioni di intelligenza artificiale, "Bicky Marquez, uno dei ricercatori che ha condotto lo studio, ha detto a TechXplore. "In questo studio, cercavamo strategie per comprendere i principi di funzionamento delle reti neurali, e allo stesso tempo, cercando di ridurre il numero di neuroni nelle reti che miravamo a costruire senza influire negativamente sulle loro prestazioni durante la risoluzione di un compito. Il compito principale che volevamo affrontare era la previsione, poiché questo è sempre stato di grande interesse per la comunità scientifica e la società in generale."

Lo sviluppo di strumenti di apprendimento automatico in grado di prevedere modelli futuri dai dati è diventato l'obiettivo principale di numerosi gruppi di ricerca in tutto il mondo. Questo è tutt'altro che sorprendente, poiché la previsione di eventi futuri potrebbe avere importanti applicazioni in una varietà di campi, ad esempio, previsione del tempo, prevedere i movimenti delle scorte, o mappare l'evoluzione di alcune patologie umane.

Lo studio condotto da Marquez e dai suoi colleghi è di natura interdisciplinare, poiché unisce teorie relative a sistemi dinamici non lineari, analisi di serie temporali, e apprendimento automatico. Gli obiettivi primari dei ricercatori erano estendere il toolkit precedentemente disponibile per l'analisi della rete neurale, minimizzare il numero di neuroni nello strato nascosto di rRNN, e rimuovere parzialmente la proprietà black-box di queste reti.

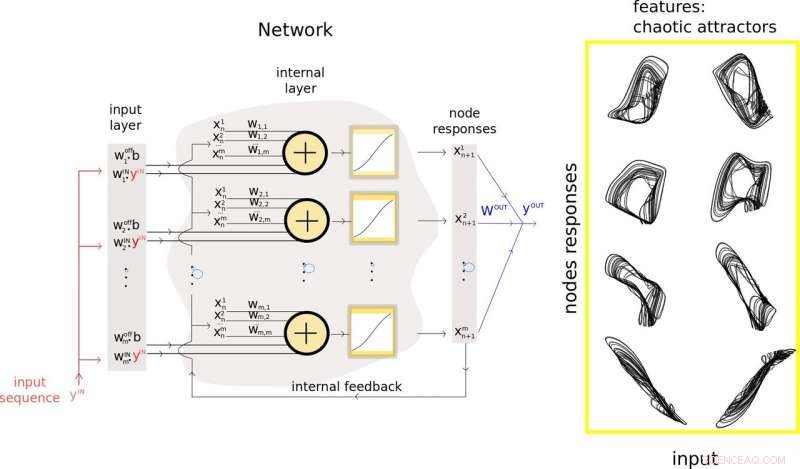

Per realizzare questo, hanno introdotto una nuova metodologia che unisce la teoria della previsione e l'apprendimento automatico in un unico framework. La loro tecnica può essere utilizzata per estrarre e utilizzare le caratteristiche rilevanti dei dati di input di un rNN e guidare il processo di ridimensionamento dei suoi strati nascosti, migliorando infine le sue prestazioni di previsione.

I ricercatori hanno utilizzato le informazioni raccolte nel loro studio per sviluppare un nuovo modello di rete neurale artificiale chiamato processore ispirato ai Takens. Questo modello, composto da neuroni reali e virtuali, raggiunto prestazioni all'avanguardia su problemi complessi come alta qualità, previsione a lungo termine di segnali caotici.

"Il vantaggio principale del nostro modello è che affronta i problemi creati dall'enorme quantità di neuroni che compongono le tipiche reti neurali artificiali, " Marquez ha spiegato. "L'eccesso di neuroni in questi modelli si traduce comunemente in problemi computazionalmente costosi quando si considera l'ottimizzazione di tali reti per risolvere un compito. L'inclusione del concetto di neuroni virtuali nel nostro progetto è un passo molto conveniente per la riduzione della quantità di neuroni fisici".

Nel loro studio, Marquez e i suoi colleghi hanno anche usato il loro processore ibrido per stabilizzare un modello neurale aritmico di eccitabilità neuronale chiamato Fitz-Hugh-Nagumo. La loro metodologia ha permesso loro di ridurre le dimensioni della rete neurale stabilizzante di un fattore 15 rispetto ad altre reti neurali standard.

"Il nostro approccio ci ha permesso di scoprire alcune caratteristiche rilevanti che vengono create all'interno dello spazio delle reti, e quali sono gli agenti fondamentali di previsioni di successo, " ha detto Marquez. "Se siamo in grado di identificare e rimuovere il rumore intorno a quelle caratteristiche importanti, potremmo usarli per migliorare le prestazioni delle nostre reti."

La metodologia ideata da Marquez e dai suoi colleghi è un'importante aggiunta agli strumenti precedentemente disponibili per lo sviluppo e l'analisi di rRNN. Nel futuro, il loro approccio potrebbe informare la progettazione di reti neurali più efficaci per la previsione, riducendo il numero di nodi e connessioni in essi contenuti. La loro tecnica potrebbe anche rendere gli rRNN più trasparenti, consentendo agli utenti di accedere a informazioni chiave su come un sistema ha raggiunto una determinata conclusione.

"Siamo concentrati sull'hardware neuromorfo, " Disse Marquez. "Pertanto, i nostri prossimi passi saranno relativi all'implementazione fisica di tali reti casuali ricorrenti. Il nostro obiettivo finale è progettare computer ispirati al cervello in grado di risolvere i problemi di intelligenza artificiale in modo molto efficiente:ultraveloci e con un basso consumo energetico".

© 2019 Scienza X Rete