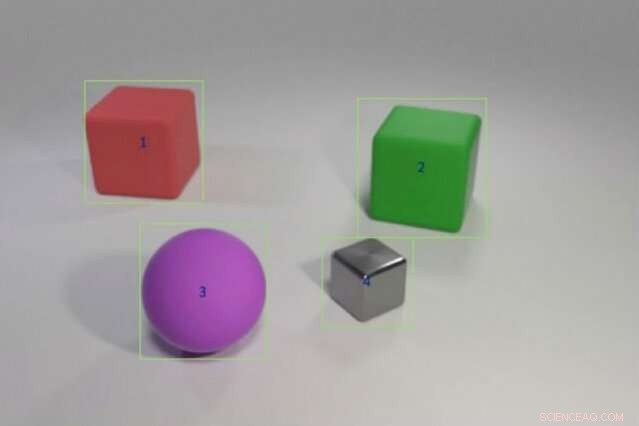

I ricercatori hanno addestrato un modello ibrido di intelligenza artificiale per rispondere a domande come "L'oggetto rosso a sinistra del cubo verde ha la stessa forma della cosa opaca viola?" fornendogli esempi di colori e forme degli oggetti seguiti da scenari più complessi che coinvolgono confronti tra più oggetti. Il modello potrebbe trasferire questa conoscenza a nuovi scenari così come o meglio dei modelli all'avanguardia utilizzando una frazione dei dati di addestramento. Credito:Justin Johnson

Un bambino che non ha mai visto un elefante rosa può ancora descriverne uno, a differenza di un computer. "Il computer impara dai dati, "dice Jiajun Wu, un dottorato di ricerca studente al MIT. "La capacità di generalizzare e riconoscere qualcosa che non hai mai visto prima, un elefante rosa, è molto difficile per le macchine".

I sistemi di deep learning interpretano il mondo individuando modelli statistici nei dati. Questa forma di machine learning è ormai ovunque, taggare automaticamente gli amici su Facebook, narrando le ultime previsioni del tempo di Alexa, e fornire fatti divertenti tramite la ricerca su Google. Ma l'apprendimento statistico ha i suoi limiti. Richiede tonnellate di dati, ha difficoltà a spiegare le sue decisioni, ed è terribile nell'applicare la conoscenza passata a nuove situazioni; Non può comprendere un elefante rosa invece che grigio.

Per dare ai computer la capacità di ragionare più come noi, i ricercatori di intelligenza artificiale (AI) stanno tornando all'astratto, o simbolico, programmazione. Popolare negli anni '50 e '60, fili simbolici di intelligenza artificiale nelle regole e nella logica che consentono alle macchine di effettuare confronti e interpretare il modo in cui oggetti ed entità si relazionano. L'IA simbolica utilizza meno dati, registra la catena di passaggi necessari per raggiungere una decisione, e quando combinato con la potenza di elaborazione bruta delle reti neurali statistiche, può persino battere gli umani in un complicato test di comprensione delle immagini.

Un nuovo studio di un team di ricercatori del MIT, MIT-IBM Watson AI Lab, e DeepMind mostra la promessa di unire AI statistica e simbolica. Guidato da Wu e Joshua Tenenbaum, professore al Dipartimento di Scienze del Cervello e Cognitive del MIT e al Laboratorio di Informatica e Intelligenza Artificiale, il team mostra che il suo modello ibrido può apprendere concetti relativi agli oggetti come colore e forma, e sfruttare tale conoscenza per interpretare complesse relazioni di oggetti in una scena. Con dati di addestramento minimi e nessuna programmazione esplicita, il loro modello potrebbe trasferire concetti su scene più grandi e rispondere a domande sempre più difficili così come o meglio dei suoi pari all'avanguardia. Il team presenta i suoi risultati alla Conferenza internazionale sulle rappresentazioni dell'apprendimento a maggio.

"Un modo in cui i bambini imparano i concetti è collegando le parole alle immagini, " dice l'autore principale dello studio Jiayuan Mao, uno studente universitario alla Tsinghua University che ha lavorato al progetto come visiting fellow al MIT. "Una macchina che può apprendere allo stesso modo ha bisogno di molti meno dati, ed è in grado di trasferire meglio le sue conoscenze su nuovi scenari."

Lo studio è un forte argomento per tornare ad approcci di programma astratto, dice Jacob Andreas, un neolaureato dell'Università della California a Berkeley, che inizia al MIT come assistente professore questo autunno e non è stato coinvolto nel lavoro. "Il trucco, si scopre, è aggiungere più struttura simbolica, e per alimentare le reti neurali una rappresentazione del mondo che è diviso in oggetti e proprietà piuttosto che alimentarlo con immagini grezze, " dice. "Questo lavoro ci fornisce un'idea di ciò che le macchine devono capire prima che sia possibile l'apprendimento delle lingue".

Il team ha addestrato il proprio modello su immagini abbinate a domande e risposte correlate, parte del test di comprensione delle immagini CLEVR sviluppato presso la Stanford University. Man mano che il modello apprende, le domande diventano progressivamente più difficili, a partire dal, "Di che colore è l'oggetto?" a "Quanti oggetti sono entrambi a destra del cilindro verde e hanno lo stesso materiale della pallina blu?" Una volta padroneggiati i concetti a livello di oggetto, il modello avanza imparando come mettere in relazione gli oggetti e le loro proprietà tra loro.

Come altri modelli di intelligenza artificiale ibridi, Il MIT funziona suddividendo il compito. Un modulo di percezione delle reti neurali sgranocchia i pixel in ogni immagine e mappa gli oggetti. Un modulo linguistico, fatto anche di reti neurali, estrae un significato dalle parole in ogni frase e crea programmi simbolici, o istruzioni, che dicono alla macchina come rispondere alla domanda. Un terzo modulo di ragionamento esegue i programmi simbolici sulla scena e fornisce una risposta, aggiornare il modello quando commette errori.

La chiave dell'approccio del team è un modulo di percezione che traduce l'immagine in una rappresentazione basata sull'oggetto, rendendo i programmi più facili da eseguire. Unico è anche quello che chiamano apprendimento del curriculum, o addestrare selettivamente il modello su concetti e scene che diventano progressivamente più difficili. Si scopre che alimentando i dati macchina in modo logico, piuttosto che a casaccio, aiuta il modello ad apprendere più velocemente migliorando la precisione.

Una volta che il modello ha solide basi, può interpretare nuove scene e concetti, e domande sempre più difficili, quasi perfettamente. Chiesto di rispondere a una domanda sconosciuta come, "Qual è la forma della grande cosa gialla?" ha superato i suoi colleghi di Stanford e del vicino MIT Lincoln Laboratory con una frazione dei dati.

Mentre altri modelli sono stati addestrati sull'intero set di dati CLEVR di 70, 000 immagini e 700, 000 domande, il modello MIT-IBM usava 5, 000 immagini e 100, 000 domande. Poiché il modello è costruito su concetti appresi in precedenza, ha assorbito i programmi sottesi a ciascuna domanda, accelerare il processo di formazione.

Sebbene statistico, modelli di deep learning sono ora integrati nella vita quotidiana, gran parte del loro processo decisionale rimane nascosto alla vista. Questa mancanza di trasparenza rende difficile prevedere dove il sistema è suscettibile di manipolazione, errore, o pregiudizio. L'aggiunta di un livello simbolico può aprire la scatola nera, spiegando il crescente interesse per i sistemi di intelligenza artificiale ibridi.

"Splittare il compito e lasciare che i programmi facciano parte del lavoro è la chiave per costruire l'interpretabilità in modelli di apprendimento profondo, ", afferma il ricercatore del Lincoln Laboratory David Mascharka, il cui modello ibrido, Trasparenza da Design Network, è valutato nello studio MIT-IBM.

Il team MIT-IBM sta ora lavorando per migliorare le prestazioni del modello su foto del mondo reale ed estenderlo alla comprensione dei video e alla manipolazione robotica. Altri autori dello studio sono Chuang Gan e Pushmeet Kohli, ricercatori del MIT-IBM Watson AI Lab e DeepMind, rispettivamente.

Questa storia è stata ripubblicata per gentile concessione di MIT News (web.mit.edu/newsoffice/), un popolare sito che copre notizie sulla ricerca del MIT, innovazione e didattica.