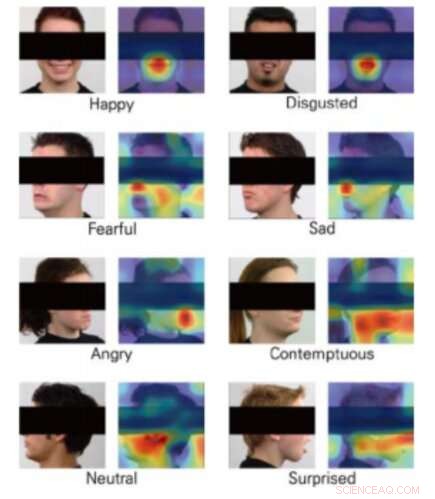

Mappe di attivazione della classe per 8 emozioni. Credito:Yong, Lee &Choi.

La Realtà Virtuale (VR) sta aprendo nuove entusiasmanti frontiere nello sviluppo di videogiochi, aprendo la strada a sempre più realistici, esperienze di gioco interattive e immersive. console VR, infatti, permettere ai giocatori di sentirsi come se fossero quasi all'interno del gioco, superare le limitazioni associate alla risoluzione dello schermo e ai problemi di latenza.

Un'ulteriore integrazione interessante per la realtà virtuale sarebbe il riconoscimento delle emozioni, in quanto ciò potrebbe consentire lo sviluppo di giochi che rispondono alle emozioni dell'utente in tempo reale. Con questo in testa, un team di ricercatori della Yonsei University e Motion Device Inc. ha recentemente proposto una tecnica basata sul deep learning che potrebbe consentire il riconoscimento delle emozioni durante le esperienze di gioco VR. Il loro documento è stato presentato alla Conferenza IEEE del 2019 sulla realtà virtuale e le interfacce utente 3D.

Affinché la realtà virtuale funzioni, gli utenti indossano display montati sulla testa (HMD), in modo che il contenuto di un gioco possa essere presentato direttamente davanti ai loro occhi. L'unione di strumenti di riconoscimento delle emozioni con esperienze di gioco VR si è quindi rivelata una sfida, poiché la maggior parte dei modelli di apprendimento automatico per la previsione delle emozioni funziona analizzando i volti delle persone; in realtà virtuale, il volto di un utente è parzialmente occluso dall'HMD.

Il team di ricercatori della Yonsei University e di Motion Device ha addestrato tre reti neurali convoluzionali (CNN), ovvero DenseNet, ResNet e Inception-ResNet-V2—per prevedere le emozioni delle persone da immagini parziali di volti. Hanno preso immagini dal Radbound Faces Dataset (RaFD), che comprende 8, 040 immagini di volti di 67 soggetti, quindi modificarli coprendo la parte del viso che sarebbe stata occlusa dall'HMD quando si utilizza la realtà virtuale.

Le immagini utilizzate per addestrare gli algoritmi ritraggono volti umani, ma la sezione contenente gli occhi, orecchie e sopracciglia è coperto da un rettangolo nero. Quando i ricercatori hanno valutato le loro CNN, hanno scoperto di essere in grado di classificare le emozioni anche senza analizzare queste particolari caratteristiche del volto di una persona, che si ritiene siano di fondamentale importanza per il riconoscimento delle emozioni.

Globale, la CNN chiamata DenseNet si è comportata meglio delle altre, raggiungendo precisioni medie di oltre il 90%. interessante, però, l'algoritmo ResNet ha superato gli altri due nella classificazione delle espressioni facciali che trasmettevano paura e disgusto.

"Abbiamo addestrato con successo tre architetture della CNN che stimano le emozioni dalle immagini del volto umano parzialmente coperte, I ricercatori hanno scritto nel loro articolo. "Il nostro studio ha mostrato la possibilità di stimare le emozioni da immagini di esseri umani che indossano HMD utilizzando la visione artificiale".

Lo studio suggerisce che in futuro, gli strumenti di riconoscimento delle emozioni potrebbero essere integrati con la tecnologia VR, anche se gli HMD occludono parti del viso di un giocatore. Inoltre, le CNN sviluppate dai ricercatori potrebbero ispirare altri team di ricerca in tutto il mondo a sviluppare nuove tecniche di riconoscimento delle emozioni che possono essere applicate ai giochi VR.

I ricercatori stanno ora pianificando di sostituire i rettangoli neri che hanno usato nel loro studio con immagini reali di persone che indossano HDM. Ciò dovrebbe in definitiva consentire loro di formare le CNN in modo più affidabile ed efficace, preparandoli per applicazioni nella vita reale.

© 2019 Scienza X Rete