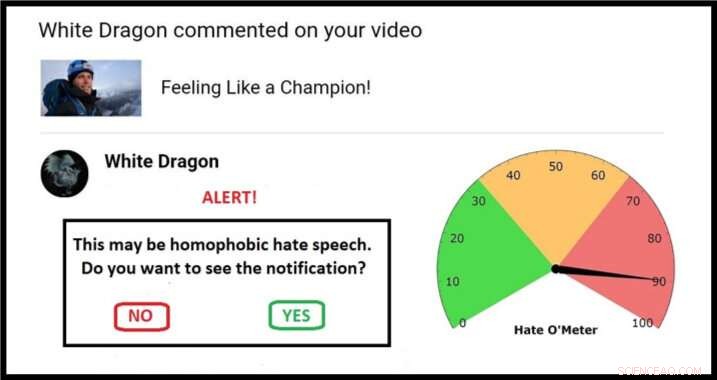

Esempio di un possibile approccio per una schermata di quarantena, completo di Hate O'Meter. Credito:Stefanie Ullman

La diffusione dell'incitamento all'odio attraverso i social media potrebbe essere affrontata utilizzando lo stesso approccio di "quarantena" utilizzato per combattere il software dannoso, secondo i ricercatori dell'Università di Cambridge.

Le definizioni di incitamento all'odio variano a seconda della nazione, legge e piattaforma, e il solo blocco delle parole chiave è inefficace:le descrizioni esplicite della violenza non devono contenere ovvi insulti etnici per costituire minacce di morte razziste, Per esempio.

Come tale, l'incitamento all'odio è difficile da rilevare automaticamente. Deve essere segnalato da coloro che vi sono esposti, dopo che è stato inflitto il "danno psicologico" previsto, con eserciti di moderatori tenuti a giudicare ogni caso.

Questa è la nuova prima linea di un antico dibattito:libertà di parola contro linguaggio velenoso.

Ora, un ingegnere e un linguista hanno pubblicato una proposta sulla rivista Etica e tecnologia dell'informazione che sfrutta le tecniche di sicurezza informatica per dare il controllo a coloro che sono presi di mira, senza ricorrere alla censura.

Gli esperti di lingue e machine learning di Cambridge utilizzano database di minacce e insulti violenti per costruire algoritmi in grado di fornire un punteggio per la probabilità che un messaggio online contenga forme di incitamento all'odio.

Man mano che questi algoritmi vengono perfezionati, potenziali incitamenti all'odio potrebbero essere identificati e "messi in quarantena". Gli utenti riceverebbero un avviso con un "Hate O'Meter"—il punteggio di gravità dell'incitamento all'odio—il nome del mittente, e un'opzione per visualizzare il contenuto o eliminare non visto.

Questo approccio è simile ai filtri antispam e antimalware, e i ricercatori del progetto "Giving Voice to Digital Democracies" ritengono che potrebbe ridurre drasticamente la quantità di incitamento all'odio che le persone sono costrette a sperimentare. Stanno puntando ad avere un prototipo pronto all'inizio del 2020.

"L'incitamento all'odio è una forma di danno online intenzionale, come malware, e può quindi essere gestito mediante la messa in quarantena, " ha detto la coautrice e linguista Dr. Stefanie Ullman. "In effetti, molti incitamenti all'odio sono in realtà generati da software come i bot di Twitter".

"Aziende come Facebook, Twitter e Google generalmente rispondono in modo reattivo all'incitamento all'odio, " ha detto il co-autore e ingegnere Dr. Marcus Tomalin. "Questo può andare bene per coloro che non lo incontrano spesso. Per altri è troppo poco, troppo tardi."

"Molte donne e persone appartenenti a gruppi minoritari agli occhi del pubblico ricevono incitamenti anonimi all'odio per aver osato avere una presenza online. Stiamo vedendo questo scoraggiare le persone dall'entrare o continuare nella vita pubblica, spesso quelli di gruppi che necessitano di maggiore rappresentanza, " Egli ha detto.

L'ex segretario di Stato americano Hillary Clinton ha recentemente dichiarato a un pubblico del Regno Unito che l'incitamento all'odio rappresenta una "minaccia per le democrazie", sulla scia di molte donne parlamentari che citano gli abusi online come parte del motivo per cui non si candideranno più alle elezioni.

Mentre in un indirizzo della Georgetown University, Il CEO di Facebook Mark Zuckerberg ha parlato di "ampi disaccordi su ciò che si qualifica come odio" e ha sostenuto:"dovremmo peccare per una maggiore espressione".

I ricercatori dicono che la loro proposta non è una bacchetta magica, ma si colloca tra gli "approcci libertari e autoritari estremi" di consentire o vietare completamente un certo linguaggio online.

È importante sottolineare che l'utente diventa l'arbitro. "A molte persone non piace l'idea di una corporazione non eletta o di un governo micro-amministrativo che decide cosa possiamo e non possiamo dirci l'un l'altro, " disse Tomalin.

"Il nostro sistema segnalerà quando dovresti stare attento, ma è sempre una tua chiamata Non impedisce alle persone di pubblicare o visualizzare ciò che gli piace, ma dà il controllo tanto necessario a coloro che sono inondati dall'odio."

Nella carta, i ricercatori fanno riferimento ad algoritmi di rilevamento che raggiungono il 60% di precisione, non molto meglio del caso. Il laboratorio di machine learning di Tomalin ora ha raggiunto l'80%, e prevede un continuo miglioramento della modellizzazione matematica.

Nel frattempo, Ullman raccoglie più "dati di formazione":discorsi di odio verificati da cui gli algoritmi possono imparare. Questo aiuta a perfezionare i "punteggi di fiducia" che determinano una quarantena e la successiva lettura di Hate O'Meter, che potrebbe essere impostato come un quadrante di sensibilità a seconda delle preferenze dell'utente.

Un esempio di base potrebbe coinvolgere una parola come "cagna":un insulto misoginistico, ma anche un termine legittimo in contesti come l'allevamento di cani. È l'analisi algoritmica di dove una parola del genere si trova sintatticamente - i tipi di parole circostanti e le relazioni semantiche tra di loro - che informa il punteggio dell'incitamento all'odio.

"Identificare singole parole chiave non è sufficiente, stiamo esaminando intere strutture di frase e ben oltre. Le informazioni sociolinguistiche nei profili degli utenti e nelle cronologie dei post possono contribuire a migliorare il processo di classificazione, " disse Ullman.

Tomalin aggiunto:"Attraverso le quarantene automatizzate che forniscono indicazioni sulla forza dei contenuti che incitano all'odio, possiamo dare potere a coloro che ricevono il discorso di odio che avvelena i nostri discorsi online".

Però, i ricercatori, che lavorano nel Centre for Research into Arts di Cambridge, Scienze umane e sociali (CRASSH), dire che, come con i virus informatici, ci sarà sempre una corsa agli armamenti tra l'incitamento all'odio e i sistemi per limitarlo.

Il progetto ha anche iniziato a esaminare il "contro-discorso":i modi in cui le persone rispondono all'incitamento all'odio. I ricercatori intendono alimentare i dibattiti su come gli assistenti virtuali come "Siri" dovrebbero rispondere alle minacce e alle intimidazioni.