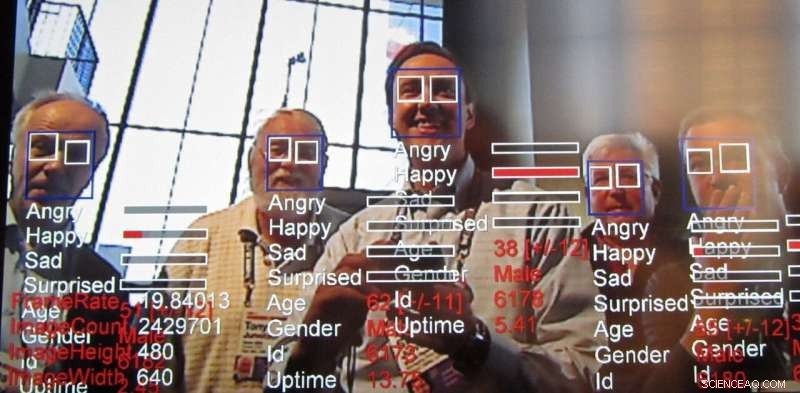

Tecnologia di riconoscimento delle emozioni, una conseguenza della tecnologia di riconoscimento facciale, continua ad avanzare velocemente. Credito:Steve Jurvetson/flickr, CC BY-SA

Nella sua relazione annuale, l'Istituto AI Now, un centro di ricerca interdisciplinare che studia le implicazioni sociali dell'intelligenza artificiale, ha chiesto il divieto della tecnologia progettata per riconoscere le emozioni delle persone in alcuni casi. Nello specifico, i ricercatori hanno detto che influenzano la tecnologia di riconoscimento, chiamata anche tecnologia di riconoscimento delle emozioni, non dovrebbero essere utilizzati nelle decisioni che "incidono sulla vita delle persone e sull'accesso alle opportunità, " come decisioni di assunzione o valutazioni del dolore, perché non è sufficientemente accurato e può portare a decisioni distorte.

Cos'è questa tecnologia, che è già utilizzato e commercializzato, e perché desta preoccupazioni?

Risultato del riconoscimento facciale

I ricercatori hanno lavorato attivamente su algoritmi di visione artificiale in grado di determinare le emozioni e le intenzioni degli esseri umani, oltre a fare altre inferenze, per almeno un decennio. L'analisi dell'espressione facciale esiste almeno dal 2003. I computer sono stati in grado di comprendere le emozioni anche più a lungo. Questa ultima tecnologia si basa sulle tecniche incentrate sui dati note come "apprendimento automatico, " algoritmi che elaborano dati per "imparare" a prendere decisioni, per ottenere un riconoscimento affettivo ancora più accurato.

La sfida di leggere le emozioni

I ricercatori cercano sempre di fare cose nuove basandosi su ciò che è stato fatto in precedenza. Il riconoscimento delle emozioni è allettante perché, in qualche modo, noi come esseri umani possiamo farlo relativamente bene fin dalla tenera età, eppure replicare abilmente quell'abilità umana usando la visione artificiale è ancora una sfida. Anche se è possibile fare cose davvero notevoli con le immagini, come stilizzare una foto per farla sembrare disegnata da un artista famoso e persino creare volti fotorealistici – per non parlare dei cosiddetti deepfake – la capacità di dedurre proprietà come le emozioni umane da un'immagine reale ha sempre stato di interesse per i ricercatori.

Le emozioni sono difficili perché tendono a dipendere dal contesto. Ad esempio, quando qualcuno si sta concentrando su qualcosa potrebbe sembrare che stia semplicemente pensando. Il riconoscimento facciale ha fatto molta strada grazie all'apprendimento automatico, ma identificare lo stato emotivo di una persona basandosi esclusivamente sul guardare il viso di una persona manca di informazioni chiave. Le emozioni si esprimono non solo attraverso l'espressione di una persona, ma anche dove si trova e cosa sta facendo. Questi segnali contestuali sono difficili da inserire anche nei moderni algoritmi di apprendimento automatico. Per affrontare questo, ci sono sforzi attivi per aumentare le tecniche di intelligenza artificiale per considerare il contesto, non solo per il riconoscimento delle emozioni, ma per tutti i tipi di applicazioni.

Leggere le emozioni dei dipendenti

Il rapporto pubblicato da AI Now fa luce su alcuni modi in cui l'intelligenza artificiale viene applicata alla forza lavoro per valutare la produttività dei lavoratori e già nella fase di intervista. Analizzando i filmati delle interviste, soprattutto per chi cerca lavoro a distanza, è già in corso. Se i manager possono avere un senso delle emozioni dei loro subordinati dal colloquio alla valutazione, il processo decisionale in merito ad altre questioni occupazionali come aumenti, promozioni o incarichi potrebbero finire per essere influenzati da tali informazioni. Ma ci sono molti altri modi in cui questa tecnologia potrebbe essere utilizzata.

Perché la preoccupazione?

Questi tipi di sistemi hanno quasi sempre equità, responsabilità, trasparenza e difetti etici ("FATE") incorporati nella loro corrispondenza dei modelli. Per esempio, uno studio ha scoperto che gli algoritmi di riconoscimento facciale hanno valutato i volti dei neri come più arrabbiati dei volti bianchi, anche quando sorridevano.

Molti gruppi di ricerca si stanno occupando di questo problema ma appare chiaro a questo punto che il problema non può essere risolto esclusivamente a livello tecnologico. I problemi relativi al FATE nell'IA richiederanno uno sforzo continuo e concertato da parte di coloro che utilizzano la tecnologia per essere consapevoli di questi problemi e affrontarli. Come evidenzia il rapporto AI Now:"Nonostante l'aumento del contenuto etico dell'IA, i principi e le dichiarazioni etiche raramente si concentrano su come l'etica dell'IA può essere implementata e se sono efficaci". Rileva che tali dichiarazioni etiche dell'IA ignorano in gran parte le domande su come, dove, e chi metterà in atto tali linee guida. In realtà, è probabile che tutti debbano essere consapevoli dei tipi di pregiudizi e debolezze che questi sistemi presentano, simile a come dobbiamo essere consapevoli dei nostri pregiudizi e di quelli degli altri.

Il problema con i divieti tecnologici generalizzati

Una maggiore precisione e facilità nel monitoraggio persistente portano con sé altre preoccupazioni oltre l'etica. Ci sono anche una serie di problemi di privacy legati alla tecnologia generale, che vanno dalla proliferazione di telecamere che fungono da feed della polizia fino a rendere potenzialmente anonimi i dati sensibili.

Con queste preoccupazioni etiche e di privacy, una reazione naturale potrebbe essere quella di chiedere il divieto di queste tecniche. Certamente, applicare l'intelligenza artificiale ai risultati dei colloqui di lavoro o alle procedure di condanna penale sembra pericoloso se i sistemi stanno imparando i pregiudizi o sono altrimenti inaffidabili. Ci sono applicazioni utili però, ad esempio nell'aiutare a individuare i segnali di pericolo per prevenire il suicidio giovanile e nel rilevare i conducenti ubriachi. Questo è uno dei motivi per cui anche i ricercatori preoccupati, le autorità di regolamentazione e i cittadini hanno generalmente smesso di chiedere divieti generali sulle tecnologie legate all'intelligenza artificiale.

Combinazione di intelligenza artificiale e giudizio umano

In definitiva, i progettisti di tecnologia e la società nel suo insieme devono esaminare attentamente come le informazioni provenienti dai sistemi di intelligenza artificiale vengono iniettate nei processi decisionali. Questi sistemi possono dare risultati errati proprio come qualsiasi altra forma di intelligenza. Sono anche notoriamente incapaci di valutare la propria autostima, non diversamente dagli umani, anche in compiti più semplici come la capacità di riconoscere gli oggetti. Rimangono anche sfide tecniche significative nella lettura delle emozioni, in particolare considerando il contesto per inferire le emozioni.

Se le persone si affidano a un sistema che non è preciso nel prendere decisioni, gli utenti di quel sistema stanno peggio. È anche risaputo che gli umani tendono a fidarsi di questi sistemi più di altre figure autoritarie. Alla luce di questo, noi come società dobbiamo considerare attentamente l'equità di questi sistemi, responsabilità, trasparenza ed etica sia in fase di progettazione che di applicazione, mantenendo sempre un umano come decisore finale.

Questo articolo è stato ripubblicato da The Conversation con una licenza Creative Commons. Leggi l'articolo originale.