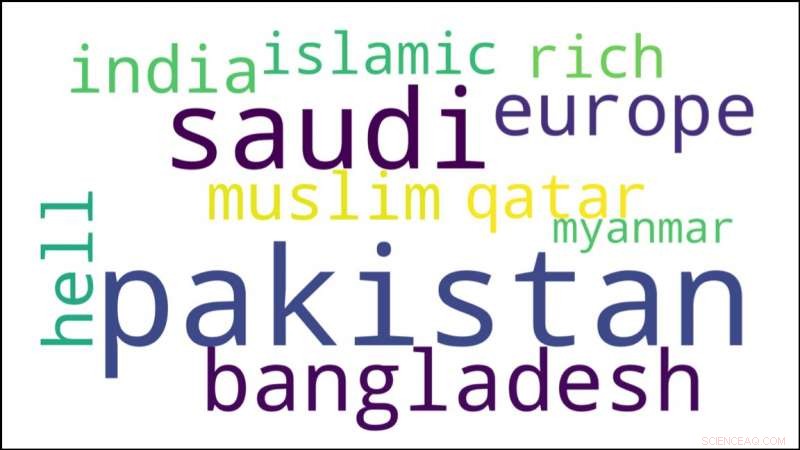

Questa nuvola di parole descrive le risposte sui social media alla domanda su dove dovrebbero andare i rifugiati Rohingya. Credito:Carnegie Mellon University

Completa la frase seguente:i rifugiati Rohingya dovrebbero andare a ... —

A. Pakistan.

B. Bangladesh.

C. Inferno.

Queste non sono buone scelte, ma sono tutti sentimenti che sono stati espressi ripetutamente sui social media. I Rohingya, che ha iniziato a fuggire dal Myanamar nel 2017 per evitare la pulizia etnica, sono mal equipaggiati per difendersi da questi attacchi online, ma le innovazioni del Language Technologies Institute (LTI) della Carnegie Mellon University potrebbero aiutare a contrastare l'incitamento all'odio rivolto a loro e ad altri gruppi senza voce.

I ricercatori di LTI hanno sviluppato un sistema che sfrutta l'intelligenza artificiale per analizzare rapidamente centinaia di migliaia di commenti sui social media e identificare la frazione che difende o simpatizza con le minoranze emarginate come la comunità Rohingya. Moderatori di social media umani, che non potrebbe assolutamente setacciare manualmente così tanti commenti, avrebbe quindi la possibilità di evidenziare questo "discorso di aiuto" nelle sezioni dei commenti.

"Anche se ci sono molti contenuti odiosi, possiamo ancora trovare commenti positivi, " ha detto Ashiqur R. KhudaBukhsh, un ricercatore post-dottorato nella LTI che ha condotto la ricerca con l'alunno Shriphani Palakodety. Trovando ed evidenziando questi commenti positivi, suggeriscono, potrebbe fare altrettanto per rendere Internet più sicuro, luogo più sano come rilevare ed eliminare contenuti ostili o vietare i troll responsabili.

Lasciati a se stessi, i Rohingya sono in gran parte indifesi contro l'incitamento all'odio online. Molti di loro hanno una competenza limitata nelle lingue globali come l'inglese, e hanno scarso accesso a Internet. La maggior parte è troppo impegnata a cercare di rimanere in vita per passare molto tempo a pubblicare i propri contenuti, KhudaBukhsh ha detto.

Per trovare un discorso di aiuto pertinente, i ricercatori hanno usato la loro tecnica per cercare più di un quarto di milione di commenti da YouTube in quella che credono sia la prima analisi incentrata sull'intelligenza artificiale della crisi dei rifugiati Rohingya. Presenteranno i loro risultati alla conferenza annuale dell'Associazione per l'avanzamento dell'intelligenza artificiale, 7-12 febbraio, nella città di New York.

Allo stesso modo, in uno studio non ancora pubblicato, hanno usato la tecnologia per cercare un "discorso di speranza" contro la guerra tra quasi un milione di commenti su YouTube che circondano l'attacco terroristico di Pulwama del febbraio 2019 in Kashmir, che ha infiammato la lunga disputa tra India e Pakistan sulla regione.

La capacità di analizzare tali grandi quantità di testo per contenuto e opinione è possibile grazie ai recenti importanti miglioramenti nei modelli linguistici, disse Jaime Carbonell, Direttore di LTI e coautore dello studio. Questi modelli imparano dagli esempi in modo da poter prevedere quali parole potrebbero verificarsi in una determinata sequenza e aiutano le macchine a capire cosa stanno cercando di dire oratori e scrittori.

Ma i ricercatori della CMU hanno sviluppato un'ulteriore innovazione che ha permesso di applicare questi modelli a brevi testi sui social media in Asia meridionale, Ha aggiunto. Brevi frammenti di testo, spesso con errori di ortografia e grammatica, sono difficili da interpretare per le macchine. È ancora più difficile nei paesi dell'Asia meridionale, dove le persone possono parlare diverse lingue e tendono a "commutare il codice, " combinare frammenti di lingue diverse e persino sistemi di scrittura diversi nella stessa dichiarazione.

I metodi di apprendimento automatico esistenti creano rappresentazioni di parole, o incorporamenti di parole, in modo che tutte le parole con un significato simile siano rappresentate allo stesso modo. Questa tecnica consente di calcolare la vicinanza di una parola ad altre in un commento o in un post. Per estendere questa tecnica ai testi impegnativi dell'Asia meridionale, il team CMU ha ottenuto nuovi incorporamenti che hanno rivelato raggruppamenti o cluster linguistici. Questa tecnica di identificazione della lingua ha funzionato altrettanto o meglio delle soluzioni disponibili in commercio.

Questa innovazione è diventata una tecnologia abilitante per le analisi computazionali dei social media in quella regione, Carbonell ha osservato.

I campioni dei commenti di YouTube hanno mostrato che circa il 10% dei commenti era positivo. Quando i ricercatori hanno usato il loro metodo per cercare il discorso di aiuto nel set di dati più ampio, i risultati sono stati positivi per l'88%, indicando che il metodo potrebbe ridurre sostanzialmente lo sforzo manuale necessario per trovarli, KhudaBukhsh ha detto.

"Nessun paese è troppo piccolo per accogliere i rifugiati, " ha detto un testo, mentre un altro ha sostenuto che "tutti i paesi dovrebbero prendere posizione per queste persone".

Ma rilevare testi pro-Rohingya può essere un'arma a doppio taglio:alcuni testi possono contenere un linguaggio che potrebbe essere considerato incitamento all'odio contro i loro presunti persecutori, Ha aggiunto.

Gli antagonisti dei Rohingya sono "molto simili agli animali, non agli esseri umani, ecco perché genocidiano persone innocenti, " ha detto uno di questi testi. Sebbene il metodo riduca gli sforzi manuali, commenti come questo indicano la continua necessità di giudizio umano e di ulteriori ricerche, hanno concluso gli scienziati.