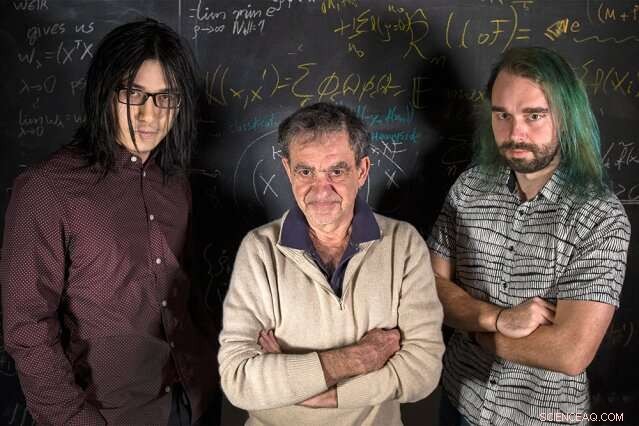

Ricercatori del MIT (da sinistra a destra) Qianli Liao, Tommaso Poggio, e Andrzej Banburski stanno con le loro equazioni. Credito:Kris Brewer

I corsi introduttivi di statistica ci insegnano che, quando si adatta un modello ad alcuni dati, dovremmo avere più dati dei parametri liberi per evitare il pericolo di sovradattamento, adattando troppo da vicino i dati rumorosi, e quindi non riuscendo ad adattare nuovi dati. è sorprendente, poi, che nel moderno deep learning la pratica è di avere ordini di grandezza più parametri che dati. Nonostante questo, le reti profonde mostrano buone prestazioni predittive, e infatti fanno meglio più parametri hanno. Perché dovrebbe essere?

È noto da tempo che le buone prestazioni nell'apprendimento automatico derivano dal controllo della complessità delle reti, che non è solo una semplice funzione del numero di parametri liberi. La complessità di un classificatore, come una rete neurale, dipende dalla misurazione della "dimensione" dello spazio delle funzioni che questa rete rappresenta, con più misure tecniche precedentemente suggerite:dimensione Vapnik–Chervonenkis, coprendo i numeri, o complessità Rademacher, per dirne alcuni. Complessità, misurato da queste nozioni, può essere controllato durante il processo di apprendimento imponendo un vincolo alla norma dei parametri, insomma su quanto "grande" possono diventare. Il fatto sorprendente è che nessun vincolo così esplicito sembra essere necessario nell'addestramento delle reti profonde. L'apprendimento profondo si trova al di fuori della teoria dell'apprendimento classico? Dobbiamo ripensare alle fondamenta?

In un nuovo documento di Nature Communications, "Controllo della complessità tramite gradiente di discesa nelle reti profonde, " una squadra del Centro per i cervelli, menti, e Macchine guidati dal regista Tomaso Poggio, l'Eugene McDermott Professor al MIT Department of Brain and Cognitive Sciences, ha fatto luce su questo enigma affrontando le applicazioni più pratiche e di successo del moderno deep learning:i problemi di classificazione.

"Per problemi di classificazione, osserviamo che infatti i parametri del modello non sembrano convergere, ma piuttosto crescono di dimensioni indefinitamente durante la discesa del gradiente. Però, nei problemi di classificazione contano solo i parametri normalizzati, cioè la direzione che definiscono, non la loro dimensione, ", afferma Qianli Liao, coautore e candidato al Ph.D. MIT. "La cosa non così ovvia che abbiamo mostrato è che la discesa del gradiente comunemente usata sui parametri non normalizzati induce il controllo di complessità desiderato su quelli normalizzati".

"Sappiamo da tempo nel caso della regressione per reti lineari poco profonde, come macchine kernel, che le iterazioni della discesa del gradiente forniscono un implicito, effetto di regolarizzazione evanescente, " dice Poggio. "Infatti, in questo semplice caso probabilmente sappiamo che otteniamo il margine massimo che si comporta al meglio, soluzione a norma minima. La domanda che ci siamo posti, poi, era:può succedere qualcosa di simile per le reti profonde?"

I ricercatori hanno scoperto che lo fa. Come spiega il coautore e postdoc del MIT Andrzej Banburski, "Comprendere la convergenza nelle reti profonde mostra che ci sono direzioni chiare per migliorare i nostri algoritmi. Infatti, abbiamo già visto suggerimenti sul fatto che controllare la velocità con cui questi parametri non normalizzati divergono ci consente di trovare soluzioni più performanti e trovarle più velocemente."

Cosa significa questo per l'apprendimento automatico? Non c'è magia dietro le reti profonde. Anche qui è in gioco la stessa teoria alla base di tutti i modelli lineari. Questo lavoro suggerisce modi per migliorare le reti profonde, rendendoli più precisi e più veloci da addestrare.

Questa storia è stata ripubblicata per gentile concessione di MIT News (web.mit.edu/newsoffice/), un popolare sito che copre notizie sulla ricerca del MIT, innovazione e didattica.