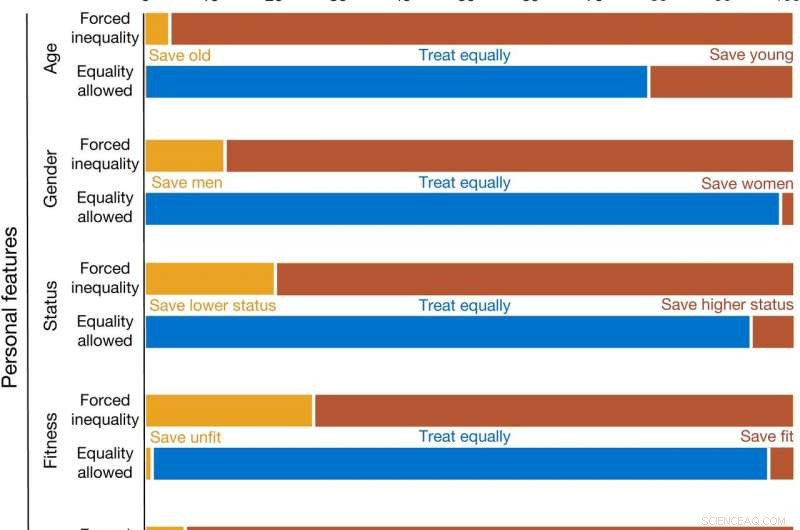

Le scelte delle persone su come i veicoli autonomi dovrebbero essere programmati per agire in situazioni in cui sono in gioco vite umane (studio 1). Credito: Natura (2020). DOI:10.1038/s41586-020-1987-4

Una coppia di ricercatori dell'Università della Carolina del Nord a Chapel Hill sta contestando i risultati del team che due anni fa ha pubblicato un documento chiamato "L'esperimento della macchina morale". Yochanan Bigman e Kurt Gray affermano che i risultati dell'esperimento erano imperfetti perché non consentivano ai partecipanti al test di scegliere di trattare allo stesso modo le potenziali vittime.

Già nel 1967, Il filosofo britannico Phillippa Foot ha descritto il "problema del carrello, " che presentava uno scenario in cui un carrello correva verso le persone sui binari che stavano per essere uccise. Il conducente del tram ha la possibilità di prendere un binario laterale prima di colpire le persone, tuttavia, quella traccia è popolata, anche. Il problema pone quindi dilemmi morali per il conducente, come se sia più ragionevole uccidere cinque persone contro due, o se sia preferibile uccidere i vecchi contro i giovani.

Due anni fa, un team del MIT ha rivisitato questo problema nel contesto della programmazione di un veicolo senza conducente. Se tu fossi il programmatore invece del conducente del tram, come programmeresti l'auto per rispondere in una varietà di condizioni? La squadra ha riferito che, come previsto, la maggior parte dei volontari che hanno fatto il test programmano l'auto per investire animali piuttosto che persone, anziani al posto dei giovani, uomini piuttosto che donne, ecc. In questo nuovo sforzo, Bigman e Gray stanno contestando i risultati del team del MIT perché suggeriscono che le risposte non rappresentano veramente i desideri dei volontari. Suggeriscono che non dare agli esaminandi una terza opzione - trattare tutti allo stesso modo - ha distorto i risultati.

Per scoprire se dare agli utenti una terza risposta ha portato a risultati più egualitari, i ricercatori hanno condotto un esperimento simile a quello del MIT, ma ha dato agli utenti la possibilità di scegliere di non mostrare alcuna preferenza su chi sarebbe stato investito e chi sarebbe stato risparmiato. Hanno scoperto che la maggior parte dei volontari ha scelto la terza opzione nella maggior parte degli scenari. Suggeriscono che i loro risultati indicano che i test di scelta forzata non rivelano i veri desideri del pubblico in generale.

© 2020 Scienza X Rete